在现代软件开发的世界里,性能优化往往被视为提升产品竞争力的关键环节。无论是大型游戏引擎、复杂的图形渲染,还是企业级应用系统,开发者们都渴望通过调优代码来实现更快的响应速度和更顺畅的用户体验。然而,优化虽美好,却不是没有风险的迷宫。盲目或错误的优化不仅难以取得预期效果,有时甚至会导致性能下降、维护难度增大和隐蔽的bug产生。本文将深入剖析“优化伪装”的种种误区,强调科学优化流程的重要性,并通过实际案例带来启示,帮助广大开发者明辨真伪优化,实现理性高效的性能提升。首先,必须明确的是,任何优化行为都应以代码功能正确为前提。

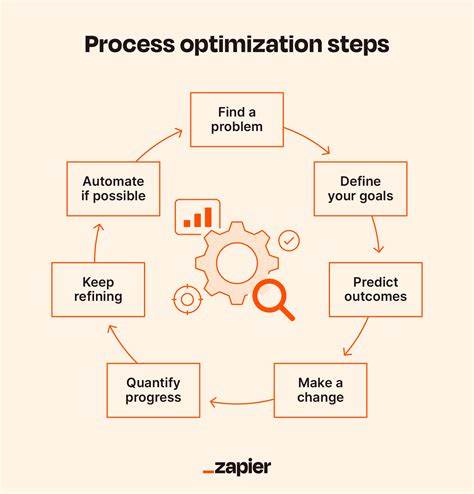

只有在代码核心功能稳定且经过严格测试验证后,才应启动优化步骤。否则,所谓的优化将无异于在摇摇欲坠的建筑上施加粉饰,不仅徒劳无功,更可能埋下巨大的隐患。确保测试的覆盖率和准确性,是保护产品质量的基本屏障。接下来,优化的出发点应建立在科学的数据基础上。这意味着开发者需要对目标代码在典型甚至极端场景下的性能表现进行精确测量和分析。借助性能分析工具采集响应时间、内存占用、CPU使用率等指标,掌握代码瓶颈所在。

过于主观或经验化的判断往往误导方向,导致投入的人力物力浪费殆尽。只有清楚“问题在哪里”,才能“针对问题下药”。此外,测量过程中必须保证数据的稳定性和可重复性。波动较大的测试结果会掩盖真实的性能瓶颈,给决策带来误导。理想情况下,应在多组测试中观察平均值和峰值表现,尤其反复验证在实际产品运行条件下的表现。基于充分的测试结果,开发者才能判断是否真的需要优化,或优化到何种程度。

没有明确的性能目标和需求作为底线,任何优化都可能陷入无效的折腾。在真实开发流程中,应记录每次优化前后的性能指标,并对改动的影响进行科学评估。只有获得了显著且符合预期的提升,同时不牺牲代码的可维护性和准确性时,此次优化才算得上成功。否则,得不偿失。即使是在游戏行业,那种为了追求极致帧率而牺牲代码质量的做法,也必须在团队权衡利弊后慎重决策。优化并非越快越好,它的复杂性和后续维护成本都可能让项目陷入被动。

更为重要的是,优化必须以保证功能正确为底线。许多开发者在未充分验证代码正确性的情况下,匆忙调整算法或数据结构,结果导致程序运行出现细微甚至致命错误。这种“优化不优化”的行为,反而降低了产品的稳定性和信任度,从长远看极为不利。一个著名的反面案例来自于Maya的COLLADA导出插件。在该插件中,有一段负责缓存节点采样结果的代码,原本设计合理,基于对象和属性两级索引实现缓存,时间复杂度较低且代码结构清晰。然而,为了所谓提升查找性能,某位开发者引入了一个缓存指针变量试图加速查询。

该“优化”没有经过充分的性能测量,也没有执行事后对比。结果因缓存指针没有被正确更新,导致程序未能正确插入新节点,缓存只保留了一个节点的属性列表,所有其他节点的属性全部混入该列表中。此举使得代码整体性能从线性退化成了二次方,导出大型场景时耗时显著增加。此问题直到经验丰富的工程师介入定位,才得以纠正。该事件生动说明,没有科学的性能分析作为支持,盲目微观优化极易成为性能杀手。此外,优化还应该遵循逐步改进、持续监控的原则。

每完成一项优化,应立即运行回归测试验证功能完整性,确保未引入新的问题。同时,重新进行性能测试,确认提升效果真实存在,而非偶然波动。通过记录各阶段的性能数据,开发团队能够回溯历史决策,识别出真正有效的优化措施。优化决策的透明化和数据支持,有助于团队成员理解取舍,避免过度或不足的优化行为。值得一提的是,优化并不总是意味着代码越复杂越好。有时,为性能大幅牺牲代码的可读性和可维护性,极易导致后续迭代成本攀升,甚至引发更多难以察觉的缺陷。

因此在优化策略中,应优先考虑易于实现、对结构影响较小的方法。只有当某个瓶颈确实影响产品用户体验时,才逐步引入更激进的方案,且务必保证代码测试和文档完备。最后,优化文化应该植根于科学、严谨和持续改进的精神中。开发团队需要定期使用性能分析工具审视代码表现,即便当前运行表现尚可。这样不仅帮助发现潜在瓶颈,还能积累经验,避免被忽视的低效模式赖以生存。性能优化不应成为急功近利的孤立行动,而应融入日常开发流程,成为质量保障和创新的重要组成部分。

综上所述,无效优化的最大障碍在于缺乏科学的度量和验证机制。盲目跟风,草率改动,忽视功能回归测试,将导致性能下降和代码复杂度攀升。通过树立严谨的优化观念,遵循系统化的测量、分析和验证流程,开发者不仅能够避免“优化陷阱”,也能打造出高效、稳定且易维护的软件产品。性能提升是一场持久战,而不是一时冲刺。理性优化将是软件工程迈向卓越的必由之路。