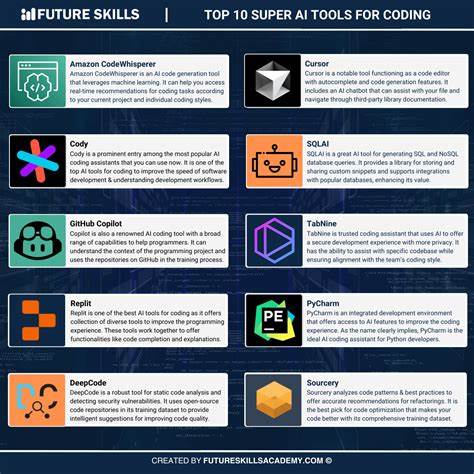

在现代软件开发领域,追求更高效、更智能的开发工具一直是开发者和企业的共同目标。传统的软件开发流程通常是由需求到代码,代码完成后再进行测试,如遇到问题再修复。这样的流程虽然经过长期实践,但仍然存在一定的被动和低效之处。随着人工智能技术的不断突破,业界开始探索一种新的开发范式:从需求出发,先自动生成测试用例,再生成通过测试的代码,从而实现全流程自动化和高质量软件交付。近年来,基于人工智能的代码生成工具如Cursor、GitHub Copilot等逐渐进入开发者视野,帮助程序员加速代码编写过程。然而,这些工具大多依赖于需求直接生成代码,出现错误时再由开发者调试和修复。

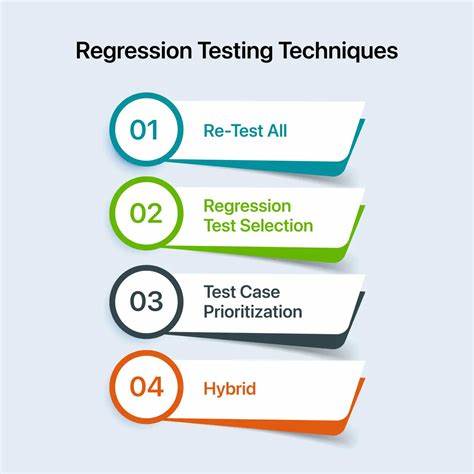

这种模式仍属于“需求——代码——修补”的被动循环,容易因需求理解偏差或代码逻辑错误带来额外成本。基于此,部分开发者提出了更加主动和结构化的开发思路,即先从需求自然语言描述中自动推导出对应的测试用例,然后让AI根据测试用例生成代码,之后自动执行测试并反馈结果。这种从“需求→测试→代码”流程的工具,无疑将软件开发推向了一个全新的高度。首先,这种方法的优势在于严格落实软件测试驱动开发理念(TDD)。测试用例是开发过程中定义功能目标和质量标准的具体表达,确保代码生成时“知其所对”。自动生成的测试用例可以覆盖关键需求,避免遗漏或误解,帮助AI生成更符合预期的代码。

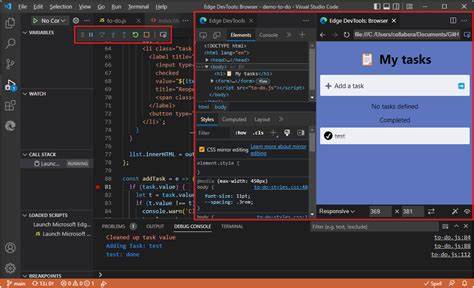

同时,自动执行测试环节可以第一时间反馈错误,减少传统开发中长时间调试的痛苦。其次,该模式有可能极大地提升开发效率。开发者只需提供清晰的需求描述,无需编写复杂的测试代码或手动调试细节,AI工具即可自动完成测试和代码生成工作。对于初创团队、独立开发者以及资源有限的组织尤其具有吸引力,因为大幅降低了测试和编码技术门槛。同时,自动化工具结合集成开发环境(例如VSCode扩展)和强大的后台编排系统,可以实现无缝衔接、实时交互,极大地优化用户体验与开发流程。再次,这种方法有潜力提高代码质量和软件稳定性。

由于代码的生成是以自动生成的测试用例为准绳,功能覆盖和边界条件测试更充分,降低人工漏测风险。此外,持续测试反馈机制保障代码符合需求,避免因需求模糊或写代码时的理解误差而导致的缺陷积累。虽然“需求→测试→代码”模式展现出诸多优势,但其广泛应用仍面临多方面挑战。首要挑战是自然语言需求的准确理解。需求本身常常存在表达模糊、上下文隐含等问题,如何让AI准确、全面地转换为有效测试用例,是关键技术难点。其次,测试用例生成的覆盖面和精度直接影响代码质量,当前AI系统生成测试用例的能力尚未完全成熟,需要进一步优化。

此外,AI生成代码的质量和效率也受限于底层训练数据和模型能力,仍可能出现无法预见的错误和安全隐患。再者,开发者对于自动化生成代码和测试的信任度还需培养。许多资深工程师习惯于自主编写测试脚本和代码,自动生成的流程可能让部分人感到缺乏控制感和透明度,阻碍工具的快速普及。为此,开发团队需要设计便捷的人工干预和调整功能,加强测试和代码的可解释性,提升用户体验和安全信心。目前市面上已经出现一些初具雏形的工具和项目,如Cursor与GitHub Copilot在代码生成方面提供便利,AutoGPT和LangChain等架构支持更复杂的多步骤任务执行。未来,将这些工具整合并完善需求到测试再到代码的全流程自动化,将是行业发展的重要方向。

一旦成熟,企业不仅能节省大量开发时间和成本,还能保持更高的软件质量和客户满意度,增强市场竞争力。对于广大软件从业者而言,理解并掌握这一新的开发范式,将有助于顺应时代潮流,提升自身技术竞争力。与此同时,人工智能辅助的开发工具也将不断迭代更新,支持更多语言、框架和应用场景,进一步扩大其适用范围和影响力。综上所述,由需求驱动,自动生成测试用例,再基于测试代码自动完成的软件开发工具,将为软件工程领域带来新的变革机遇。虽然仍需克服技术和认知挑战,但其潜力不可小觑。随着AI能力提升和工具生态完善,未来的软件开发将更加智能、高效且可靠。

开发者、企业和整个行业应积极关注这一趋势,抓住时代赋予的创新红利,共同推动软件开发进入新时代。