在Python数据序列化领域,Pickle作为一种原生协议被广泛使用。它常被误解为慢速序列化的代表,然而事实远非如此。真正影响序列化效率的是具体实现和使用方式,而非协议本身。理解这一点,对于Python开发者,尤其是从事实时数据传输、分布式计算与深度学习模型管理的工程师极其关键。 Pickle作为Python内置的序列化机制,最初设计目的是在Python进程间传递对象。它具备直接将Python对象转换成字节流的能力,使得数据在不同环境和进程间的传输极为便利。

Pickle协议本身的设计足够轻量和直接,性能上几乎达到了内存复制的上限。与此同时,Pickle并非完美协议,它在安全性、跨语言兼容性和随机访问方面存在局限。因此,开发者应谨慎选择序列化协议以配合具体应用场景。 近年来,随着深度学习框架的兴起和分布式计算需求的激增,PyTorch模型在多节点、多进程间高效传输成为痛点。一场围绕"PyTorch使用Pickle序列化模型缓慢"的争论引发了广泛关注。Dask作为一个主流分布式计算框架,其用户报告通过Pickle传输PyTorch模型时,速度极慢,GPU模型约1MB每秒,CPU模型约50MB每秒,严重拖慢了整体计算流程。

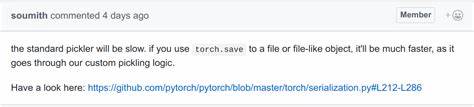

深入分析发现,这并非Pickle协议设计导致的速度瓶颈,而是在PyTorch模型对象的__reduce__方法中,将张量转为Python列表的实现方式存在重大性能缺陷。具体而言,原有实现利用tolist()强制将Tensor转换成纯Python数据结构,这个操作极大拖慢了序列化速度,远低于硬件传输带宽能力。 理解Pickle的__reduce__机制对于解决该问题至关重要。__reduce__方法定义了一个对象如何通过Pickle协议序列化和反序列化。设计合理的__reduce__不仅保证对象准确重建,更会决定序列化性能的高低。通过改写PyTorch张量的__reduce__方法,引入torch.save和torch.load这对高效的保存与加载函数,将Tensor直接转为紧凑二进制流,极大提升了数据序列化带宽,可达到1GB每秒以上的水准。

此举不仅节省了转换时间,还保证了数据结构的完整性和一致性。 这个优化的意义不仅仅体现在PyTorch和Dask的协同使用。它象征着Python生态系统中使用标准协议和接口的重要性。面对庞大而多样的第三方库,建立统一且高效的协议实现,使得组件无缝对接,性能瓶颈能够被快速定位和解决,最终推动生态系统整体的进步和健壮。 此外,针对高性能需求,特殊硬件和通讯协议的支持尤为突出。例如在多进程训练中,PyTorch自定义序列化将张量搬移到共享内存空间,避免了冗余拷贝,不仅极致加速了传输效率,也保留了张量视图关系,这是纯Pickle协议难以实现的。

这表明专用高性能序列化选项在极端场景中依然不可或缺。 然则专用方案不可避免地带来了学习成本和复杂度,且可能导致库之间的耦合,限制了生态的灵活性和扩展性。因此,在大多数常规应用场景下,充分优化和利用标准协议的重要性不容忽视。它代表着生态系统的"通用语言",帮助开发者和库维护者更轻松地维护兼容性和性能。 对开发者而言,理解并掌握Pickle协议的底层机制,善用__reduce__实现自定义序列化,是提升应用性能的有力武器。无论是在分布式计算任务、数据持久化,还是深度学习模型的分发中,合理设计序列化逻辑可显著降低延迟,提高处理吞吐量。

综上所述,Pickle作为协议并不慢,性能瓶颈往往源于协议实现细节。PyTorch和Dask案例生动展示了通过协议实现优化如何带来指数级的性能飞跃。未来,随着Python生态的不断扩大和多样化,对Pickle协议及其定制机制的理解和优化必将成为开发者提升整体应用效率的关键所在。掌握这一核心理念,方能在瞬息万变的技术浪潮中,游刃有余,推动技术创新与应用发展。 。