近年来,人工智能特别是大语言模型(LLM)技术的兴起,极大地推动了自然语言处理、自动化办公、内容创作等诸多领域的发展。然而,面对不同供应商提供的多样化模型和平台,用户在选择和调用这些模型时往往面临兼容性和上下文处理复杂度的大挑战。恰恰在这时,Clai(读作/klaɪ/,类似于“cli”)作为一款命令行上下文喂入工具脱颖而出,它秉承Unix哲学设计,具备跨供应商兼容性,帮助用户高效管理和调用多种LLM模型。 Clai是一种开源工具,旨在通过命令行界面为各种AI任务提供上下文输入支持,使得多种大语言模型能够无缝协作。Clai支持的供应商包括OpenAI、Anthropic、Mistral、Deepseek等多个主流厂商,用户只需配置相应API密钥,即可调用所需模型。如此设计大大打破了厂商之间的壁垒,保障了灵活性与扩展性。

Clai遵循经典的Unix哲学,强调“做一件事,做好”,专注于提供优质的上下文管理功能,而非单纯成为一个调用接口。它支持典型的Unix数据管道,可以与其他命令行工具无缝结合,实现数据的流畅传递和处理。这意味着用户可以利用丰富的Unix工具链,将文本数据进行预处理、过滤、格式化后输入Clai,再将结果输出至另一个过程,实现极为灵活的工作流构建。 除了基础的上下文喂入,Clai还具备多样功能以提升使用体验。例如它支持多轮会话管理,用户能够持续保存和延续对话的上下文,提升交互的连贯性和智能表现。同时,Clai提供“速率限制绕过”机制,通过自动摘要和回忆复杂任务,减少了对API调用频率的限制,增强了系统的稳定性和效率。

此外,系统允许用户定义“配置文件”,预设各类输入提示和行为,从而定制个性化的操作流程和智能代理。 这种多功能融合使Clai不仅适用于开发者日常探索与调试,也适合企业级应用场景。无论是客服机器人、文本生成、信息抽取,还是复杂的自然语言理解任务,Clai都能作为上下文引擎,为不同品牌和版本的语言模型提供统一的接口和管理框架。 从技术实现角度看,Clai主要由Go语言编写,保证了高性能和跨平台支持。项目的测试覆盖率虽处于中等水平,但随着社区的持续贡献,品质和功能日益完善。通过简单的命令即可安装与配置Clai,例如通过Go生态的包管理工具或者官方提供的脚本一键部署,极大降低了入门门槛。

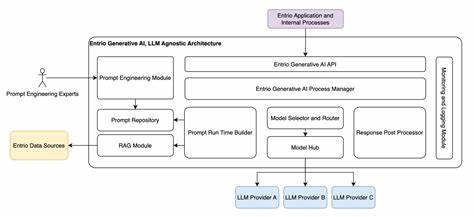

纵观整个大语言模型的发展路线,跨供应商兼容性始终是开放与创新的关键所在。不同厂商的模型具备各自优势,用户往往需要根据任务需求灵活选择最适合的模型。同时,复杂任务对上下文的依赖极强,如何保障上下文的有效传递与管理成为影响模型效果的核心因素。Clai正是在此背景下提出解决方案,使得用户可以自由组合模型和上下文工具,打造符合个性化和多变需求的智能系统。 另外,Clai的Unix范式不仅提升了操作的熟练度和可组合性,也方便集成现有基础设施。无须复杂图形界面或专属软件,开发者只需熟悉终端与脚本,即可构建自动化管线,极大地提升了效率和灵活度。

此外,命令行工具的轻量特性也适合云端部署和远程调用,满足现代分布式计算环境的需求。 在使用体验方面,Clai还建议搭配Glow等工具以获得优雅的Markdown格式输出,提升终端交互时的可读性和可视化效果。用户社区也活跃积极,已发布多版本迭代和应用示例,为新用户提供丰富的参考资料和实践样例。 总结来看,Clai作为一款Unix风格的跨供应商LLM上下文喂入工具,具有极高的实用价值和潜力。它通过开放设计支持多种主流AI厂商,兼顾灵活性和高效性,满足了现代AI场景对上下文管理和多模型调用的双重需求。未来,随着大语言模型技术的持续进步和应用多样化,Clai有望成为连接不同模型生态的重要桥梁,推动人工智能工具链更加开放协同和智能高效。

对于关注AI模型集成、命令行工具及自动化工作流的开发者和企业用户而言,Clai无疑是一款值得深入了解和尝试的宝贵工具。它不仅提升了跨厂商使用体验,也推动了AI应用的模块化与标准化进程,助力智能时代的创新和发展。