在当代人工智能快速发展的背景下,检索增强生成技术(Retrieval-Augmented Generation,简称RAG)作为一种将外部知识检索与文本生成有效结合的方法,正日益受到广泛关注。RAG通过从知识库检索出相关信息段落,然后利用生成模型基于这些内容产生准确且详细的回答,极大提升了问答系统和智能助手的实用性。而在这一流程中,重排序器的角色不可或缺,尤其是以大型语言模型(LLM)为核心的重排序方案,为检索结果的相关性排序带来了质的飞跃。LLM重排序在RAG系统中的应用不仅提高了答案的准确度和上下文相关性,也推动了生成模型输出的可信度和用户体验的提升。本文将全面解析LLM重排序的工作原理及其优化技术,帮助读者深入了解如何在实际工作中高效利用该技术。首先,理解RAG中的重排序机制至关重要。

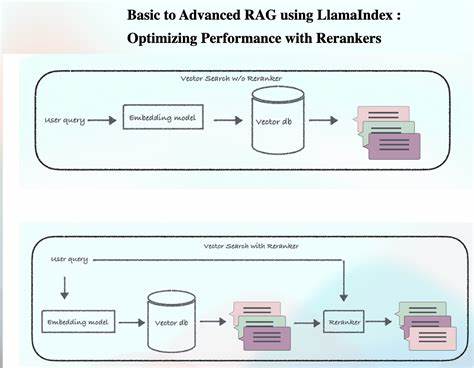

RAG系统通常通过向量搜索技术从海量文档索引中筛选出与用户查询最相关的top-K段落,这为后续生成阶段提供了基础语义支持。然而,向量搜索基于数据嵌入相似度,难免受到噪声信息和语义歧义的影响,导致返回的段落排序并非最优。此时,重排序器介入,对首轮检索结果进行重新评分与排列,以实现更精确的相关性排序,保证生成模型以更契合用户意图的内容作为上下文。传统的重排序方法多采用开源的交叉编码模型(cross-encoder),它们因速度快、集成简便而广受使用,但在实际应用中常面临准确率不足以满足高标准需求的问题。相较之下,以LLM为核心的重排序器利用其深厚的语言理解和推理能力,能够更细致地捕捉查询与候选段落之间的语义关系,有效提升排序质量。LLM重排序的核心思想是对向量搜索返回的top-K段落,逐条或批量进行相关性评分,生成基于深度语义分析的排序结果。

根据提示设计的不同,LLM重排序大致分为点对点(pointwise)、列表级(listwise)和两两比较(pairwise)三种方式。点对点方式直接对每个段落打分,适合生成清晰分数且易于后续处理。列表级方法让模型一次性为整个列表排序,理论上能捕获整体关系但计算资源消耗更大。两两比较则通过模型对段落对的相关性判断构建排序,尽管理论上质量最高,但由于对算力的要求极高,实际应用较少。从工程实用角度,点对点重排序因其简单明了和便于优化的优势而被广泛采用。然而,初始实现中常遇到的问题包括输出Token数过多导致延迟增加、模型偶尔对输出格式或评分出现错乱以及输入的段落数量和长度使得提示过于庞大,导致整体处理速度降低。

针对此类挑战,采取减少输出Token和并行化处理成为提升效率的关键。减少输出Token包括通过简化输出格式、去除多余空格以及采用阈值筛选,将评分低于一定值的段落在结果中忽略,大幅度减少了模型生成内容的长度,从而降低延迟并节省计算资源。这些微小而有效的改进为系统性能带来了显著提升。并行化技术则将整体段落集合拆分成多个子批次,分配给不同的模型调用并发处理。考虑到输入的段落在向量搜索中是按语义相似度排序的,简单地连续划分批次容易导致某些批次获得大部分高相关性段落,造成评分上的偏差。采用轮询分配策略,确保每个批次包含不同层级的相关度段落,有效缓和了输入的排序偏置。

多批次结果合并时,通过聚合所有评分并使用交叉编码模型打破并列与补充缺失评分,确保最终排序的准确与完整。值得注意的是,并行化虽提升效率,但也引入了评分尺度漂移和延迟尾部风险。为此,需设计统一的评分标准与案例示范,校准模型评分一致性,同时对超时调用设置严格控制和降级策略,保障系统稳定性和响应速度。在实际应用中,如金融智能客服和Copilot等平台均已成功部署基于LLM的重排序方案。在金融场景,经过多轮优化的LLM重排序将初期五秒级的额外延迟压缩至不足一秒,同时成本下降八倍以上,且经A/B测试验证,提升了用户查询解决率与答案满意度。Copilot系统则通过实体类型识别与多流检索策略,结合LLM重排序提升了助理的援助率和回答率,同时优化了引用多样性,减少了对历史对话重复内容的依赖,推动了更权威内容的展现。

针对点对点与列表级重排序的效能对比实验显示,虽然列表级法理论优势明显,但在实际环境下带来更高的运算成本和延迟,而未获得明显质量提升,点对点重排序因此成为更加务实的选择。经过实践总结,LLM重排序显著提升了重排序质量,为检索增强生成系统赋能,但需要在模型调用成本、延迟和系统复杂性之间找到合适的平衡。为进一步优化性能,许多团队开始利用LLM重排序作为教师模型,训练专用定制重排序器,在保持高质量的同时降低在线推理延迟。此外,设计详尽且清晰的提示词对获得高质量评分结果同样关键。示例中,将评分分为十个等级,明确每个等级的定义,从"异常匹配"到"无关内容",引导模型更准确地量化段落相关性。同时要求输出为无空格且仅包含相关评分的JSON格式,避免额外文字干扰评分解析。

未来,随着大模型算力成本的进一步下降和并行推理技术的成熟,LLM重排序将在更多RAG系统中发挥积极作用。同时,结合多模态与跨语言的检索场景,重排序策略也将迎来新的发展机遇。机器学习研究者与工程师应持续关注重排序技术在实际落地中的关键细节与优化路径,推动智能问答系统向更自然、高效和可信的方向演进。综上所述,LLM重排序作为RAG系统的重要组成部分,不仅提升了检索结果的相关性排序水平,也极大地推动了下游生成模型输出的质量保障。通过合理设计提示词、减少输出冗余、并行分批处理及评分校准等技术手段,可以在实际工程环境下实现性能与质量的最佳兼顾。结合实际应用经验和技术反思,未来的研发工作重点将聚焦在定制重排序模型的训练及系统稳定性的保障,期待这一领域带来更多创新突破。

。