随着人工智能、大数据和高性能计算的迅猛发展,图形处理单元(GPU)在计算领域的重要性日益凸显。GPU不仅仅是一种图形渲染加速器,更成为支持并行计算和加速各种复杂任务的核心计算引擎。然而,在众多挑战中,GPU内存一致性作为保障并行程序正确性与高效性的基石,始终是研究和实践中的焦点话题。理解和掌握GPU内存一致性的规范、测试手段及其在性能工具上的应用,对于推动GPU计算性能提升和开发效率具有关键意义。GPU内存一致性问题涉及到多个线程及硬件单元之间如何观察和同步对内存的访问,这其中不仅包含硬件底层架构设计的复杂机制,也涉及编译器优化、运行时环境与开发工具的支持。过去十多年,随着CUDA、Vulkan、HIP和Metal等GPU编程接口的普及,厂商和学术界不断完善内存模型规范,将散乱的同步规则系统化、形式化,这为后续自动化验证和优化工具的发展奠定了坚实基础。

GPU的线程层级结构和同步粒度多样性也是内存一致性设计的一大挑战。GPU线程从Warp到Threadblock再到Grid的层次划分,使得同步机制必须能灵活支持局部和全局范围的内存访问顺序约束。在CUDA中,开发者可以选择线程级、线程块级乃至设备级的原子操作以及不同作用域的内存栅栏(fence)来实现数据访问有序,这样既保证了程序行为的正确性,也为性能调优提供了丰富空间。例如,块作用域的同步栅栏执行效率显著高于设备作用域,这意味着在保证正确的前提下,合理缩小同步作用域能够有效提升程序运行效率。针对GPU内存模型的规范,早期主要依赖的是自然语言描述和一系列经典的Litmus Tests。随着对多种硬件平台深入研究及实际应用中发现的特殊行为,社区开始采用形式化方法描述GPU的内存模型。

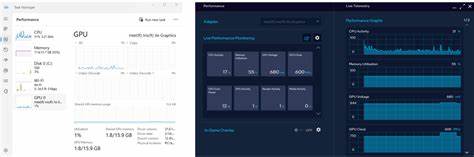

例如,NVIDIA推出了针对PTX指令集的形式规范,Khronos基金会也为Vulkan图形和计算API制定了GPU内存模型的系统化规范。这些规范通常会通过模型检查器和自动验证工具进行验证,确保内存访问的可重排序情形和禁止状况均被正确捕捉。GPU内存模型的测试经历了从传统CPU的技术借鉴,到针对GPU硬件特性的独特发明。测试工具如GPUHarbor利用WebGPU平台,使开发者能够在各种不同GPU硬件上运行内存一致性测试,实时观测内存操作的实际排序情况。通过高强度并发和混合数据访问模式的测试,这些工具能够揭示相对罕见但可能致命的内存重排序风险,帮助厂商及时发现实现缺陷,同时推动API设计的改进。性能优化工具方面,一项最新备受关注的研究是MICRO 2024发表的ScopeAdvice项目。

该项目聚焦于消除GPU程序中因过度同步带来的性能浪费,利用静态分析和程序行为模拟建议开发者采用更精细粒度的同步策略。ScopeAdvice揭示过度或不必要的设备作用域同步,导致性能大幅降低,同时通过实证验证了块作用域同步在某些场景下能达到相似的内存可见性但效率更高。然而,ScopeAdvice的部分优化提出了新的内存模型正确性疑问,尤其是在跨线程块同步的边界条件上。后续基于Dartagnan等形式化工具的分析表明某些情况下块级同步无法完全替代设备级同步,因为多线程块间通信涉及硬件层面缓存一致性的复杂保证。尽管如此,实验中在包含控制依赖的循环结构下,硬件和编译器的微架构实现往往提供了额外的顺序保证,弥补了模型上的差距。GPU内存一致性领域的挑战和机遇并存。

如何在确保程序正确性的前提下,发掘更细粒度同步的性能空间,是当前研究社区的热点。多种工具的融合使用成为趋势,静态性能分析、形式模型验证和实际硬件测试相辅相成,合力推动GPU开发生态的成熟。展望未来,持续完善GPU内存模型规范,加强跨厂商硬件的统一测试套件建设,以及打造智能化性能建议工具,将成为提升GPU并行程序开发效率和执行效率的关键。随着GPU应用范围的不断扩大,内存一致性相关的研究和工具创新必将为高性能计算、人工智能训练推理以及大规模图形渲染等领域带来更为坚实的技术保障。