当人工智能助手进入日常工作与生活之后,人们开始问一个看似尖锐但又现实的问题:频繁依赖ChatGPT,会不会让我们变笨?这是一个既有心理学、神经科学背景,也涉及时代伦理与工作习惯的问题。答案不是简单的二选一。人工智能既带来了巨大的效率红利,也对我们维持某些技能提出挑战。关键在于我们如何使用它,是让工具成为我们的拐杖,还是把它当作放大与训练思维的镜子。 用或失去:神经可塑性给出的警告 "用进废退"这句出自神经科学的古老箴言,提醒我们大脑的连接需要被反复激活才能维持。无论是语言表达、逻辑推理,还是记忆与问题解决能力,长期不练习都会导致强度和灵活性的下降。

把信息处理、写作和翻译这些任务长期交给ChatGPT来完成,就可能减少我们对相关神经回路的自我刺激,从而降低熟练度。这并不意味着AI本身是毒药,而是说明了行为模式会对大脑结构与功能产生实际影响。 研究和观察也提供了佐证。有研究发现,学生在过度依赖生成式AI写作或解题时,其深度思考和文本原创性表现出现下降趋势;企业中盲目服从AI建议而缺少人为核查则可能导致严重错误。那些把AI当作唯一答案来源的人,往往丧失了对信息来源进行批判性评估的习惯,从而在面对复杂或异常情境时处于被动状态。 人工智能的好处:为何我们愿意依赖它 要全面看待问题,不能只看到风险。

ChatGPT和其他大型语言模型在信息检索、初稿生成、语言润色、创意触发等方面提供了显著的效率提升。对于记者、创作者、程序员和市场人员来说,AI能在短时间内输出大量结构化信息、建议和方案,节省重复劳动,让人把精力投向更高层次的判断与创作。更重要的是,AI在很多时候降低了入门门槛,让非专业者也能完成以前需要专业训练才能做到的任务。 此外,AI可以是一个及时的"思维伙伴"。通过和模型进行对话,人们可以更快暴露逻辑漏洞、生成替代方案,或获得新颖的表达方式。良性使用会促使个体把AI作为扩展思路的工具,而不是替代大脑的黑匣子。

什么时候会"变笨"?辨认风险信号 并非所有使用AI的情形都会导致能力衰退。关键在于使用的方式与频率。当个人逐渐放弃主动思考,直接复制AI输出,甚至不再验证其合理性时,问题就发生了。以下几类行为尤其值得警惕。第一是无意识的认知外包,把记忆、推理甚至价值判断一并交给模型而不加反思。第二是习惯性的懒惰写作,把润色、结构重组完全交给AI,久而久之原创性能力下降。

第三是在专业场景中盲目信任AI建议,没有建立起二次核查或专家审定流程。 这些行为会让我们在遇到新问题时更难生成解决方案,因为曾经被锻炼的认知肌肉失去了强度。相对而言,那些把AI当作辅助、并坚持练习基本技能的人,反而能通过人机协作实现能力的提升。 如何在享受便利的同时保护认知能力 制定边界是应对风险的第一步。设定"AI使用策略"并非要回到全部手工处理的原始状态,而是要让人工智能的介入有原则、有目标。例如可以把AI用于资料整理、初步构思和风格润色,但在最后的事实核验、价值判断和核心创意上保持人为主导。

把AI视为"快速原型机",而非最终裁判。 另一个重要策略是有意识的练习。定期给自己安排不依赖AI的任务,比如把AI生成的内容关掉后独立写作或翻译,或用传统的纸笔进行头脑风暴。这样做不仅能维持语言组织能力与逻辑思考能力,还能增强自主检索信息与筛选论据的能力。把"AI免疫日"从概念变为实践 - - 每周挑一天不使用AI,或者把某些工作环节设为纯手工模式 - - 可以作为有益的习惯。 培养批判性思维与信息素养同样不可或缺。

AI给出的答案看似自信,但并不总是正确。学习如何检查来源、评估证据、识别偏见与模型局限,能够降低盲目信任带来的风险。把AI建议当成草稿,对每一处结论都问一个"为什么",并寻找反例或替代解释,这样的思维训练会长期保护你的判断力。 把AI用作训练工具而非替代品 聪明的使用方式是把ChatGPT变成自我训练的镜子而非依赖的枕头。举例来说,在写作训练中可以先独立完成初稿,再用AI给出修改建议,最后由自己决定是否采纳并思考为什么采纳或拒绝。这样的循环能把AI的速度优势转化为学习机会:你在比较、选择和反思时同时锻炼了批判性判断。

在语言学习场景中,AI可以充当对话伙伴和即时纠错工具,但要避免把会话练习完全交给它。保持真人交流、阅读原著和反复朗读等传统方法,仍然是巩固语感与表达能力的基石。对技术人员而言,AI可以生成代码片段或调试建议,但真正的技能掌握来自于理解底层原理和主动复盘错误。 在组织层面应建立"人机协作守则" 企业和团队也需要制定相应治理框架,防止在流程中盲目嵌入AI导致技能流失或风险积累。好的做法包括要求对AI输出进行二次人工审核,把关键决策权保留给具备专业知识的人,并对AI建议写出审查记录。培育一种"质疑文化"比简单的工具管理更重要:鼓励员工不仅接纳AI带来的便利,也要质问其合理性与假设。

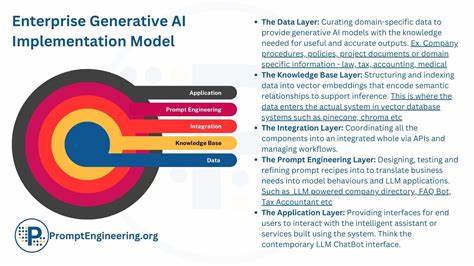

培训计划应包含两条并行线:一是教会员工如何有效提示(prompt engineering)和解读AI输出,使其成为生产力的放大器;二是持续进行核心技能的训练,确保团队在面对系统失败或异常情形时能独立应对。技术治理与人才培养同时发力,能让组织既具备高效能力,又保持应变韧性。 个人习惯的调整:从依赖到主动 改变习惯并不需要激烈的断裂式改革。可以从日常小处入手,在最容易依赖AI的环节设置阻力点,例如在使用翻译工具前先试着自己翻译一段,再对比AI结果;在写电子邮件前先列出要点;在遇到复杂问题时先写下自己的假设,然后用AI检验。这种"先用脑再用机"的流程能在保留效率的同时保持认知参与。 与此同时,建立反馈与反思机制至关重要。

定期回顾哪些任务被AI代劳,哪些能力因此下降,以及有哪些场景是必须保留人的判断。把这些观察写下来并形成可执行的改进计划,可以把模糊的焦虑转化为具体的行动。 伦理与社会层面的考量 当大量人群同时改变认知练习方式时,社会层面会出现更广泛的影响。教育系统需重新思考评估方法,避免把可外包的技能作为衡量学生能力的唯一标准。同时,劳动市场对某些技能的需求会发生迁移,个人与组织都应投资于那些难以被简单替代的认知能力,例如复杂问题建模、跨学科整合与创造力。 此外,公共讨论应涉及如何在法规、平台责任与教育之间找到平衡。

AI平台需要提高透明度,帮助用户理解模型的局限与来源;教育机构则要将信息素养纳入基础课程;雇主应当认可并奖励那些既能高效利用AI又能保持核心技能的员工。 结语:不是AI让人变笨,而是我们如何使用AI决定未来 把"变笨"归咎于ChatGPT是对问题的过度简化。真正影响认知能力的是行为模式:如果我们让外部工具承担所有认知负荷,技能就会退化;如果我们把工具当作伙伴来训练、检验与扩展自身能力,人工智能则会成为提升智慧的催化剂。平衡便捷与练习、效率与反思,是每个使用者与每家组织现在都必须面对的挑战。 从今天开始,给自己制定一个关于AI使用的原则,让ChatGPT成为你思维的助推器,而不是替代品。保持好奇、坚持练习、培养批判性思维,并在团队与社会层面推动负责任的使用规范。

这样一来,你既能享受技术带来的效率,也能守护并强化属于人的思考能力。 。