随着人工智能技术的飞速发展,大型语言模型(LLM)已成为推动自然语言处理和多领域智能应用的核心力量。然而,传统基于冯诺依曼架构的数字计算方式在处理海量模型数据时,面临着性能瓶颈和能耗压力。模拟基础模型的崛起,正是为了解决这一难题,将模拟内存计算(Analog In-Memory Computing, AIMC)技术与深度学习模型相结合,开启了计算效率和能耗控制的新纪元。模拟内存计算的核心理念在于将存储和计算整合在同一物理单元中,通过物理电路的模拟特性,直接在存储设备中完成向量乘加等计算任务。这种方法显著减少了数据在存储和计算单元间的传输次数,从而极大地提升计算速度并降低能耗。尽管如此,模拟计算引入的噪声和精度限制,给基于模拟硬件的大规模语言模型部署带来了巨大挑战。

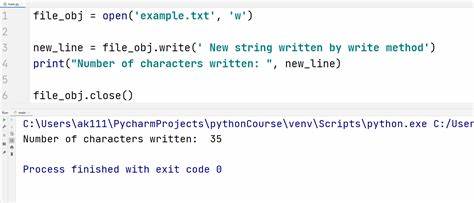

模拟计算的噪声源自电路工艺变异、温度波动及材料特性的不确定性,这些因素导致计算结果具有一定的随机性和误差。此外,模拟硬件对输入输出的量化精度要求较为严格,一般限制在4位权重和8位激活的低精度范围内。传统的大型语言模型往往设计为在高精度数字环境下运行,直接映射到模拟硬件通常会导致性能急剧下降。针对此问题,最近一项由Julian Büchel等研究团队提出的创新方法,首次实现了通用且可扩展的策略,使得大型语言模型能够在噪声和低精度的模拟硬件环境中依然保持优异的推理性能。该方法通过专门设计的训练和微调流程,增强模型对量化和噪声的鲁棒性,从而有效补偿了模拟计算带来的计算不确定性。具体而言,研究团队选择了包括Phi-3-mini-4k-Instruct和Llama-3.2-1B-Instruct等当前最先进的模型作为测试平台。

在经过特殊训练适配后,这些模型在模拟硬件上的表现甚至达到了传统数字系统中4位权重和8位激活的基线水平,充分体现了模拟基础模型的潜力。不仅如此,模拟基础模型在训练过程中还显示出良好的泛化能力,能够兼顾数字低精度硬件的推理需求,为未来多硬件融合部署奠定了基础。同时,这些模型也表现出优良的测试时计算规模扩展能力,优于传统4位权重和8位静态输入量化训练的模型。这意味着在实际应用场景中,模拟基础模型能随计算资源的增加获得更好的性能提升,体现了极佳的伸缩性和灵活性。模拟基础模型的出现不仅为AI算力的绿色转型提供了切实可行的技术路径,还对推动硬件设计理念的革新起到了催化作用。在未来,模拟计算芯片与基础模型的紧密配合将促使人工智能系统实现速度和能耗的双重最优化,适用于智能手机、自动驾驶、边缘计算等多种场景,满足用户对智能设备高效能低功耗的迫切需求。

从行业视角看,模拟基础模型的研发标志着大型语言模型从依赖超大算力向更加普适和节能的硬件环境迁移的关键一步。技术突破带来的成本降低将促进AI技术的普及,同时也推动相关产业链的升级和创新。未来,随着材料科学、芯片设计以及算法优化的协同发展,模拟基础模型有望实现更高计算精度和更强鲁棒性,进一步扩大其应用范围。科研界和产业界正积极投入资源,探索如何将模拟计算技术应用于更多复杂神经网络架构,推动人工智能向真实世界智能迈进。总结来看,模拟基础模型融合了模拟内存计算优势和先进深度学习算法,破解了能耗与性能的矛盾,开辟了大规模语言模型高效部署的新方向。它不仅是当前AI硬件发展趋势的代表,更是未来智能计算场景的关键基石。

随着相关技术的成熟,模拟基础模型必将成为引领智能时代基础设施的重要组成部分,助力实现更智能、更高效、更绿色的信息社会。