随着人工智能的不断发展,自然语言处理(NLP)在众多领域发挥着越来越重要的作用。无论是机器翻译、文本生成还是情感分析,NLP技术的推进离不开高效且精准的模型支持。近年来,Rust语言凭借其卓越的性能和安全性,在系统编程和高性能计算领域备受推崇。而Rust-Bert项目正是将Rust优秀特性与自然语言处理相融合,实现了基于Transformer架构的本地化、高效NLP流水线和模型,成为业界关注的焦点。 Rust-Bert是一个基于Rust语言开发的开源自然语言处理库,它高度借鉴并移植了Hugging Face Transformers的核心理念,涵盖了多种主流Transformer模型,包括BERT、DistilBERT、GPT2、RoBERTa、BART等。与传统Python生态相比,Rust-Bert利用Rust的内存安全特性和多线程支持,实现了多线程分词和GPU推理,极大提升了执行效率,特别适合对性能有较高要求的生产环境。

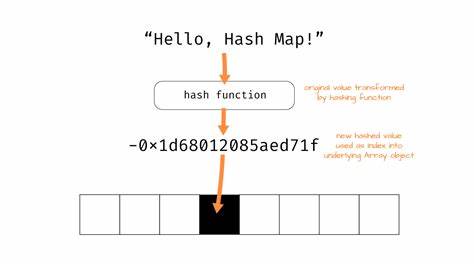

该库提供了丰富的预配置模型与任务特定的头组件,覆盖广泛的自然语言处理任务,包括文本翻译、摘要生成、多轮对话、零样本分类、情感分析、命名实体识别、词性标注、问答系统、文本生成、掩码语言模型、文本嵌入及关键词提取。用户可以通过简洁的接口快速调用,实现端到端的NLP解决方案,无需从头训练,大幅降低了部署门槛。 Rust-Bert构建于tch-rs库之上,后者是Rust对Libtorch C++ API的绑定,是PyTorch的核心底层库之一。使用Rust-Bert时,必须安装对应版本的Libtorch库,目前推荐的版本为2.4。用户可选择手动下载安装或开启库自带的自动下载功能。自动下载支持CPU版本默认方案,若需CUDA加速,则需设置对应环境变量以获取正确的GPU驱动支持。

在安装配置方面,Rust-Bert兼容主流操作系统,包含Linux、Windows和macOS,能够满足不同开发者的环境需求。 值得一提的是,Rust-Bert提供了对ONNX(开放神经网络交换格式)的支持。ONNX是一种跨平台的神经网络模型格式,通过整合onnxruntime运行时,可以实现模型在不同框架间的高效迁移,进一步提升推理性能和部署灵活性。Rust-Bert通过可选功能模块实现ONNX的加载和运行,支持多编码器、解码器、编码器-解码器类模型。这让用户可以直接使用Optimum等工具导出的ONNX格式模型,简化了从PyTorch模型到Rust端部署的流程。 在性能方面,Rust-Bert在简单任务如序列分类、标注以及问答系统中已经展现出与Python生态相当的表现。

因为核心计算逻辑依赖于共享的Torch底层库。而在文本生成、翻译和对话任务等复杂任务中,Rust-Bert凭借Rust的语言优势,能实现比Python快2到4倍的处理速度,为需要快速响应的大规模服务带来显著优势。性能提升不仅体现在推理速度,还包括内存使用率和多线程并发能力,使得高性能NLP服务的实现更加轻松。 Rust-Bert不仅仅满足于提供预训练模型和流水线,开发者还可自定义模型架构和权重。它暴露了基础模型架构和任务专项头的API,支持用户基于Rust生态的tokenizers库进行数据预处理,方便导入和利用BERT、DistilBERT、RoBERTa、GPT系列及BART等模型。此外,Rust-Bert内置的转换工具能将PyTorch权重转换为兼容格式,简化了模型迁移与共享过程。

丰富的示例代码和文档为上手和二次开发提供了有力保障。 Rust-Bert适用范围广泛,既适合科研人员研究最新模型,也适合工业界构建实际应用。它已被用于智能客服机器人、自动摘要系统、多语言翻译平台、情感分析引擎等多种场景。据社区反馈,该项目拥有活跃的维护团队和贡献者支持,持续完善代码质量和扩展新模型,拥抱自然语言处理技术的演进。 对比现有的Python NLP库,Rust-Bert的突出优势在于基于Rust的高性能和安全特性,使其在生产环境中具备更高的稳定性和可扩展性。特别是在底层调用与多线程框架配合方面,Rust-Bert无需频繁切换语言边界,有效避免了性能损失和潜在内存安全风险,是性能敏感型应用的理想选择。

未来,伴随着Rust生态的不断壮大以及Transformer模型的更新迭代,Rust-Bert有望持续引领NLP的高效化发展方向。 综上所述,Rust-Bert集成了Rust语言的现代技术优势和Transformer模型的强大表达能力,打造出本地化、高性能且易用的自然语言处理流水线。无论是对模型加载、推理速度还是多线程支持,Rust-Bert均展现出非常出色的实力。对于追求效率和稳定性的开发者和企业来说,Rust-Bert提供了一条值得探索的前沿技术路径。随着项目生态的不断完善,它将在自然语言处理领域扮演更重要的角色,助力更多智能应用实现质的飞跃。 。