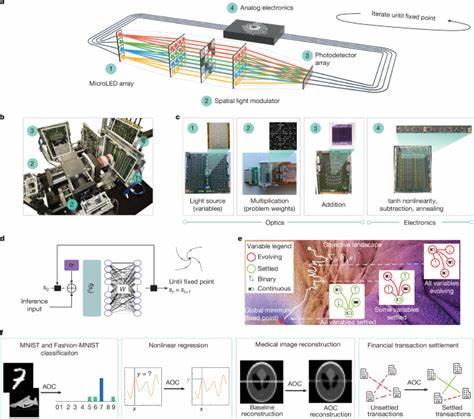

人工智能(AI)和组合优化已成为当今科学研究和工业应用的核心驱动力。然而,随着模型规模和计算需求的不断攀升,传统数字计算机面临着巨大挑战,特别是在能源消耗和延迟方面。面对这一困境,类比光学计算机(AOC,Analog Optical Computer)作为一种突破性的计算范式,凭借其高速、低能耗和天然并行的优势,展现出在AI推理和组合优化领域的重要潜力。类比光学计算机融合了模拟电子学与三维光学技术,利用光信号进行矩阵矢量乘法运算,而非数字二进制处理,从根本上改变了计算模式,避免了传统数字计算中频繁的数模及模数转换,极大提升了计算效率和噪声容忍度。此技术由微软研究院等机构开发,已发布在顶级学术期刊《Nature》上,标志着AI与优化计算迈向可持续未来的新里程碑。类比光学计算机的核心在于其迭代寻求固定点的计算框架。

固定点算法通过反馈机制在光学和模拟电子域间交替迭代,每次迭代仅需约20纳秒,光学部分完成高效的矩阵−矢量乘法,模拟电子则负责非线性激活、加减运算与退火过程。该机制不仅极大减少了能量损耗,还有效抵抗了模拟硬件中的固有噪声,保证了系统稳定收敛。相较于数字模拟器或其他非传统计算硬件,AOC在保持高精度的同时,避免了性能受限的记忆瓶颈和频繁数据传输。该架构实现的两大计算任务分别是AI推理中的神经平衡模型和广泛适用的组合优化问题。神经平衡模型是一类以固定点为推理核心的深度学习模型,具备递归推理和动态推理深度的优势,使其在人脸识别、语言模型等领域表现出色。通过数字孪生软件(AOC-DT)进行训练后,模型可以无缝转移至光学硬件实现加速推理,实验验证了对MNIST和Fashion-MNIST图像分类任务的有效支持,以及对复杂非线性回归函数的精确拟合。

组合优化方面,AOC针对二进制与连续变量混合的二次无约束混合优化(QUMO)问题进行了创新适配。相比传统仅支持二进制的QUBO模型,QUMO极大拓宽了优化问题的可表达性,能高效解决医疗图像重建、金融交易结算等真实世界应用。AOC通过固定点迭代与坐标下降分解等策略,成功解决了含数百变量的复杂问题,并在标准基准测试中实现了行业领先的结果。硬件层面,AOC展现出高度模块化设计理念。利用消费者级别的微型LED阵列、空间光调制器(SLM)和光电探测器数组,结合三维光学组件进行光线多路复用,突破了二维光学架构中矩阵尺寸受限的瓶颈。预计单个模块能实现百万级权重运算,通过100块模块的3D网格配置,即可支持数亿乃至数十亿权重规模的AI模型推理。

其操作速度受限于光电组件带宽,约为2GHz,功耗则远低于传统GPU,效率提升高达100倍以上。该平台具备极佳的扩展性和制造成熟度,预示着大规模类比光学计算机的可行性。类比光学计算机的迭代推理过程在算法上具有天然的噪声鲁棒性。系统通过吸引固定点的过程不断调整状态,抑制模拟信号中的随机偏差,保证长期稳定。这相比深度前馈神经网络对噪声的敏感性,极大提升了硬件部署时的容错能力和精度一致性。此外,灵活的非线性映射与动态退火机制,为复杂非凸优化问题提供了高效求解路径。

行业应用已经展示了巨大的潜力。在医学领域,AOC实现了一维以及二维MRI压缩感知重建,支持利用原始ℓ0范数的稀疏正则化,大幅提升了重建质量并减少了扫描时间。在金融行业,针对证券交易结算中的限制性组合优化问题,AOC不仅准确解决了高维变量问题,更成功超越量子硬件的成功率,展示了模拟光学计算技术在商业场景中的现实价值。面对未来,类比光学计算机发展仍面临挑战。其中,器件尺寸的极限、光学路径的精准匹配以及与模拟电子学的深度融合是关键难点。微型化三维光学结构、高速集成模拟电路和高分辨率空间光调制器的研发,将决定可扩展性的上限。

同时,算法层面也需要进一步优化固定点迭代及退火参数,适应更复杂的模型与多样的应用场景。此外,如何实现端到端的训练与硬件联合优化,是推动该技术实现产业化的重要方向。整体来看,类比光学计算机是数字计算后新兴的高效能计算平台。它利用物理光学的天然并行性与低功耗特性,实现了AI推理和组合优化的统一加速。通过硬件和算法的协同设计,该技术在现有数字芯片瓶颈难以突破的时代,提供了可持续且高效的解决方案。未来,随着制造工艺的进步与应用生态的完善,类比光学计算机有望在智能化医疗、金融科技、自动驾驶等领域引发新一轮技术革命,推动智能计算迈入全新时代。

。