在人工智能蓬勃发展的今天,越来越多的人开始关注一个关键问题:AI技术在运行过程中消耗了多少能源?特别是当我们输入一个简单的提示请求时,这一操作背后的真实能耗往往被忽视。为了深入了解这一话题,我亲自前往一家先进的数据中心实地考察,揭开AI提示所消耗能量的神秘面纱。 首先,理解人工智能提示的能耗状况,需要从基础设施谈起。数据中心是现代数字经济的核心,它们承载着海量计算任务。每一次AI模型的推理和训练都需要消耗大量算力,而这又直接转化为电力消耗。令许多人感到意外的是,虽然单次提示的能耗看似微小,但累积起来,其总体能耗仍然非常可观。

数据中心的运行不仅依赖于强大的服务器,还依赖于高效的冷却系统。为了防止设备过热,冷却设备持续运转,这一过程同样消耗大量电能。通过与数据中心技术人员的交流,我了解到目前行业内正致力于提升能效比,也就是单位计算所需的能量,以缓解环境压力。 进入数据中心内部,首先映入眼帘的是整齐排列的服务器机架。每个机架都搭载着成百上千个处理器,专门处理AI模型的预测请求和数据训练任务。每一条来自用户的AI提示,都会在这些处理器中被迅速计算和响应。

为了测试具体能耗,我观察了在高峰期和低谷期服务器的功耗变化,也参考了服务器的能耗监测数据。 根据数据中心提供的统计数据显示,单次AI提示请求的能耗在几瓦时到数十瓦时之间,视模型复杂度和运行参数而定。尽管单次消耗较低,但当天数以百万计的用户同时在线使用AI服务时,整体能耗非常巨大。这意味着环境影响不容忽视,尤其在依赖化石能源供电的地区,碳足迹尤为显著。 除了能源消耗,数据中心为什么选择特定位置建造,也与节能减排目标息息相关。很多现代数据中心选址于电力供应充足且多采用绿色能源的地区,譬如水电、风能或太阳能丰富的地方。

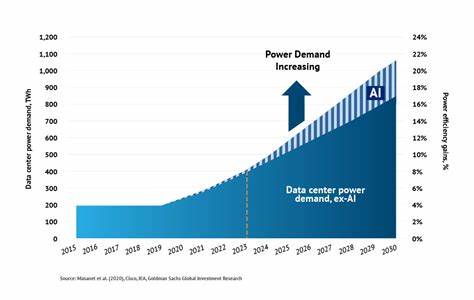

此外,地理位置也影响冷却系统的运作效率,一些利用自然低温环境降低制冷成本的数据中心,能大幅度减少能耗。 随着AI模型变得越来越复杂,培训和推理时所需的计算资源也不断增长,未来的能耗问题愈加严峻。为了控制能源消耗,业界推动了多个方向的创新。其中包括开发更高效的硬件芯片、优化算法减少计算冗余,以及利用边缘计算减轻中心服务器压力等策略。 政府和企业逐步提高对AI技术能源使用的透明度,推动制定更为严格的节能标准与政策。用户在享用智能服务的同时,也应关注其背后的环境代价,推动信息的公开化和公平性,以促进绿色科技的发展。

普及节能观念同样重要,合理安排AI系统使用时间,减少不必要的计算请求,也能在日常生活中体现节能环保意识。 回顾这次的亲访经历,我深刻感受到AI技术与能源的复杂关系。AI虽然带来了工作效率的提升和生活的便利,但其背后所需的能源投入不容忽视,不断推动绿色计算的发展才是实现智能与可持续共赢的关键。随着技术进步,人们需要不断审视AI发展和环境保护之间的平衡,实现数字经济的长远健康发展。 未来,数据中心和AI开发者需要携手合作,持续优化系统设计和运作方式,充分利用绿色能源资源。同时,公众的环保意识提升,也将成为推动整个产业节能减排的重要力量。

通过共建更加环保高效的AI生态,才能确保人工智能技术真正成为促进社会发展和环境保护的正能量。 总结来说,人工智能提示的能耗远比表面看来复杂,这一切都依赖数据中心的底层运作和能源管理。用户在享受AI便捷的同时,也应了解其环境成本,共同推动绿色计算实践。未来的AI能源解决方案,将会更多地聚焦于高效节能和可再生能源的利用,为构建智能且可持续的数字时代奠定基础。