随着人工智能技术的飞速发展,大型语言模型(LLMs)在自然语言处理及复杂推理任务中的表现愈发突出。然而,这些模型在测试阶段的推理计算需求通常极高,导致延迟增加和资源消耗显著,这成为其广泛应用的一大瓶颈。近年来,学术界和工业界围绕如何提升模型测试时的推理效率展开了大量研究,而一种被称为“睡眠时间计算”的创新方法逐渐浮出水面,为该领域带来了新的突破。 睡眠时间计算的核心在于让模型能够在实际查询之前,基于对可能用户问题的预测,离线预先处理和计算关键的中间结果。这种“提前思考”的策略能够显著减少模型在测试时的计算需求,从而降低延迟及资源消耗,同时保持甚至提升整体推理的准确度。这与传统单纯依赖测试时推理扩展的思路截然不同,注重将部分计算任务转移到“睡眠阶段”,实现推理负担的分散与提前解决。

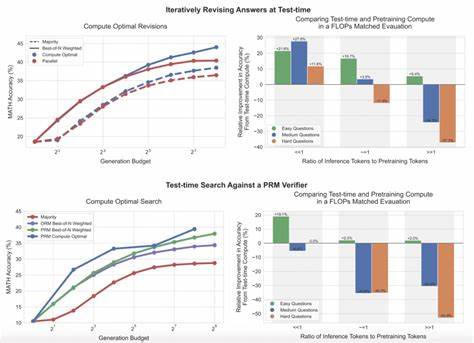

这一概念最早在解决复杂符号推理和数学竞赛问题的实验中得到了验证。研究团队开发了经过改良的两个任务环境,分别称为“状态化GSM-符号推理”(Stateful GSM-Symbolic)和“状态化AIME”任务,这两个任务模拟了多步推理及上下文关联的复杂计算场景。在这两个任务中引入睡眠时间计算后,测试时所需的计算资源大幅减少,达到之前5倍的节约,同时准确度也有明显提升,分别提升了13%和18%。 此外,针对多个相关查询共存于同一个上下文的情况,研究者扩展出“多查询GSM-符号推理”(Multi-Query GSM-Symbolic)任务框架。利用睡眠时间计算针对相同上下文的多条查询进行计算分摊,从而显著降低单条查询的平均计算成本,达到了约2.5倍的效率提升。这种方法显示出极强的实用价值,尤其对于实际应用中用户可能围绕同一场景提出多个问题的场景尤为适用。

经验分析表明,睡眠时间计算的效用与用户查询的可预测性密切相关。当用户提出的问题更易于被模型提前推断时,睡眠时间计算带来的计算节省和准确度提升效果越显著。反之,在高度随机或多样化的查询条件下,此方法的优势则可能受限。鉴于此,未来提升查询预测能力和模型预计算质量,将成为进一步挖掘睡眠时间计算潜力的关键方向。 除学术研究环境外,睡眠时间计算也在实际工业任务中展现出了巨大的应用前景。研究团队以软件工程自动化任务为例,开展了具体案例分析,证明其在复杂人工智能代理执行环境中的有效性。

该代理系统能够基于历史数据和场景信息,预先计算相关问题的推理线索,大幅减少在线响应时间,使得整个系统更加高效且智能化。 从技术角度来看,睡眠时间计算并非单纯的缓存策略,而是在模型结构和推理流程上进行深度优化。它依托模型具备的上下文理解和推理能力,通过离线计算深度嵌套信息和中间表示,为测试时的快速查询调用提供强大支持。这不仅优化了算力资源的利用,也使模型能够应对更多复杂且多变的实际应用需求。 未来,睡眠时间计算有望进一步融合自监督学习和强化学习方法,通过不断提升对用户行为和查询模式的适应性,实现模型的动态调度和计算资源的智能分配。同时,其在多模态推理、跨领域知识迁移等新兴方向同样具备广阔的应用潜力。

综上所述,睡眠时间计算作为超越传统测试时推理扩展的革新技术,为大型语言模型的高效应用开辟了新路径。它通过提前离线计算关键推理步骤,极大地压缩了测试阶段的计算负担,不仅提升了模型性能,更推动了人工智能系统在复杂任务中的实际落地。随着研究的深入和技术的成熟,睡眠时间计算必将成为未来智能推理领域的重要基石,助力人工智能迈向更高效、更智能的新时代。