近年来,随着人工智能技术的飞速发展,AI代码助手逐渐成为软件开发领域的革命性工具。这些助手如Anthropic的Claude Code、OpenAI的GPT-5以及Google的Gemini 2.5 Pro等,极大地提高了开发人员的工作效率。然而,快速生成代码的同时,隐藏的安全风险也显著上升,给企业带来了难以忽视的威胁。了解AI代码助手带来的优势与挑战,对于构建安全、稳健的软件系统至关重要。 AI代码助手通过自动补全、语法修正和逻辑优化,帮助开发者快速完成大量代码任务,使得代码产出量相比传统手工编写提升了三到四倍。这种效率的提升让开发团队能够及时响应市场变化,加快产品迭代速度,缩短上线周期,从而在激烈的竞争中占据优势。

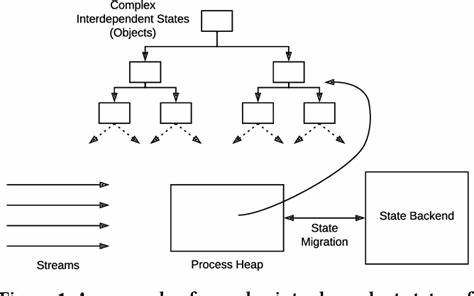

不仅如此,许多开发者在处理复杂的语法错误和逻辑遗漏时,借助AI助手能有效避免低级错误,减少了语法错误率达76%,逻辑漏洞减少60%。这些积极变化无疑推动了软件开发质量的初步提升。 然而,Apiiro等权威安全公司的研究揭示了一个不容忽视的事实:虽然代码产出速度加快了,安全问题却呈爆炸性增长。统计数据显示,AI辅助开发产生的安全隐患比传统开发多出十倍,这些隐患不仅限于可被利用的漏洞,更广泛涵盖开源依赖风险、不安全的编程模式、暴露的敏感信息如云凭证和密钥、以及云端配置错误等多个维度。 如此多样化且密集的安全问题,意味着企业在享受人工智能带来的生产力提升同时,实际也在同步扩大安全风险规模。比如,AI生成的代码中,权限升级的潜在路径增幅达到322%,架构设计缺陷增幅达153%。

这表明AI并非简单地修复旧有错误,而是在某些方面无意中制造了"定时炸弹"。 更为严峻的是,AI助手倾向于一次性提交大量代码变更,导致代码审查过程中难以逐条分析,增加了漏掉安全隐患的概率。例如,某次通过AI自动生成的Pull Request在多个服务间更改了授权头,却因下游服务未跟进更新,导致了隐蔽的认证失败,这样的错误在传统开发中较少发生。审查难度提升无疑是当前AI开发流程管理的一大挑战。 深究背后原因,部分在于AI模型训练时吸纳了大量包含缺陷的开源代码,使得这些隐患在生成过程中被无意识复制。此外,未经过专门安全审计的自动化代码迭代过程,更容易加剧安全漏洞的积累与传播。

知名研究机构如旧金山大学、加拿大Vector人工智能研究所和马萨诸塞大学波士顿分校的学者也证实,AI模型不断优化自身代码示例不仅没有提升安全性,反而导致安全性能下降。 在云安全领域,开发者借助AI完成配置和凭证管理时出错的频率几乎翻倍。尤其在多云架构和复杂权限体系日益普及的环境中,暴露的凭证和错误的权限配置可能成为攻击者的突破口,带来数据泄露和服务中断的巨大风险。 有趣的是,关于AI代码助手是否延长开发周期的问题存在争议。Apiiro统计的是代码生成的时间,而忽略了后续修复安全、不兼容和逻辑缺陷所需的额外时间。相反,Model Evaluation & Threat Research(METR)的研究发现,AI工具往往使整体开发周期变长,开发者不得不花费更多精力排查潜在问题。

企业领导层对此必须提高警惕。Apiiro的产品经理Itay Nussbaum明确指出,若企业强制使用AI进行代码开发,则必须同步推行AI驱动的应用安全措施。否则,所谓的生产力提升不过是安全风险的快速积累,最终将得不偿失。这样的警示无疑提醒各级管理者,将应用安全提升到与开发效率同等重要的位置十分必要。 针对当前局面,业界专家建议增强AI代码生成过程中的安全审查机制,强化代码自动化扫描与人工复核的结合,确保代码质量和安全性同时落实。制定符合AI开发特色的安全最佳实践,培训开发人员增强安全意识,以及借助AI自身的安全检测能力来辅助漏洞挖掘,都成为解决这一难题的关键路径。

与此同时,政策制定者和标准组织也开始关注AI辅助开发的安全监管,推动行业制定相应的合规规范和风险评估标准。只有在技术创新与安全保障并重的基础上,才能充分发挥AI代码助手的潜力,实现更高效、更安全的软件开发。 总的来说,人工智能代码助手在释放开发效率的同时,也带来了前所未有的安全挑战。企业若无法正确认识和应对这些风险,轻易推动AI普及,可能最终陷入效率与安全的两难困境。未来,只有构建起完善的AI应用安全生态,才能真正将这一创新工具转化为可靠的生产力资源,而非安全隐患的放大器。 。