苹果公司在2025年世界开发者大会(WWDC)上正式发布了iOS 26系统的一项重大更新——视觉智能(Visual Intelligence)功能不再局限于摄像头识别现实世界物体,而是实现了对iPhone屏幕上任何内容的实时分析和智能交互。这意味着用户可以直接在手机屏幕中选中想要的信息,进行搜索或操作,无需跳转应用,极大提升了使用流畅度和效率。 这项升级不仅是对视觉识别技术的提升,更是苹果人工智能战略中的重要一步。此前,视觉智能功能主要依赖设备摄像头对现实世界场景的分析,诸如识别植物、动物、文本等。如今,苹果将这套强大的智能识别框架扩展至屏幕内容,实现了跨应用、跨界面、跨内容的无缝深度理解。无论是网页、聊天界面、照片还是应用内的商品推荐,视觉智能都能精准捕捉所关注的细节,并智能联动相关应用完成后续操作。

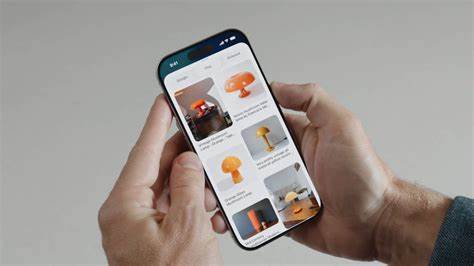

使用门槛上,苹果设计了极简的操作方式,用户只需通过与截屏同样的按键组合唤出视觉智能菜单。操作时,系统将自动识别当前屏幕上的重点对象,例如商品、事件、文字信息等。举例而言,当屏幕上出现一盏灯具时,用户只需点选该物品,视觉智能就能在Google、Etsy等平台搜索相似款式,直接链接购物页面,极大方便了用户的线上购物流程。另外,如果屏幕中显示的是待办事件或会议邀请,系统会自动提取时间、地点等关键信息,并建议一键同步至日历提醒。 隐私保护方面,苹果依然秉承其一贯的设备端智能处理原则。即所有视觉内容的分析和识别均发生在本地设备,不上传云端,更好地保障用户数据安全与隐私权。

这样不仅提升了响应速度,也避免了信息泄露的风险,为用户带来安心的使用体验。 这次视觉智能的升级极大地丰富了iPhone的使用场景,也改变了用户交互习惯。以往用户需要在浏览网页与搜索引擎之间反复切换,复制粘贴筛选内容,如今只需在屏幕上轻点几下,即可获得精准的智能服务。尤其是在电子商务、日程管理、即时咨询等频繁场景中,视觉智能成为了连接信息与行动的桥梁。 从技术层面分析,苹果整合了大规模预训练模型与图像识别算法,结合自然语言处理技术,实现了屏幕文本、图像、图标等多模态信息的融合理解。通过深度学习模型的不断训练与优化,系统能够准确识别各种复杂场景与物品,不断提升识别精准度和反馈速度。

配合iPhone最新芯片的算力保障,体验流畅且响应迅速。 在开发者生态方面,苹果还将开放相关接口,允许第三方应用接入视觉智能平台。这意味着未来更多应用可以利用屏幕内容识别能力,扩展其智能交互功能。用户能够享受到更多元化、个性化的智能服务,推动整个iOS生态向更智能化和便捷化方向发展。 此外,视觉智能的多语言识别能力也意味着该功能不仅局限于某一地区或语言环境,全球用户都能享受其带来的便捷。结合iOS 26带来的整体界面优化与“Liquid Glass”全新设计,视觉智能的加入更是锦上添花,让手机使用体验更加智能、自然和人性化。

值得一提的是,业内普遍认为此项功能对提升苹果智能助手Siri和内置AI聊天工具的实用性大有裨益。用户可以就屏幕所见内容直接提问ChatGPT,获取即时解答或建议,将手机化身为真正的智能助手,极大拓展了交互维度。 总结而言,iOS 26的视觉智能屏幕内容搜索功能,正引领智能手机操作方式迈向一个全新高度。它不仅优化了用户体验,也为未来智能手机视觉交互树立了全新标杆。这一技术的成功落地展示了苹果在人工智能、隐私保护和用户交互设计领域的持续创新能力。 随着iOS 26的逐步推送和普及,相信越来越多用户会在日常生活中感受到该技术带来的便利与效率提升。

未来,屏幕内容智能识别将成为手机操作的标配,让数字生活更加智慧和贴心。对于追求高效、智能操作的用户而言,iOS 26的视觉智能无疑是一场值得期待的革新。