近年来,随着大型语言模型(LLM)在自然语言处理、智能客服和生成式AI领域的蓬勃发展,可观测性的重要性日益凸显。LLM应用因其高度复杂性以及频繁调用外部服务的特点,使得开发者亟需借助先进的监控与分析工具,来确保系统的稳定性、性能优化以及成本管控。本文将从ClickStack、OpenTelemetry和MCP三个关键技术维度出发,深入阐述如何构建全面且高效的LLM可观测性解决方案。 首先,ClickStack作为基于ClickHouse数据库构建的开源观测堆栈,为大规模日志、指标和追踪数据的存储与分析提供了强有力的基础支撑。ClickHouse以其卓越的实时分析能力和低延迟响应著称,能够轻松处理海量结构化事件数据,满足LLM应用在运行时产生的复杂数据需求。ClickStack集成了HyperDX UI和OpenTelemetry Collector,形成了完整的可视化监控和数据采集管道,使开发团队能够实时洞察模型调用详情、上下文交互及关键性能指标。

其次,OpenTelemetry作为业界主流的云原生观测标准,极大简化了应用层的监控数据收集工作。基于OpenTelemetry的自动化埋点与分布式追踪机制,LLM平台能够无缝捕获请求路径、响应时长和微服务间链路,实现全方位可观测性。OpenTelemetry还支持多种数据格式与传输协议,为ClickStack的OTLP接口提供天然的兼容性,使数据流动顺畅且统一管理。 而MCP(Model Context Protocol)协议则为LLM与外部第三方服务的集成建立了轻量级、语言无关的标准接口。通过实现MCP服务器,用户能够让LLM主动查询数据库、触发API调用以及协调多样数据源,构建起交互灵活的Agent工作流。特别是ClickHouse MCP服务的出现,结合ClickHouse强大的低延迟查询引擎,极大提升了LLM在实时数据交互和推理任务中的响应速度和准确性。

典型的实现案例是通过LibreChat,一个支持多模型、多语言且高度模块化的开源AI聊天平台,演示如何将MCP与ClickHouse MCP服务器无缝对接,并利用OpenTelemetry完成从应用层到数据存储的全链路监控布置。LibreChat容器化部署后,开发者只需少量配置即可启用OpenTelemetry自动埋点,并将日志、指标和追踪数据发送至ClickStack。此举不仅简化了开发流程,也保障了观测数据的完整性和可操作性。 实际运行时,LibreChat通过MCP与ClickHouse服务器通信,将用户查询转化为高效SQL请求,实时检索数据库信息,模型基于这些数据生成回答。OpenTelemetry追踪捕获从用户请求进入系统,到调用MCP,再到返回结果的整个调用链路,确保运维人员能够准确定位性能瓶颈和异常行为。同时,日志文件经过专门配置,被OTel采集器抓取和解析,结合Prometheus采集的性能指标,形成丰富的多维数据视图。

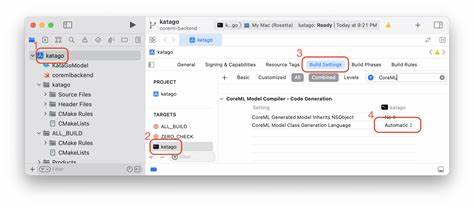

通过HyperDX UI,团队可以方便地使用SQL查询观察每条LLM交互的Token使用情况,包括输入Token和生成Token数量,精准核对实际使用成本。统计数据显示,ClickStack收集的Token计数与OpenAI官方API数据高度吻合,证明了监控数据的严谨性和可依赖性。此外,分析复杂查询时的多轮交互日志,有助于洞察模型与服务之间频繁调用的细节,揭示潜在性能优化空间。 从架构设计看,将LibreChat与ClickHouse MCP服务器分开部署,再通过共享卷挂载日志文件,配合独立的OpenTelemetry Collector,实现了高内聚低耦合的数据采集方案。这个设计不仅保证了监控系统的灵活扩展,还便于故障隔离和升级维护。基于Docker Compose的自动化部署脚本,使得整个堆栈从启动到运行平滑无缝,为开发者节省了大量环境搭建和配置时间。

综合来看,基于ClickStack、OpenTelemetry和MCP的LLM可观测性解决方案,有效解决了当前多模型、多服务交互带来的监控难题。它将高性能时序数据存储、标准化追踪采集和协议层交互融合,赋能开发团队实现全链路透明化管理。随着AI应用规模的扩大和业务复杂性的提升,这套方案不仅提升了系统可靠性,也为费用管理和用户体验优化提供了量化依据。 未来,随着MCP协议和OpenTelemetry标准的不断进化,LLM在Agent服务、多模态交互以及数据驱动决策领域的应用场景将更加丰富。ClickStack作为核心数据处理平台,也将持续增强对大规模多源数据的兼容性和分析能力。技术社区的积极创新有望推动整个产业链实现更智能、高效的AI运维体系。

因此,企业和开发者若希望在快速发展的AI时代保持竞争力,深度理解并应用这些先进可观测技术尤为重要。通过结合使用ClickStack的强大数据库功能、OpenTelemetry的全方位采集机制与MCP协议的灵活服务集成,能够打造面向未来的智能应用监控平台,从而保障大型语言模型的可用性、性能和成本效益最大化。