开源社区一直以来依赖于热心的开发者和维护者共同为项目贡献代码、解决问题以及回复用户反馈。然而,随着人工智能技术的快速普及和强大语言模型的广泛应用,开源维护者正面临着一种全新的压力:海量且难以分辨的AI生成的垃圾问题报告正在不断涌入,严重挤压了他们的时间和耐心。多名开源维护者纷纷爆料,他们的邮箱、项目平台上充斥着模仿真实用户口吻但毫无实质内容的“反馈”,这些反馈不仅形式雷同,而且带有刻意的情绪化语言,使得辨别其真实性变得尤为困难。开源维护者Terence Eden在其博客中分享了自身的经历:一次看似由用户发起的问题报告事实上是典型的AI垃圾邮件,充满夸张的表述和大量表情符号,却无法提供有效的调试信息。这类反馈不仅浪费维护者试图解决实际问题的时间,还通过情绪化的语言施加额外心理负担,让维护者为了保持社区秩序不得不投入更多精力。平台如Codeberg等开源托管网站因为受到了大量类似的垃圾举报,陷入了前所未有的监管和防护压力,他们必须寻找有效手段阻止这些虚假反馈达到维护者手中,以避免消耗社区资源。

然而,这种现象影响远不止于单纯的垃圾邮件,它直接威胁到了开源项目的可持续发展。因为维护者可能因为频繁应对无效反馈而出现疲劳和倦怠,长此以往,可能导致他们减少参与甚至放弃维护工作。此外,很多真实的用户反馈可能被淹没在海量虚假信息中,错失了早期发现和修复严重问题的机会。AI生成的垃圾问题报告很可能具有跨平台和大规模的特点,致使多个开源项目同时受到冲击。类似的情况已在Twitter、Mastodon等社交平台和Git代码托管服务上频繁出现。尽管AI技术为开发者带来了便捷和提升效率的可能,但其被恶意或无意滥用所引发的负面影响不容忽视。

从攻击目标来看,可能存在多重动机。有人怀疑这是试图削弱特定平台如Codeberg的声誉和用户信任,从而导致用户转向更商业化的平台;也可能是为了扰乱开发者的工作节奏,让维护者心力交瘁,减少他们对开源生态的贡献。甚至有观点认为,某些研究人员或“无聊”的群体正在测试维护者对AI生成内容的识别能力,推测此举背后并无明确恶意,但对维护者的影响却是实质性的。在具体内容上,这些AI生成的报告通常表现为语气情绪化、强调使用者的困惑和无助,有时还包含对维护者的隐性责备或要求修改代码的请求,但缺乏具体的报错信息、运行环境和复现步骤。他们的形式似乎在操纵人类的同情心,让维护者不得不花费时间去反复回复甚至忙于区分真假。为了应对这一问题,开源社区和平台运营方需从技术和管理两方面入手。

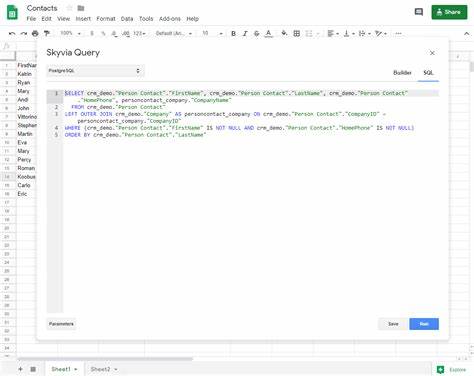

首先,加强对问题报告的自动化筛选,利用机器学习模型识别潜在的AI生成内容,设置更严格的提交门槛或防护机制以减少低质量输入。其次,完善社区规则,明确反馈要求和格式,鼓励用户提供详实的调试信息,同时在社区内加强教育和引导,提升用户提供有用反馈的意识和技巧。维护者自身也需要调整心态和策略。学会识别和快速过滤无效反馈,避免陷入情绪化交流,同时合理分配时间,防止因应对垃圾信息而影响核心开发工作。此外,与其他维护者加强沟通和协作,分享识别和处理此类AI生成内容的经验,形成集体的防护网络。从长远来看,技术发展与开源精神需寻求平衡。

AI工具应被视为辅助开发者而非扰乱者,开发更智能、更具识别力的系统辅助维护者筛选反馈,同时倡导更负责任的AI使用。唯有如此,才能保障开源社区的活力和创新动力不被浪费,创造一个更加健康和谐的开源生态环境。现如今,开源维护者被“AI垃圾邮件”淹没的现象,无疑是技术进步带来的意想不到的副产品。在全球开源繁荣的时代背景下,如何妥善应对这一挑战,既是维护者的考验,也是整个技术社区共同需要面对的课题。解决这一问题不仅需要技术上的革新,还需要社区氛围、文化建设和平台治理的协同努力,才能让AI真正成为提升开源生态的利器,而不是消耗维护者热情的利刃。未来,随着AI技术的进一步普及和完善,开源社区对于抗击虚假反馈和保障高质沟通的能力也将不断提升,唯有拥抱变化并积极实践,方能迎接开源生态的下一次辉煌。

。