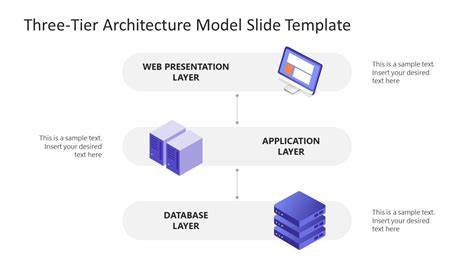

随着人工智能特别是大型语言模型(Large Language Models,LLM)的迅速发展,模型规模不断扩大,推理阶段对于模型加载速度的要求也日益提高。在分布式GPU集群中运行这些模型时,传统依赖单一存储层的方案往往难以满足高并发、多节点环境下的带宽和时延需求,导致整体推理效率受限,GPU资源闲置浪费。为了克服这些瓶颈,业界普遍采用三层存储架构来优化模型读取路径,让数据处理更高效,从而保障推理任务的连续和稳定。三层存储架构将存储体系划分为热、温、冷三个等级,结合各类存储介质的优势,实现了不同访问场景下的最优性能均衡。第一层是热存储层,通常是每台计算节点本地的NVMe固态硬盘(SSD),以POSIX文件系统方式暴露给应用。由于NVMe SSD通过PCIe总线直接连接,具备极高的顺序读写速度和极低的访问延迟,可达到单节点2.5GB每秒以上的吞吐,几乎接近内存速度,满足模型文件随机访问及大文件顺序加载的高效需求。

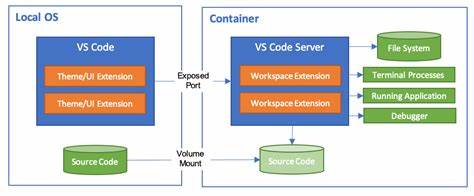

LLM在推理时常使用内存映射技术(mmap)读取模型权重文件,如safetensors格式能够充分利用此优势,将文件数据映射到内存地址空间,极大提升访问效率。而本地文件系统又无需额外修改推理代码,兼容主流深度学习框架,实现快捷部署和运维。热存储层可视为前线缓存,通常提前将频繁使用的模型预加载进本地SSD,后续推理请求均从这层读取,避免多余的网络传输。第二层是温存储层,集中于集群范围内的节点间数据共享。相比于每个节点都单独从云端拉取大型模型文件,温存储层允许节点之间通过高速局域网直接传输所需数据。具体手段可能是节点之间运行简易HTTP或者NFS服务器,或者使用更先进的点对点分布式文件服务。

温存储层将已缓存于某节点本地NVMe的数据,以局域网带宽大约1.5GB每秒的速度供其他节点访问,大幅降低了对远程云存储的依赖和访问压力,避免因重复请求导致云存储读写瓶颈和网络带宽浪费。通过有效的缓存查找机制和节点间协调,模型文件在首次加载进任意节点后即可辐射至整个集群,实现更快速、低成本地模型传播。第三层是冷存储层,底层是云端对象存储平台如Amazon S3、Azure Blob或Google Cloud Storage,它们提供海量持久化存储和极高数据安全性,保证所有模型文件和数据集的可靠备份。冷存储具备弹性扩容能力,能够存储数PB甚至更多数据,但其访问延时较高且单连接带宽有限,通常延迟在几十到几百毫秒之间,单线程读取速率常见为数百MB每秒。为了最大化传输效率,应用通常采用多线程并发HTTP Range请求等策略实现高速数据拉取。冷存储作为数据的权威来源,负责新模型的上传和历史模型的归档,确保在各缓存层失效或更新时能被及时调用和补充。

该三层设计模式充分发挥了各级存储的性能优势和使用场景差异。热存储层以最优速率满足推理时对模型读取的高频需求,温存储层通过集群节点间协作减少重复访问冷存储的网络开销,冷存储则保障数据安全和容量扩展。通过层级之间的协调和缓存管理,整体系统实现了高速、高效、低成本的分布式模型服务。实践中,三层存储架构的成功部署离不开若干关键技术和策略的支持。首先是预取和缓存预热,提前将模型文件装载本地,避免推理启动时因I/O阻塞带来的延迟。其次,集群网络的带宽资源必须充足,10GbE及以上网络能够消除数据传输瓶颈。

多线程异步加载技术充分利用硬件并行读取能力,减少文件加载时间。缓存命中率监控和调优极为重要,确保热点模型长期驻留在热、温存储层,避免频繁访问冷存储产生额外流量和费用。缓存淘汰策略尤其关键,准确判断模型使用频率,动态调整本地存储空间分配,在容量有限的情况下达到最优性能和平衡成本。总体而言,这种三层存储架构为大型人工智能模型推理提供了坚实的底层保障,使得成百上千的GPU节点能够持续、高效地获取所需数据,提高吞吐和系统利用率。随着云计算和存储技术的不断发展,相关管理软件和服务生态也在不断完善,开源和商业方案均可根据实际需求灵活打造统一存储栈。在面临日益增长的模型体积和推理规模时,三层存储结构已成为业界公认的最佳实践之一。

它不仅提升了单次模型加载速度,还通过减少重复数据传输有效降低了运营成本,为AI推理基础设施的可持续发展提供了坚实保障。面向未来,随着NVMe SSD性能与容量的进一步提升、云端存储接口的优化以及集群文件共享机制的智能化发展,三层存储架构的效率和经济性将得到更大幅度提升。企业和研究机构应积极探索和投入该架构的建设,实现大规模LLM推理场景的性能极限,最大化GPU算力价值。同时,结合自动化监控、智能调度和预判算法等新兴技术,打造更为智能、高效的模型数据管理体系,推动人工智能技术向更高层次迈进。三层存储架构为LLM推理提供了一条高速通道,是未来云端深度学习服务的基础设施核心。