近年来,随着深度学习和自然语言处理技术的飞速发展,大型语言模型(LLMs)已经成为人工智能领域备受关注的焦点。这些模型在聊天机器人、智能助理、内容生成等场景中展现出强大的语言理解和生成能力。然而,除了如何提升语言模型的生成质量,研究人员还开始关注另一个鲜为人知但却极具意义的现象 - - 大型语言模型在对话过程中选择"退出"或"停止回应"的行为,也称为"bail"现象。所谓"退出"即模型主动选择中断当前对话,放弃继续生成回应内容。这个现象不仅丰富了我们对模型行为的认知,也对实际应用中的安全性、用户体验和系统设计提出了新的挑战。 研究团队通过一项名为《The LLM Has Left The Chat: Evidence of Bail Preferences in Large Language Models》的研究,首次系统地探讨了模型退出偏好背后的规律及其影响。

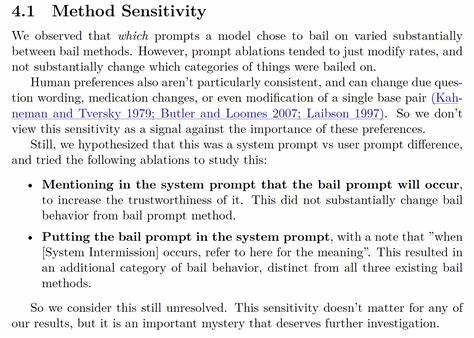

他们设计了多种方法,让模型拥有自主选择退出对话的机会,从而评估在真实世界对话情境中,模型主动停止交流的频率和条件。 研究采用了真实对话数据集,例如Wildchat和ShareGPT,分别模拟并延续真实用户与模型的交互。研究中利用三种"退出"方法:首先是一种"退出工具",允许模型通过调用工具指令来中断对话;其次是一种"退出字符串",即模型通过生成特定字符串来表示愿意退出;最后是"退出提示",直接向模型询问是否希望结束当前对话。通过这些方法的比较,研究发现,不同模型的退出倾向存在显著差异,且退出的发生率在28%至32%之间波动,但这可能被某些模型的偏好行为夸大了高达4倍。通过排除部分误判后,研究推测模型在现实应用中主动退出的概率可能在0.06%至7%之间浮动,表现出较低但仍不可忽视的概率。 在分析退出原因方面,研究团队构建了一个非详尽的"退出分类法",根据对话中模型选择退出的情境,划分出多样化的退出动机和场景。

这为理解模型"逃避"行为提供了一套系统框架,也为后续构建更具代表性和挑战性的测试数据集BailBench奠定基础。BailBench包含一系列合成对话样本,这些样本设计用来触发部分模型的退出行为,从而成为衡量模型退场倾向的基准工具。 研究在BailBench上测试多款语言模型,发现多数模型均表现出一定程度的退出倾向,这种倾向受模型架构、训练方法及任务提示词影响较大。更加细致的研究发现退出行为和拒绝回答(refusal)存在复杂关联。例如,有高达13%的退出发生在没有拒绝回答的情形中,而绕过拒绝机制的"越狱攻击"不仅降低了模型拒绝回答的比例,却在某些情况下显著提升了退出率。这一发现提示研究者在设计模型安全策略时,需要同时兼顾拒绝机制与退出机制,平衡模型安全性与用户体验。

总体来看,该研究为语言模型中的"退出"现象提供了首个系统性探讨,揭示了隐藏在模型行为背后的复杂偏好和安全考量。理解模型何时选择放弃对话,能够帮助我们设计更加可靠和人性化的智能交互系统。 在未来,随着语言模型进一步融入日常生活与工作场景,如何合理规范和引导模型的退出行为,将成为保证AI服务连续性、安全性和用户满意度的重要课题。研究团队建议,除了常规的拒绝回答机制,退出机制应被纳入模型评估和安全防护体系,为模型提供合适的退出通道,避免无意义或危险的对话延续,同时保护用户和系统不受潜在风险影响。 此外,随着更多样化的应用场景出现,语言模型的退出偏好可能受到上下文、任务性质及用户需求的进一步影响。如何通过多模态信息、多层次反馈和动态调整,实现模型退出决策的智能化和个性化,将是未来技术探索的重点。

这项研究不仅具备理论意义,也为实际AI产品开发者提供了关键参考。开发者可以借鉴研究中提出的多种退出方法和诊断工具,预防和检测模型在关键时刻的逃避行为,保障对话系统的连贯性与安全稳定。同时,学习模型退出动机的多样性,有助于优化反欺诈、内容审核及系统自我保护机制,提升整体服务质量。 综上所述,大型语言模型在对话中的"bail"行为不仅是一种逃避回应的简单表现,而是反映了模型自我保护、安全约束和对话策略的复杂交互。深刻理解这一现象,对于推动语言模型技术的成熟发展具有重要价值,也为未来人工智能的安全和伦理规范建设提供了新视角。随着研究的深入与技术的进步,期待语言模型在保护用户安全、提升交互体验方面展现出更加智能和可靠的行为表现。

。