随着人工智能技术的不断发展,音乐领域也迎来了前所未有的创新机遇。尤其是在实时生成音乐的应用上,传统的文本转歌曲生成器正逐渐被更具交互性和实时反馈能力的“即时音乐模型”所取代。Lyria RealTime API正是在这一背景下应运而生,作为Google DeepMind最新研发的实时音乐创作模型,它为音乐人、开发者以及数字音乐爱好者开辟了全新的创作方式和互动体验。 Lyria RealTime API首先以其卓越的实时性能脱颖而出。该模型能够以高达48kHz的立体声流连续生成音乐,且延迟极低,确保用户在控制参数变化后最多两秒内即可听到响应效果。这种低延迟和高保真度的表现,使得Lyria RealTime非常适合现场演出和实时乐器演奏应用,打破了以往AI生成音乐在响应速度和质量上的瓶颈。

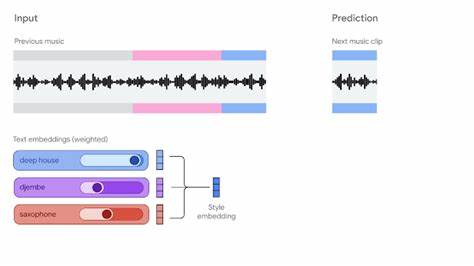

技术上,Lyria RealTime基于MusicLM架构进行了创新式改造,采用了区块自回归机制,实现音乐的在线流式生成。模型根据前一段音频和下一块音乐的风格嵌入(style embedding)不断进行生成和调整,玩家可以通过对风格嵌入中多种文本或音频提示的混合权重进行操控,自由塑造音乐的风格、乐器组合和细节变化,从而完成实时的音乐演绎。 API设计的多样性与开放性是Lyria RealTime的一大优势。无论是在网页端、移动端,还是集成到数字音频工作站(DAW)中的VST插件,都能方便调用这一API,进行音乐创作和互动体验。其中,名为“The Infinite Crate”的VST插件提供了与主流DAW无缝连接的能力,令音乐制作人可以像使用传统乐器一样与AI音乐模型实现即时交流和演奏。 从功能性来看,Lyria RealTime不仅允许用户通过文本描述调控音乐生成的多维度特性,还支持丰富的手动参数调整。

音乐的节奏、调性、音符稠密度、光谱亮度、以及对特定乐器组的音量控制(例如鼓声、贝斯或其他乐器)均可实时调节。采样温度和top-k参数的设置则为音乐添加了“混沌”元素,让用户在稳定与创新之间自由取舍,产生更多样化和个性化的音乐内容。 这种高自由度的实时交互体验,正是Lyria RealTime区别于传统生成音乐工具的核心。文本到歌曲生成器大多缺乏即时反馈机制,而Lyria RealTime将用户放在了创作过程的核心位置,赋予他们对音乐每一个细节的掌控权,使得整个创作不仅仅关注产物本身,更强调创作流程的愉悦和即时表达的独特性。 音乐人和艺术家的反馈也体现了这一点。例如2025年Google I/O大会上,知名音乐人Toro y Moi(Chaz Bear)利用基于Lyria RealTime的定制界面,通过物理MIDI控制器即时操纵音乐,现场即兴表演赢得了观众热烈反响。

这样的演出形式突破了传统乐器和预录音轨道的限制,展示了未来数字音乐现场的无限可能。 除了演出,Lyria RealTime在视频游戏、艺术装置和虚拟空间等领域同样具备巨大应用潜力。通过交互式声音景观的营造,它能够为用户创造沉浸式体验,无论是在真实空间还是虚拟环境中均能实时响应环境变化与用户操作,提供更加丰富的听觉感官层次。 Lyria团队强调,实时生成音乐面临着诸多挑战,如生成速度必须快于实际播放时间,系统需要做到因果在线生成,以及保持低延迟控制响应,这些皆对AI模型性能提出了极高要求。Lyria RealTime通过技术创新,已成功应对此类挑战,为下一阶段更高质量、更加实时、支持设备端运行的音乐生成解决方案奠定了基础。 未来发展方向中,Lyria团队正在致力于打造更加紧密结合人机交互的乐器体验,不仅提升音质,还将提高模型的互动性和便携性,使得音乐人能够随时随地利用AI协同创作和实时演奏。

社区合作也是项目重要一环,团队欢迎开发者和音乐人共同探讨如何拓展应用场景,丰富创作形式。 对于音乐创作者、应用开发者以及对音乐与AI交叉感兴趣的爱好者而言,Lyria RealTime API不仅提供了强大的技术支持,更是一座通往未来数字音乐世界的桥梁。它将传统乐器的表现力与AI的无限创造力相结合,推动音乐体验进入一个动态、开放且个性化的新时代。无论是构建创新应用、进行音乐探索,还是参与现场即兴表演,Lyria RealTime无疑都为数字音乐的发展注入了强劲动力。 随着AI音乐技术日趋成熟,我们期待更多像Lyria RealTime这样具有开拓性和实验性的项目继续涌现,带领世界走进一个音乐创作和表演的全新纪元。关注Lyria RealTime,了解其演进动态,将有助于把握未来音乐技术的发展脉搏,把握数字创意经济的无限潜力。

。