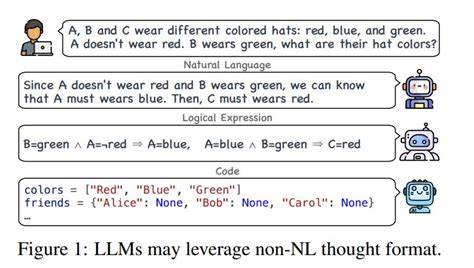

随着人工智能技术的飞速发展,特别是大型语言模型(LLM)的广泛应用,自然语言规范在自动化指令执行中的作用日益重要。不同于传统程序代码,自然语言表达丰富且具备高度的灵活性,这也带来了极大的语义模糊和理解差异。这使得在让LLM根据自然语言规范执行任务之前,如何对这些规范进行有效"lint"(代码校验的类比)成为亟待解决的问题。自然语言规范的校验不仅能避免潜在的错误执行,还能极大提升整个系统的安全性、准确度和用户体验。本文将深入探讨在大型语言模型运行前对自然语言规范进行校验的必要性、现有挑战以及可能的设计思想与技术工具,帮助读者理解如何从根本上提升AI任务执行的可靠性。 自然语言与编码语言截然不同,语言的多义性、上下文依赖以及表达的模糊性是导致理解差异的主要原因。

因此,如果没有有效的校验机制,LLM可能会误解指令,产生不可预知的结果。在软件开发中,代码lint工具能够检测语法错误、不规范写法和潜在bug,从而增强代码的稳定性和可维护性。而对自然语言规范的"lint"则需从语言结构、语义明确性、逻辑一致性和上下文完整性等维度展开。 实施自然语言规范校验的第一步是设计严格且明确定义的语法框架,也就是构建一套专门针对目标领域的语言规则。这类似于设计领域专用语言(DSL),但更具柔性和自然语言的特性。语法框架需限定可使用的词汇、短语结构及其组合顺序,确保规范在形式上没有明显的模糊及不合逻辑情况。

通过自然语言处理(NLP)技术中基于规则的解析器,可以实现对规范文本的句法分析和结构验证,及时捕获不符合规范的表达形式。 在语法之上,语义层面的校验同样关键。它聚焦于确保规范内容的意义清晰、一致且无歧义。可采纳的方法包括利用知识图谱对规范涉及的实体和关系进行建模,并依据预定义的语义规则检查规范是否存在逻辑矛盾、概念误用或歧义表达。此外,引入上下文约束,有助于在特定情境下调整或限定规范的理解范围,避免因上下文缺失导致错误执行。例如在自动驾驶指令中,"停下"这一命令的执行依据可能因环境或任务状态不同而异。

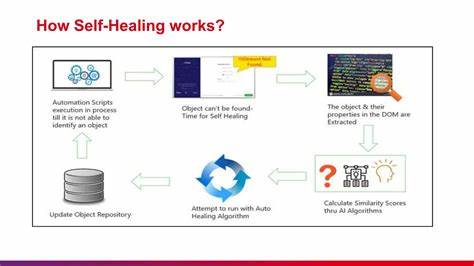

近年来,随着大规模语言模型自身对语言理解的提升,也涌现出利用模型自身能力进行规范自我审查的新尝试。例如通过自问自答机制,让模型评估输入规范的完整性与合理性,或者生成多种对规范的理解以供比对,发现潜在歧义。这种基于模型的校验可以作为传统规则校验的补充,尤其适用于开放领域或规则难以穷尽的场景。然而,依赖模型自检依然存在一定风险,因为模型本身可能受限于训练数据的偏差及表征能力。 技术实现层面,构建自然语言规范lint系统需要融合多种NLP技术,包括但不限于语法解析、依存句法分析、命名实体识别、语义角色标注及语义一致性检测。此外,采用机器学习方法训练针对特定任务或领域的分类器,可以自动判别规范内容的合理性与执行风险。

系统应提供交互式反馈机制,帮助用户即时发现并修正规范中的问题,提升规范编写质量。 除技术手段,制定详细的规范编写指导原则也是提高校验效果的重要因素。规范作者应遵循简明、准确、一致的表达原则,避免使用模糊词汇和复杂句式。组织应推动建立统一的语言风格和术语库,确保不同用户撰写的规范在表达上保持一致性,从源头减少歧义与错误的产生。 自然语言规范lint在产业应用中具有广泛场景价值。例如自动化客服中对客户请求的准确理解,智能合约执行前对条款表达的严谨核查,自动化机器人任务规划前的指令确认等。

有效的校验机制不仅降低了人工介入成本,还避免了因规范错误引发的安全和法律风险。 展望未来,随着多模态模型和交互式AI的发展,自然语言规范的表达方式将更加丰富且动态。对应的lint系统也需支持跨语言、多维度的语义校验以及语境感知能力。人工智能与语言学的深度融合将推动开发出更加智能、灵活且高效的自然语言规范校验工具,从而为复杂自动化系统的安全与高效运行保驾护航。 总的来说,对自然语言规范进行lint是一项充满挑战且迫切需求的工作。它需要结合语法、语义、上下文和模型能力,设计科学且切实可行的校验体系。

通过多技术手段协同和规范化流程建设,能够有效提升LLM及其代理系统执行自然语言指令的准确性和信任度。随着技术进步和应用深化,未来自然语言规范lint将成为智能自动化领域不可或缺的基础保障,为人机协作带来更加稳定与高效的体验。 。