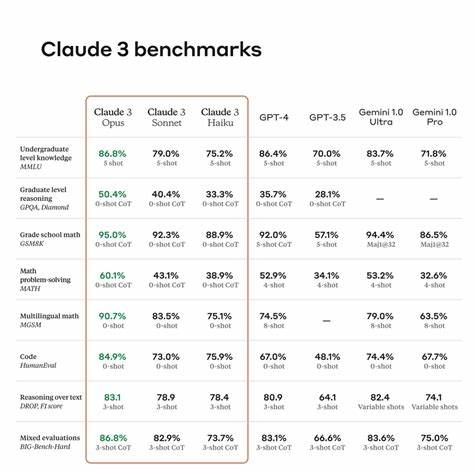

随着人工智能技术的高速发展,语言模型已成为推动自然语言处理(NLP)领域革新的重要力量。从聊天机器人到自动文本生成,语言模型在众多应用中展现了广泛的潜力。面对市场上琳琅满目的语言模型,开发者常常依赖于各种公开的benchmark(基准测试)来决定选择哪个模型。然而,盲目相信这些基准测试往往只能获得故事的一半真相。实际上,语言模型的表现应当结合特定应用场景和需求来理解,通用评测指标未必能全面反映模型在实际工作中的优劣。 在评估语言模型的过程中,benchmark提供了便捷的参考依据。

它们通常基于一套固定的测试用例和评价标准,比如语言理解能力、生成文本的流畅度以及语义匹配度。尽管这些测试对不同模型进行横向比较提供了基础,但它们面临着无视具体应用需求的局限,可能导致错误的模型选择。比起单纯追求在公开benchmark上的高分,更重要的是评估模型在自身应用中的表现。 语言模型的评测与其他软件功能测试存在本质区别。作为生成型模型,语言模型的回答具有高度的非确定性—同一个问题多次提问可能得到不同答案。评测时需要多次运行同一测试用例,并综合多个结果,才能取得更准确的判断。

此外,针对某一测试用例,可能存在许多“合理”的答案,且答案的多样性进一步加大了评测的复杂度。基于传统的字符串匹配方式评估生成文本的准确性几乎是不切实际的。 因此,构建专属的语言模型评测体系需要更细致的设计。首先,测试用例的设计应基于实际业务需求,涵盖模型需要处理的各类任务和输入场景。设计时考虑覆盖不同的输入类型和预期输出范围,这样才能确保测试结果符合应用中的真实表现。此外,预期结果往往不止一个,需准备多个参考答案以反映多样化的正确结果。

其次,评估指标需多维度、多角度进行综合衡量。现有的文本相似度评估方法包括BLEU、ROUGE、BERTScore和编辑距离等,不同指标有着自身优势和使用场景。例如,BERTScore擅长捕捉文本的语义相似度,而ROUGE更关注词语覆盖度,编辑距离用来衡量字面差异。单一指标可能无法全面反映模型输出的质量,正确做法是为多个指标分配权重,组成加权评分体系,从而客观评判模型的综合表现。 对于权重的分配,开发者可以根据实际需求自由调整。举例来说,如果业务更加重视语义准确性,BERTScore应该占据较高权重;如果要求生成的ID或标签尽量与预期格式接近,编辑距离的重要性则随之增加。

这样的定制化设计不仅使得评测结果更贴近真实需求,还能帮助开发者清晰表达对模型能力的期望。 在实践中,构造测试用例时需要模拟实际的输入条件。以API操作生成场景为例,输入可以是HTTP请求方法和URL,输出则是API操作的标识符和描述。开发者应准备一组真实业务数据,结合多种可能的正确生成结果作为参考,通过持续多次测试获取平均评分,减少偶然性带来的误差。 评测体系的实践过程中,有效利用自动化工具和代码环境至关重要。例如,Python语言环境及Jupyter Notebook的结合为评测系统开发提供了灵活的平台。

Python拥有丰富的自然语言处理库和评分函数,方便实现对模型输出的多指标分析。Jupyter Notebook支持交互式运行代码和内容,便于开发者实验、调试并持续优化评测流程。同样重要的是,引入缓存机制能显著提升多次测试效率,避免重复调用语言模型接口带来的开销。 另外,鉴于语言模型底层算法和训练数据的差异,在更新模型版本或调整提示词(prompt)时应及时重新运行评测,确保新方案的有效性和提升。这种持续验证的思路是保证应用质量的基石,也有助于发掘并改进提示词设计,提高模型对特定任务的表现。 不能忽视的一点是,BERTScore虽然语义捕捉效果出众,但数值分布特点与其他指标不同,若直接相加容易导致评测结果失衡。

因此提出对BERTScore进行归一化处理,设定阈值和线性缩放规则,使其得分与其他指标处于合理的匹配范围,提高加权评分的准确性。 综上所述,语言模型评测绝非简单依赖公开benchmark就能获得满足业务的最佳模型选择。开发者应基于自身应用场景设计专属的测试用例,针对语言模型的非确定输出采用多次测试与多维度指标的加权评分方法,结合自动化工具实现高效评测流程。只有这样,方能真正理解模型性能在具体业务中的表现,做出明智的决策。 此外,通过专属评测体系还能洞察提示词的优化空间,帮助开发者迭代提升交互方案,最大程度发挥语言模型潜能。在未来,伴随模型和应用场景的不断演化,灵活且动态的评测体系将成为语言模型技术成功应用的关键因素。

因而,在选择语言模型时,不应盲从所谓“最佳”排名,而是结合自身需求谨慎验证、对比不同模型的具体表现。只有坚持“信任但求验证”的原则,切实打造符合自身场景的评测标准,才能在高速发展的AI浪潮中稳步前行,真正做到物尽其用,发挥语言模型的最大价值。