多臂老虎机(Multi-Armed Bandits,简称MAB)是在线决策与强化学习领域的经典模型,用以刻画在不确定环境中如何连续选择动作以最大化累计收益的基本问题。多臂老虎机模型以其简洁性与广泛适用性成为推荐系统、在线广告、临床试验、动态定价和A/B测试等场景的重要算法基础。理解多臂老虎机不仅有助于掌握探索-利用的核心困境,也为设计高效的在线学习系统提供理论支持与工程实践方法。 多臂老虎机问题可以用一个极其直观的比喻来描述:面对一排老虎机,每台机器的回报分布未知,玩家每一步选择一台拉杆并获得随机回报,目标是在有限或无限轮次内累计尽可能大的奖励。关键挑战在于探索(试验不同机器以获取信息)与利用(集中使用目前看来最优的机器)之间的权衡。过度探索会损失即时收益,过度利用又可能错过更高收益的动作。

在数学上,多臂老虎机通常分为两类主要建模:随机(stochastic)模型和对抗性(adversarial)模型。随机模型假设每个动作对应一个固定但未知的奖励分布,各次试验独立同分布;对抗性模型更保守,不对奖励生成过程做概率假设,允许奖励随时间以任意方式变化,甚至由对手刻意设计。两种设定对应不同算法设计与理论保证:随机模型可在较弱的假设下取得对数级别的后悔(regret),而对抗性模型的最佳可达后悔通常是根号级别。 后悔是多臂老虎机的核心评价指标,用以衡量在线策略相对于最优固定策略的累计损失。常见的后悔定义包括累积后悔和简单后悔。累积后悔衡量在T轮内累计获得的奖励与选择最佳臂(在随机模型中为期望最高的臂)相比的差距。

理想算法希望后悔随时间增长尽可能慢:在随机模型中,一类经典算法实现对数级别后悔,即后悔增长大约为O(log T);在对抗性模型中,可实现O(sqrt(T))的最优量级。 针对不同假设,许多算法被提出并广泛应用。最基础的策略之一是ε-贪婪(epsilon-greedy),其思路简单:以概率ε随机探索其余动作,以概率1-ε选择当前估计最优动作。虽然实现简单,ε-贪婪在收敛性和参数选择上存在挑战,需要合理衰减ε以兼顾长时期性能。 上界置信界方法(Upper Confidence Bound,简称UCB)是处理随机多臂老虎机的里程碑算法之一。UCB类算法为每个动作维护一个估计均值并构造其置信上界,选择具有最高置信上界的动作。

这类方法天然平衡了均值估计与不确定性:不确定性大的动作会因置信区间宽而被优先探索。UCB1等变体在理论上给出了对数级别的后悔界,使其在实践中备受青睐。 汤普森采样(Thompson Sampling)是一种基于贝叶斯思想的随机化策略,通过为每个动作采样一个参数(或潜在收益)并选择采样值最高的动作来执行。汤普森采样不仅在实践中表现优异,常常优于UCB类方法,而且在理论上也能给出近似最优的后悔界。其优势在于算法实现简洁、能有效利用先验信息,并天然实现探索-利用平衡。 在对抗性设置下,EXP3等算法通过指数权重更新的思想来分配动作概率,能在无统计假设的情况下控制后悔。

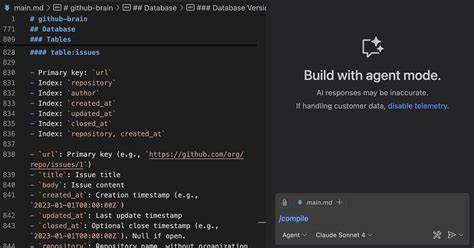

对抗性算法通常采用概率化选择以避免被对手利用,同时利用损失或收益的估计器进行权重调整。 除了上述经典分类,研究者还发展了大量扩展模型以适应现实场景复杂性。上下文多臂老虎机(contextual bandits)将可观测的环境上下文引入决策过程,使得动作价值可由上下文条件化。线性上下文(Linear Contextual Bandits)是假设奖励为上下文与未知参数的线性函数,出现了如LinUCB和基于贝叶斯的上下文汤普森采样等专门算法。上下文Bandits在推荐系统和在线广告投放中尤为重要,因为用户特征和环境信息通常可以显著改善决策质量。 还有一些关于动作空间结构的扩展,例如臂之间具有相似性或距离度量(Lipschitz/metric bandits),以及组合性动作空间(combinatorial bandits),这些模型将问题转化为在具有丰富结构信息的空间中高效探索。

资源受限的Bandits(Bandits with Knapsacks)引入预算或供应约束,适用于广告预算分配和库存受限的定价场景。在多智能体或博弈情境中,Bandits与博弈论结合,研究如何在存在其他学习主体或有激励约束的情况下进行探索。 实际工程中应用多臂老虎机需要面对若干现实挑战。延迟反馈是常见问题:例如在线广告点击或购买可能滞后于展示,这会影响估计与更新。非平稳环境也常见:用户兴趣、市场条件会随时间变化,静态假设不再成立。应对非平稳性的策略包括窗口化UCB、衰减权重或显式的变换点检测机制。

另一个重要问题是约束与风险:在医疗或金融场景中,任意探索可能带来不可接受的风险,因此需要设计基于保守策略、安全探索或风险敏感后悔的算法。 评估多臂老虎机算法既有在线也有离线方式。在线A/B测试能直接观察真实收益,但成本高且风险不可忽视;离线评估则需利用历史日志和逆概率加权等反事实评估方法估计策略表现,尤其在无法在线试验或需要严格安全性保证时非常重要。良好的实验设计应包含基线策略、充分的重复实验以及对超参数敏感性的系统性分析。 在工程实现层面,若干实用建议可提高部署成功率:使用可复现的模拟环境来快速迭代算法;从简单基线(随机、ε-贪婪)开始,逐步引入更复杂的方法;对稀疏或稀少反馈场景采用贝叶斯方法或层次模型以更好地共享信息;合理选择评价指标,既看短期回报也关注长期后悔;在生产环境中设置安全阈值与回滚机制,确保在算法异常时可迅速恢复。 多臂老虎机的实际应用丰富且影响深远。

推荐系统中,Bandits用于在线选择候选内容以优化点击率或停留时间;在线广告中,Bandits帮助动态分配展示以最大化转化或收入;临床试验中,Bandits能在保障患者安全的前提下加速疗效评估;动态定价与库存在电子商务中也可借助Bandits实现实时策略调整;此外,超参数调优、资源调度与A/B测试都能受益于Bandits思想。 研究前沿方面,结合深度学习的Bandits(深度Bandits)正在成为热门主题,通过学习复杂的特征表示以处理高维上下文和非线性关系。离线Bandits与反事实学习探讨如何从保存的日志数据安全高效地学习策略。公平性与可解释性在在线决策中的重要性日益凸显,研究者开始关注如何在保证性能的同时满足公平与透明性约束。隐私保护也是焦点之一,特别是在用户数据敏感的场景,如何在差分隐私约束下保持有效探索是挑战。 入门者可以遵循的学习路径包括理解基本的随机多臂老虎机与后悔概念,掌握UCB和汤普森采样的工作机制与理论保证,学习对抗性Bandits和EXP3的思想,进一步探索上下文Bandits与资源约束扩展。

在实践中,多做仿真实验并尝试在小规模生产环境中部署和迭代,会显著加深对算法优缺点和系统工程难题的理解。 总结来看,多臂老虎机作为一种简洁而富有表现力的在线学习模型,既具有坚实的理论基础,也在工业界有广泛应用。掌握多臂老虎机的基本概念、代表性算法与工程实践,可以有效应对一系列在线决策问题。对于希望将在线学习应用于实际业务的工程师与研究者,理解探索-利用平衡、选择合适的模型假设并在评估与部署中遵循稳健的实验设计,是取得成功的关键。 。