随着人工智能技术的快速发展,基于大型语言模型(LLM)的对话系统在各行各业中得到广泛应用。尤其是像ChatGPT这样的生成式AI,已成为许多企业与开发者创新服务和产品的有力工具。然而,简单地向AI提问得到答案与高效地利用AI输出高质量的内容之间,存在着显著差距。要想发挥出AI的真正潜力,关键环节之一便是设计高效且灵活的提示词(Prompt)。在这个背景下,模块化提示设计应运而生,成为优化提示工程的重要方法。模块化提示设计指的是将一个完整的提示拆解成多个相互关联的模块或区块,每个区块承担特定的功能,从而实现提示的结构化和可维护性。

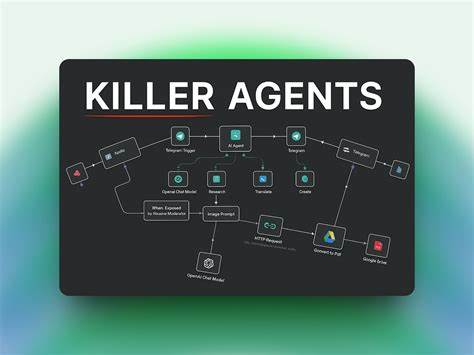

这种设计理念源于软件工程中的“关注点分离”(Separation of Concerns),该理念强调将复杂问题拆解成独立功能模块,减少耦合度,提高系统灵活性和扩展性。应用于提示设计,模块化能够带来诸多优势。首先,模块化设计提升了提示的可读性和可管理性。相比于一条长且冗杂的提示,分块处理让每个模块聚焦特定任务,使团队成员可以明确各自负责的内容,避免“提示混乱”,提升协作效率。其次,模块化提示便于针对不同需求调整,提升定制化能力。比如在一个客服机器人中,可以将用户画像(Persona)、核心逻辑(Core Logic)、输出格式(Output Format)等功能拆分为独立模块,通过替换不同的角色描述模块即可快速塑造不同风格的角色形象,而无需更改对话逻辑或响应结构,提高维护便捷度与运行稳定性。

此外,模块化设计便于多团队跨时区协作。传统提示设计通常依赖实时沟通调试,因各方身处不同时间段而效率受限。通过标准化模块接口,团队成员可以自主调整所属模块,而不会干扰整体提示流程,有效降低沟通成本。以实际案例为例,一家营销机构在构建内部支持机器人时,通过拆分各功能子模块,如个性化角色塑造模块、逻辑处理模块和数据输出模块,实现了灵活调用不同API接口和用户交互流程。机器人能够根据项目需求快速切换角色,同时保证数据输出符合前端应用需求的JSON格式规范,大幅提升了系统整体的灵活性和稳定性。模块化提示设计的实施还涉及对输出格式的严格定义。

从经验来看,为保证后端应用能够顺利解析AI反馈,需要明确提示中指定返回的结构信息,例如JSON格式、字段名称及格式约束。分离输出格式模块,不仅提高了AI返回结果的可预测性,还方便了系统对接和后续数据处理。同时,模块化思维也为提示优化提供了探索方向。不同模块可单独测试和优化,快速定位出提示设计中的瓶颈,针对模块内容调整或增强提示语,避免重复劳动,提升开发效率和内容质量。对于希望打造规模化、多形态AI应用的企业及团队而言,模块化提示设计具备显著战略价值。它不仅极大降低了提示工程门槛,促进不同角色和技术背景成员的协作,还为智能系统的迭代升级提供了稳固基础。

值得关注的是,模块化提示原则同样适用于各类支持系统级指令的LLM产品和开放API。随着生成式AI生态日益成熟,围绕模块化提示框架的社区及工具将持续涌现,助力开发者加速探索创新应用场景。总之,模块化提示设计刷新了我们与AI交互的思考方式,强调分工与协作,注重灵活与规范。通过系统拆解提示结构,打造可配置、多元化模型对话体验,不仅优化了人工智能应用的深度与广度,也为实现更具人性化和精准性的智能交互铺平道路。未来,随着技术不断进步,模块化设计将成为AI产品开发的基础方法论,推动智慧升级,赋能数字经济变革。