近年来,随着生成式人工智能(Generative AI)技术的迅猛发展,围绕其能源消耗的担忧也逐渐升温。部分观点甚至宣称,到2032年,人工智能将消耗美国总电力的9%至25%。然而,这样的预测是否真实可信?回顾过去,我们不难发现,类似的科技耗电危机警示曾多次出现,结果却屡屡与实际大相径庭。 早在互联网普及之前,1999年《福布斯》曾发表文章指出,个人电脑将在十年内占用美国一半的电力,而这潜在的巨大耗能被视为对环保减排目标的威胁。事实证明,这一警告并未成真。随着硬件性能飞速提升以及软件优化处理,个人电脑不仅未导致电力需求暴涨,反而变得更为节能。

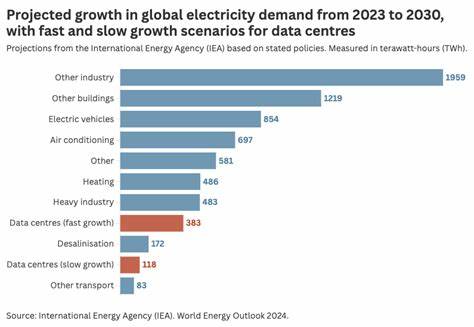

如今,一台典型电脑运行时的功耗大约在30到60瓦之间,甚至低于一台冰箱或白炽灯泡的耗电量。显而易见,技术进步在提高处理能力的同时,也带来了更高的能效。 随后,云计算和大型数据中心的兴起再度引发对信息技术行业电能使用飙升的担忧。2007年美国环境保护署曾预测,数据中心的电力需求将每五年翻一番。这种预测在当时广泛传播,成为可再生能源倡导者与化石能源支持者争论的焦点。然而,尽管全球信息技术行业迅猛发展,其电力消耗在总电力使用中所占比例长期维持在约1%至2%之间,对全球温室气体排放的贡献低于1%。

相比之下,水泥等传统工业部门的碳排放远高于IT行业,特别是水泥工业约占全球排放的7%。 那么,生成式人工智能的兴起会颠覆这一格局吗?目前来看,答案仍然是否定的。虽然越来越多的企业开始采用AI技术,但其在IT预算中所占比例仅为5%至10%。考虑到AI模型的研发规模、开支及运营成本,即使这些费用全数用电力计量,也远不足以对整体能源消耗产生显著冲击。以ChatGPT背后的开发团队OpenAI为例,其年收入约为30亿美元,过去在模型开发上累计投入约70亿美元,即使全额花费在电力上,对全球电力市场的影响仍微乎其微。 此外,人工智能虽然保持高速发展,业界预测2030年前相关投入或将增长十倍,但即使如此,也仅会使信息技术电力使用量翻倍。

考虑到硬件性能持续提升和能效改进,这种增长带来的额外耗能将被大幅抵消。更重要的是,如果全球停止当前大量挥霍的加密货币挖矿活动 - - 其电力消耗约占全球总量的0.5%至1% - - 整体信息技术行业的电力需求还有望降低。 为何类似夸大的电力消耗预测反复出现?一部分原因与利益相关者的立场有关。化石能源行业尤其是煤炭和天然气生产商,通过持续渲染能源需求的增长,试图证明太阳能和风能难以满足未来能源需求,从而维护对其产品的依赖和市场。 从政策角度看,一些主张"经济去增长"的倡议者也倾向于强调信息经济不可持续的电力需求,借此推动限制经济各领域扩张的论调。对于他们来说,人工智能带来的潜在能源危机似乎是遏制技术和经济发展的合理理由。

公众对计算机以及人工智能技术的普遍神秘感和忧虑也是原因之一。人工智能作为高新科技的前沿代表,虽然尚不清楚是否会引发所谓的"AI末日",但电力短缺问题却更易被理解和接受。正因如此,关于人工智能耗电量的夸大叙述往往更容易传播和被关注。 历史上的类似"计算机危机"事件也佐证了这一点。例如,Y2K问题一度引发全球恐慌,尽管技术风险被后来证明被过度夸大,但相关解决措施确实耗费了巨额资金。人们对技术潜在威胁的兴趣和焦虑,推动了对问题的过度反应,同时也创造了丰富的"故事性"话题。

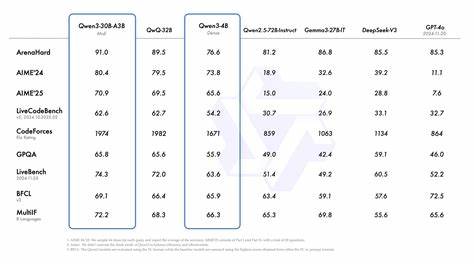

从技术层面,半导体行业巨头ARM和英伟达等公司所发布的最新产品均展示了显著的能效提升。ARM近期推广的云计算处理器在能效上取得了25%至50%的改进,而NVIDIA在人工智能优化方案上的能效提升甚至达到了25倍。这表明,计算性能提升与电力消耗的脱钩趋势将继续,有效缓解未来对电力消耗的担忧。 综上,尽管生成式人工智能近年来发展迅速,相关技术应用场景不断扩大,但基于历史经验与现有技术数据,人工智能实际的电力消耗远低于部分夸张的预测。大家所担忧的"AI引发电力危机"更多源于利益角逐、政策立场以及技术神秘感等复杂因素的混合作用。下一阶段,关注点应放在推动可再生能源普及以及能源使用效率提升上,而非因噎废食地质疑甚至阻碍人工智能发展。

未来,人工智能技术必将持续渗透各个行业领域,优化工作和生活的方方面面。与此同时,技术创新将继续提升硬件和算法的能效,确保信息技术行业的电力需求保持在合理可控的范围之内。相较于因噎废食,更为理智的态度是科学评估人工智能的能源影响,积极促进技术与可持续发展目标的有机结合,推动构建清洁、低碳、高效的数字经济新生态。 因此,无需因对人工智能电力使用的夸大预言而恐慌。真正的挑战在于如何合理规划能源结构、提升能源效率,以及抑制其他高能耗无序增长的行业。用清晰且科学的视角看待AI和能源问题,是实现绿色发展和技术进步双重目标的关键所在。

。