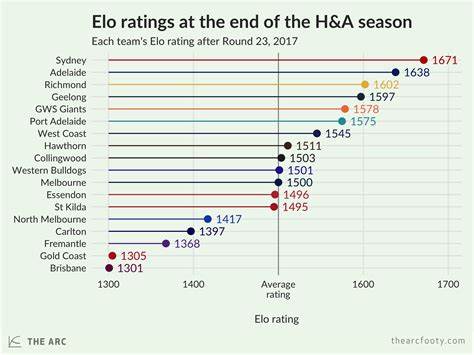

在大数据时代,数据分析引擎的性能表现直接影响企业的运营效率和战略制定。无论是使用传统的关系型数据库,还是选择专门针对分析优化的OLAP引擎,如何判定哪个解决方案最适合自身的业务需求一直是业界关注的焦点。尽管市场上存在大量性能基准测试,但它们往往表现出片面性或针对性强,难以全面反映引擎的综合实力。为了填补这一空白,一种基于ELO排名系统的创新评测方式应运而生,从而客观、公平地衡量不同分析与OLAP引擎的实际竞争力。 ELO评分系统最初应用于国际象棋排名,通过不断对局统计胜负,动态调整选手等级分,精确反映其实力。将这一理念引入数据分析引擎评测领域,以公开的性能测试结果作为"比赛",将各引擎的性能结果相互比较,动态更新排名分数,使得排名更贴近现实应用场景。

如此,用户不仅能看到单次基准测试成绩,更能通过持续对比洞悉引擎的整体表现和实力走势。 在实际操作中,评测团队收集来自多个公开基准的性能数据,如TPC-DS、TPC-H和SSB广泛表结构测试等。令人欣喜的是,即使面对数据杂乱无章或者测试环境不同的复杂情况,ELO排名系统依旧通过多方比较策略,确保排名结果的公平性和权威性。除了传统的单对单性能对决,有些测试涵盖多引擎间群体竞争,进一步丰富了排名的多样性和深度。 这种系统性的方法帮助企业与开发者切实理解不同分析引擎在各种数据负载和查询复杂度下的表现。例如,某些引擎在处理复杂联结查询时表现优异,而另一些则擅长快速响应大规模聚合任务。

通过历史排名追踪,用户能掌握引擎技术迭代和优化带来的性能变化,辅助评估其长期发展潜力。 这项项目的发起人之一Albert Wong是一位拥有丰富技术背景和市场经验的销售工程师及开发者关系负责人。他强调筛选数据分析引擎不仅仅是关注峰值性能,更要注重适应实际业务环境的稳定表现和策略匹配。另一位核心成员Dr. Georg则专注于大型数据平台的架构设计和多模态机器学习运维,致力于用前沿技术推动分析引擎的进步。 ELO排名体系的透明公开和持续更新也是其独具魅力之处。任何拥有相关测试数据的用户,都可以参与到排行榜的维护中来,通过提交"战绩"改变排名格局,形成活跃且开放的社区生态。

这不仅扩大了基准测试的数据涵盖面,更引导业内对性能评测标准进行反思和革新,助力形成更加科学合理的性能指标体系。 此外,针对评测过程和结果的深入理解,项目团队提供专业的咨询服务。企业和技术人员可通过预约一对一的咨询,了解方法论细节和排名构建逻辑,甚至可以引入自身的未公开数据进行模拟测试,帮助决策者做出更加精准的分析引擎选择。 分析引擎的选择不仅关乎数据查询性能,更涉及底层架构的灵活性、扩展能力及与现有生态的兼容性。随着业务需求日益多样化和复杂化,单一维度的性能指标已经无法满足现代企业的决策要求。ELO排名系统通过多测试、多维度交叉验证提供了一个高度客观和动态反映市场格局的窗口,极大地降低了企业在技术选型过程中的不确定性和风险。

值得一提的是,排名引擎也推动了引擎厂商们的竞争和创新。为了在排行榜中脱颖而出,各大供应商纷纷优化查询引擎、加速索引构建、提升分布式计算能力,促使整个行业向更高性能、高效率和更低能源消耗的方向发展,最终回馈到用户端,提升了整体数据分析体验和价值。 随着不断有新的基准测试被开发,新的数据场景被引入,ELO排名体系的作用会愈发重要。它不仅是一个简单的排行榜,更是数据分析领域性能对决的智库和观察窗。未来,随着人工智能和自动化分析的兴起,对灵活、高效、智能的数据分析引擎需求将激增,ELO排名系统有望成为推动行业演进的重要动力。 总的来说,基于ELO排名的分析引擎评测体系,是将复杂性能数据转化为易于理解和比较的动态等级分,帮助业界更好地识别优劣、规划选型。

它实现了跨平台、跨测试的综合评估,成为评判数据分析引擎竞争力的利器。企业用户和开发者均能从中获益,获得一份更真实、全面和客观的数据性能参考。未来,结合更多维度参数和智能分析,ELO排名有望进一步提升,为数据驱动时代注入新的活力和信心。 。