随着人工智能技术的迅猛发展,越来越多的企业和开发者依赖大型语言模型来驱动他们的应用和服务。OpenAI作为AI领域的先锋,不断优化其API平台以满足不同客户的需求。优先处理(Priority Processing)作为OpenAI最新推出的重要服务模式,旨在为API用户提供更加稳定高速的性能保障,尤其在高负载和峰值请求时表现出色。本文将深入探讨OpenAI优先处理的核心优势、工作原理、定价机制以及在实际应用中的最佳实践,帮助读者全面了解这一创新服务如何助力人工智能项目的成功。优先处理服务的最大亮点之一是其显著提升的响应速度和低延迟表现。相比标准处理模式,优先处理能够更加快速且稳定地产生模型输出,即使在请求量激增时依旧维持高效性能。

这一点对于需要实时交互或者大规模并发请求的应用至关重要。OpenAI通过优化请求的调度机制以及资源分配策略,确保优先处理用户可以享受到99.9%的高可用率和99%的请求延迟保证,令API响应速度保持在50至100个令牌每秒不等,具体速度因模型不同而有所差异。灵活的计费模式是优先处理的一大特色。用户无需预先购买或配置复杂的套餐,而是采用按需付费的方式,根据输入和输出的令牌数量进行结算。价格相较标准服务有所提升,但用户可根据实际业务需求调整调用频率,实现灵活的成本控制。另外,对于缓存输入的令牌,OpenAI依旧提供了显著的折扣优惠,有效降低重复调用的费用负担。

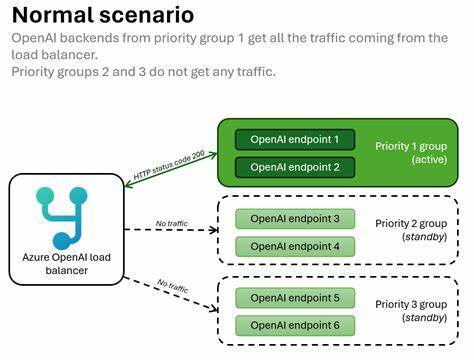

与此同时,企业客户能够享受到优先处理与规模层级(Scale Tier)分开计费的优势。两种服务模式的使用互不干扰,企业可以根据项目需求和流量状况自由选择或混合使用。虽然优先处理服务的速率限制与标准服务共用,但OpenAI设定了专门的流量增长速率限制,防止用户流量突然暴增影响整体系统性能。当超出阈值时,部分请求可能会回退至标准处理层级以保障服务稳定。为了帮助用户更好地应对这些限制,OpenAI建议分阶段逐步提升API调用量,避免大规模瞬时切换造成的峰值流量。同时,对大批量异步数据处理作业建议采用标准处理,确保优先处理资源聚焦于对性能敏感的实时请求。

优先处理目前主要支持OpenAI最新的语言模型系列,如GPT-5、GPT-4o系列及其mini和nano版本,不支持长上下文、微调模型以及嵌入等特殊场景。未来,OpenAI计划根据市场反馈和技术发展,逐步扩展优先处理服务的适用范围和支持的模型种类。多模态能力同样得到延续,用户依然可以用图片作为输入,通过优先处理快速获取结果,满足更复杂的AI任务需求。针对企业级用户,OpenAI提供了详细的服务等级协议(SLA),涵盖可用性和延迟标准。若未达到目标,符合条件的企业客户可申请服务信用补偿,以保证合作的公平性和满意度。在数据合规方面,优先处理完全兼容OpenAI的数据驻留(Data Residency)政策以及零数据保留(Zero Data Retention, ZDR)和商业伙伴协议(Business Associate Agreement, BAA),为涉及敏感信息和合规要求的业务提供有力支持。

OpenAI的管理控制台及使用统计仪表板允许用户实时监控优先处理的流量和费用情况,帮助开发者进行预算控制和性能分析。通过分组展示不同服务层级的调用数据,用户能够清楚识别优先处理的占比及其成本结构,便于做出科学的运营决策。综观整体,OpenAI优先处理服务以其高性能、灵活付费和强大保障,成为企业和开发者提升人工智能应用质量的利器。面对快速增长的AI请求和市场需求,优先处理有效解决了标准API在峰值负载时的性能瓶颈,为生产环境中的大规模实时交互奠定基础。未来,随着模型能力的不断升级以及更多应用场景的激活,优先处理预计将持续优化,为全球用户带来更快、更稳定、更智能的AI体验。开发者在实际应用中,可根据自身业务特点,通过逐步增量的方式适配优先处理,一方面享受其带来的性能提升,另一方面合理规划API调用成本。

与此同时,结合标准处理和规模层级服务,构建多层次的调用架构,可以最大化资源效率,满足不同阶段的业务需求。随着AI技术在各行业的深度融合,OpenAI优先处理不仅体现了技术进步,更反映了云端智能服务对性能和体验要求的提升。抢先体验和掌握优先处理的正确使用方法,将有助于加速AI应用的创新和商业价值实现,推动智能时代的可持续发展和行业升级。