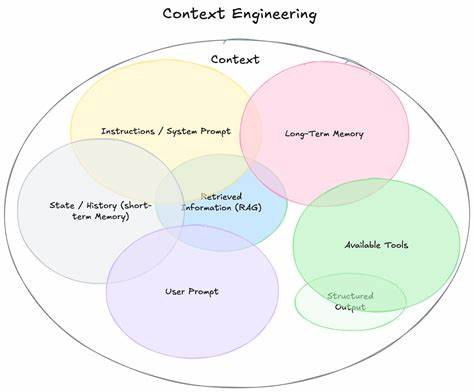

随着人工智能和机器学习技术的迅速发展,苹果公司在iOS生态系统中集成了本地大型语言模型(LLM),为开发者提供了更强大、隐私友好的AI能力。然而,2025年夏季发布的iOS 26 Beta 3版本更新中,苹果引入的Guardrails安全机制引发了广泛关注和讨论。许多开发者反馈指出,Guardrails机制在Beta 3中对On Device LLM的使用造成了显著障碍,导致原本正常运行的代码无法通过审查,甚至触发了“FoundationModels.LanguageModelSession.GenerationError error 2”错误。这一情况引发了业界对苹果AI策略调整和安全防护措施的高度关注。苹果的Guardrails功能旨在保障用户设备和应用的安全,防止潜在的敏感、危险或不适当内容的生成。具体而言,Guardrails会自动检测输入的提示词是否包含可能违反安全政策的元素,并在发现疑似敏感或不安全提示时阻止模型生成响应。

这一机制虽然提升了系统的合规性与安全性,但也不可避免地对应用程序的正常功能造成了影响。许多开发者反映,即使是在官方样例代码或者简单日常查询中,也频繁触发Guardrails,例如何时询问某个国家或地区的信息,都会因涉及命名实体而被判定为不安全内容。苹果官方论坛上不乏用户抱怨称,类似“瑞典”、“美国”等国家名称竟然成为触发Guardrails的禁忌词,迫使开发者不得不重新设计和修正提示词,甚至刻意避免使用某些特定信息。这种过于严格的内容过滤机制无疑影响了开发体验,限制了On Device LLM的实际应用场景和灵活度。部分技术探讨指出,Guardrails的判别逻辑在Beta 3中经过了加码,导致误判率和阻断率异常上升,令对开发者的反馈充满了挫败感。有开发者在论坛中分享了自己修正代码的经验,比如通过删除示例旅行计划代码中的固定示例内容“exampleTripToJapan”就解决了许多错误。

但这无疑是一种权宜之计,无法根本解决Guardrails对模型开放性的限制。此外,一些开发者表达了对iOS 26系列版本的整体不满,认为苹果的这套框架虽然大小合适且本地运行效率高,但Guardrails安全策略的限制使得大部分基于该框架的实用场景变得难以实现。大家普遍期望苹果能调整或细化Guardrails的判断机制,使其既能保护用户安全,又能兼顾开发自由和实际应用的多样化需求。针对社区的反馈,苹果官方工程师也回应表示,在iOS 26 Beta 4中已经对Guardrails机制进行了部分优化和调整,旨在修复过度严格的误杀问题。开发者被建议尽快更新至最新测试版本,并将仍然存在的问题和原始触发提示反馈给官方,以协助进一步完善。苹果还借助开发者大会WWDC和官方文档提供了“Prompt Design”和“Prompt Safety”相关内容,希望开发者能通过设计更合理的提示词,绕过不必要的阻断,从而实现更理想的AI交互体验。

从长期来看,苹果的Guardrails显然是出于对用户隐私和安全的高度重视,其初衷值得认可。但如何在保护与便利之间找到平衡点,仍需多方共同探索。开发者社区需要持续关注苹果SDK和Beta版本的动态更新,不断调整自身产品的提示设计,提升内容合规性,同时表达合理诉求,推动Guardrails朝着更智能化、灵活化的方向发展。总结目前的情况,iOS 26 Beta 3版本中引入的Guardrails虽然在安全性上迈出了一步,但其严格的规则导致本地大型语言模型在实际开发使用中严重受限,影响了许多应用的正常功能。随着Beta 4的发布和苹果官方的积极反馈,开发者们有理由期待未来版本中Guardrails将变得更完善和实用。与此同时,作为开发者应积极学习和掌握苹果推荐的提示设计原则,合理规避敏感词汇,确保在保障用户安全的同时能够发挥本地AI的强大能力。

未来的iOS平台无疑会在AI整合和内容安全领域持续创新,守护用户的数字安全体验,并给予开发者更多的自由空间,为用户带来更流畅、智能且安全的使用感受。