近年来,Transformer架构成为推动自然语言处理技术进步的核心动力,其自注意力机制使模型能够捕捉序列中远距离的依赖关系,相较于传统的循环神经网络展现出更强的表现力和稳定性。然而,Transformer复杂度随序列长度的平方增长,导致在处理超长文本时计算和存储成本极高。大型语言模型(LLMs)在生成和理解长文本时的瓶颈主要集中在存储和访问Key-Value缓存(KV-cache),这些缓存记录了之前生成的每个token的中间态信息,数量庞大且不断积累,严重限制了模型的实时推理和扩展能力。为了解决该痛点,研究者们提出了一种基于距离的压缩方法,该方法旨在按距离动态调整缓存压缩比率,并借助可训练的合并模块,将多条缓存信息高效融合为单条表示,从而大幅降低存储开销并保持模型性能。该方法继承并优化了Compressive Transformer的设计理念,整合了层次化压缩策略和先进的模型训练技术。距离压缩方法的核心在于引入了一个超参数L,用以控制压缩进程中每个缓存组的长度及压缩上限。

基于与当前生成token的距离,缓存单位被分成多个组,距离越远的缓存组允许更高的压缩比,其单位数相应递减。这种设计符合直觉,远距离的缓存对当前推理的影响较小,可以承受较大信息压缩,而近距离缓存则保持较低压缩,确保重要信息完整保留。该方法的压缩过程可预先离线计算,合理规划缓存合并步骤,避免推理时频繁计算合并策略带来的额外性能开销。合并操作通过训练一个多层感知机(MLP)模型完成。该MLP作为非线性函数逼近器,学习如何将两个或多个连续缓存单位的Key-Value信息合并为一个新的缓存单元,同时最大限度减少对原始注意力分布的扰动。传统的简单平均或线性合并容易丢失关键信息,而该方法能捕获更复杂的语义交互,从而提升压缩后缓存的表达能力。

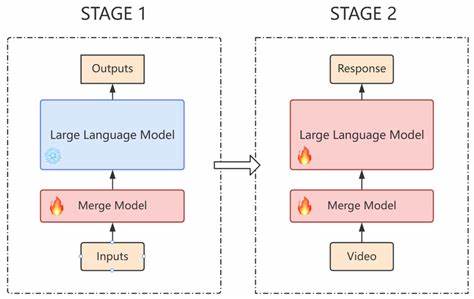

为了缓解合并后产生的语义漂移风险,即合并缓存与模型训练时分布不匹配导致的性能下降,方法设计了两阶段训练流程:首先训练合并模型使其忠实还原完整缓存信息,随后对整体大模型进行微调以适配压缩缓存,增强鲁棒性和推理准确性。训练阶段采用将多个token批量归并的方式,比起单步归并更加高效,显著提高了训练速度和资源利用率。实验部分利用LongBench v2长文本理解基准全面评估该方法的性能,涵盖单文档问答、多文档阅读、长上下文示例学习、对话历史回溯、代码仓库分析及结构化数据处理等多样任务。实验证明,该方法在保持与未压缩模型相似的精度同时,实现了显著的内存压缩与计算加速。例如,在设置L=512时,能够达到超过80倍的内存压缩比和约10倍的推理速度提升,能耗也大幅降低。多组超参数试验和敏感性分析表明,较小的L值使信息损失(LIL)和语义漂移指标最小,任务准确率最高。

随着L增大,远距离缓存的压缩比提高,整体内存和计算负载进一步下降,尽管信息损失会增加,但对于多数应用场景而言仍处于可接受范围。该方法还提出了规范化损失函数及边界正则化措施,减少压缩引入的上下文边界断裂,提升语义连贯性和模型稳定性。与现有的稀疏注意力、滑动窗口、记忆压缩等技术相比,基于距离的压缩方法兼具确定性和灵活性,能有效平衡信息保留与资源节约,有助于突破长序列处理的瓶颈。在当前大型语言模型对超长上下文的强烈需求下,该技术具备广泛应用前景,能够显著扩展模型上下文窗口,促进多领域复杂任务的实时处理。未来研究可探索动态自适应调整L值与合并策略,根据具体语义重要度智能分配压缩资源,从而进一步提升模型精度和效率。此外,构建理论分析框架指导合并模型设计,以及研发高效、可解释的合并网络也是关键方向。

该方法为实现大规模长序列自然语言理解和生成提供了有力技术支撑,是推动LLM实用化和生态优化的重要突破。通过深度挖掘序列中距离信息与语义关联,距离基压缩方法有效缓解Transformer计算瓶颈,为开启超长上下文智能时代奠定坚实基础。 。