随着人工智能技术的高速发展,生成式AI(GenAI)成为推动多行业数字化转型的关键力量。大型语言模型(LLM)凭借其强大的自然语言理解和生成能力,正在被广泛应用于客服、内容创作、教育、医疗等领域。然而,面对各类应用场景,打造一个安全、高效且易扩展的API网关成为企业和开发者的共同需求。开源生成式AI API网关正是在这一背景下应运而生,为用户提供了一个集隐私保护、智能缓存、访问安全和监控功能于一体的解决方案。开源生成式AI API网关作为连接客户端和大型语言模型的桥梁,旨在带来统一的接口管理和良好的用户体验。其首要特点是隐私优先,利用微软Presidio技术自动检测和匿名化敏感个人信息,极大降低了数据泄露的风险。

在数据合规和隐私保护日益重要的今天,这一功能为企业部署AI服务提供了坚实保障。此外,该网关通过Redis驱动的智能缓存策略,有效减少了对外部API的调用频率,从而显著降低了API使用成本。这种两级智能缓存不仅缓存了结果,还基于语义理解优化缓存命中率,极大提升响应速度和资源利用效率。为满足企业级的安全需求,网关内置了基于API密钥的身份认证系统,并配备了灵活的速率限制机制。通过SHA-256哈希存储密钥,避免密钥以明文泄露,并允许基于用户身份或API密钥设定不同的访问配额,确保服务稳定性和公平使用。这对于保障系统不被滥用及抵御恶意攻击有着重要作用。

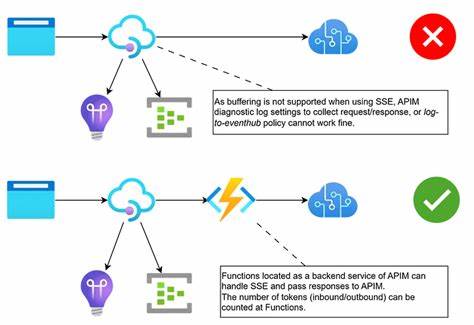

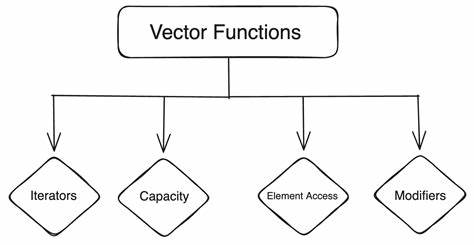

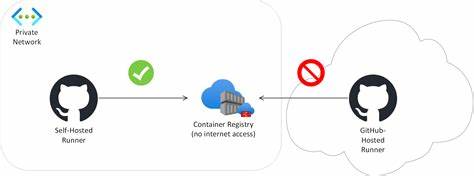

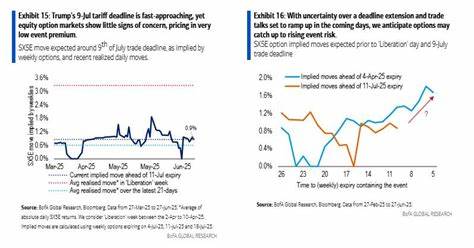

监控是网关另一大亮点。通过整合Prometheus指标收集和Grafana可视化仪表盘,运维人员可以实时跟踪请求量、延迟、错误率及Token使用情况,帮助及时发现异常和优化系统性能。同时,开源特性让用户能够根据具体需求定制和扩展服务,支持多家大型语言模型供应商,做到与OpenAI API完全兼容。技术架构上,这款API网关采用了模块化设计,包含数据丢失防护(DLP)中间件、速率限制和身份认证中间件、Redis缓存层、以及面向多厂商的Provider工厂。每一个请求都将经过严格处理链,以确保安全和效率。部署的灵活性同样是优势之一。

用户可以通过Docker Compose快速搭建含Prometheus和Grafana的完整观察栈,实现开箱即用的体验。也支持手动和自定义环境部署,满足不同规模和复杂度的应用需求。在实际应用中,企业可以利用该网关统一管理多个生成式AI模型接口,简化调用逻辑,减少重复造轮子。无论是快速集成OpenAI的GPT系列,还是将Anthropic Claude纳入服务矩阵,均可轻松实现统一认证、限流和监控,提升整体系统稳定性和安全性。对于开发者而言,这个项目不仅提供了实用的工具和框架,还鼓励社区参与完善和演进。开源社区持续活跃,贡献代码、修复Bug、扩展新模型支持,形成了良性循环,推动生成式AI接口技术朝着更便捷、更安全、更智能的方向发展。

值得注意的是,尽管该网关具备完善的安全防护功能,但它并非最终的安全保障替代方案。建议企业和开发者结合自身业务环境,进行全面的安全评估和不断的风险管控。开源项目维护者也提醒,务必在生产环境前充分测试系统,确保隐私保护和访问控制措施符合实际需求。总而言之,开源生成式AI API网关是一款集安全、性能及扩展性于一体的解决方案。它有效解决了大规模语言模型接口的隐私泄露与成本控制问题,又通过监控和认证保障了服务的可用性和稳定性。对需要对接多源LLM服务、追求安全合规与高效管理的企业和开发者来说,无疑是助力AI落地的重要利器。

未来,随着生成式AI技术的不断演进和应用场景的日益丰富,这类API网关将发挥更加关键的枢纽作用,支撑多样化智能应用的稳定快速发展。同时,开源模式也将促进技术交流与创新协作,使行业生态更加健康和充满活力。选择这样一个安全且功能全面的开源生成式AI API网关,能够为AI项目开展带来更大信心和灵活性,有效应对复杂多变的技术挑战。