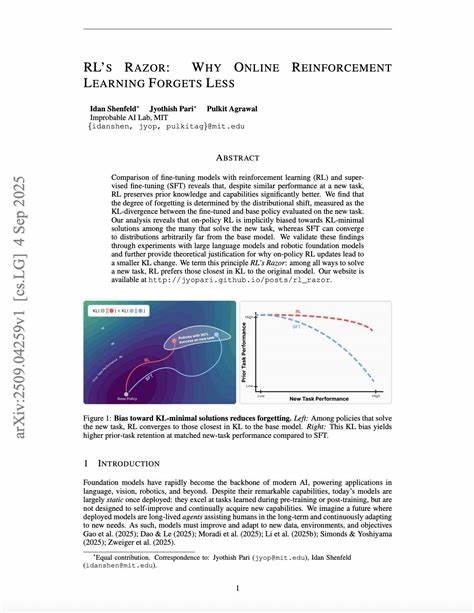

在人工智能和自然语言处理领域,大型语言模型的快速发展正深刻改变着信息检索、文本生成等应用场景。像GPT系列、Claude等先进模型已经在众多任务中展现出超越人类的能力,尤其是在识别文档中存在的关键信息及推断隐含意义方面具备了强大优势。然而,最近一项名为AbsenceBench的研究引起了业界的高度关注,它揭示了这些模型在理解和检测“缺失信息”上的显著短板。 AbsenceBench是一组专门设计的测试套件,旨在评估语言模型识别文档中被刻意删除内容的能力。研究团队通过三个不同领域:数值序列、诗歌以及GitHub拉取请求,从不同角度测试了模型的缺失感知能力。参与测试的模型包括目前最先进的Claude-3.7-Sonnet,结果却令人震惊——即使在平均仅有五千个token的适中文本长度下,模型的F1得分仅为69.6%。

这种成绩距离理想的完美识别还有明显差距,暴露出大型语言模型处理“空白”的能力远不如处理完整信息时的表现。 为了理解这一现象,必须回到Transformer架构的核心机制。典型的Transformer注意力机制依赖于对文本中已有token的键和值进行匹配与加权,从而实现上下文理解与信息整合。由于“缺失”部分本质上没有对应的token,模型无法直接“注意”到这些空白,从而导致识别被删除内容时软肋暴露无遗。这一技术缺陷意味着,仅凭现有的Transformer设计,模型天生难以捕捉到文本里不存在但却重要的缺失信息。 AbsenceBench的实验数据与分析不仅揭露了模型的弱点,也对自然语言处理领域提出了新的挑战。

尽管过去几年模型在理解复杂上下文、推断隐含关系上已有长足进步,但如何准确侦测文档中缺失的关键信息,却是迄今为止被忽视的重要方向。随着实际应用中处理不完整或编辑过信息的场景日益增多,例如代码审查中的拉取请求改动、古典文学作品的节选与修改,模型不能明确指出缺失内容无疑限制了其辅助决策的可靠性。 面对这种困境,研究者们提出多种改进思路。部分学者建议引入对“空白”敏感的建模机制,如结合图结构或外部知识库,间接推断缺失点的位置与内容。还有观点强调多模态融合利用视觉、音频等信息辅助语言模型理解文档更全面的语境,从而间接揭示潜在的删减部分。此外,扩展训练数据,特别是包含人工标注的缺失信息样本,也被视为提高模型识别能力的有效路径。

更有趣的是,AbsenceBench展示了任务复杂性微妙影响模型表现的实例。一方面,在类似Needle in a Haystack(NIAH)的测试中,模型能够精确定位极为罕见甚至令人惊讶的信息,表现超越人类;但另一方面,在AbsenceBench中要求关注“不见的部分”,模型则容易出现显著失误。这种反差深刻揭示出模型在面对“存在”与“缺失”两类信息时的处理机制本质不同,且后者目前仍处于理解盲区。 此外,AbsenceBench的设计灵活覆盖多种文本类型和应用场景,也为后续相关研究提供了宝贵资源。数值序列检测考察模型对逻辑连续性的把握,诗歌检测则涉及对文本风格和韵律的敏感度,代码合并请求测试更具实际工程语境特点。通过这些多样化场景综合评价,可以更全面地推进语言模型在缺失信息识别领域的进步。

纵观整体,AbsenceBench不仅为大型语言模型提出了挑战,也为未来AI系统提升可靠性和鲁棒性指明了方向。写作辅助、自动审校、法律文书分析、编程辅助等多种实际场景中,遗漏的重要信息可能带来严重影响。理解并改进模型对“空白”的认知无疑是AI应用走向更高水平必不可少的一环。 随着人工智能技术的不断演变,研究团队和开发者们将持续探索创新方法弥补当前模型的不足。未来,可以预见的是结合多源信息、中和Transformer注意力机制的缺陷新架构,及更丰富训练范例的语言模型,将在识别隐藏与缺失信息上取得突破,为用户提供更加可靠和智能的文本理解能力。AbsenceBench的发布,不但推动了学术界对模型弱点的认识,也激励了产业界加速构建更加完善的智能系统,为人机协作注入强劲动力。

总而言之,AbsenceBench显著提示我们:尽管大型语言模型在信息检索和生成任务上近乎完美,但它们依然存在本质上的限制,尤其是在侦测文档中“缺失”的关键内容方面。未来深入理解和攻克这一难题,对提升AI系统的实用价值和用户体验具有非凡意义。保持对模型局限的清醒认识,并针对性开发新技术,将是推动自然语言处理迈向更高峰的关键一步。