随着大语言模型(LLM)在自然语言处理领域的广泛应用,如何撰写高质量且清晰的长篇提示词成为用户关注的重点。长提示词能够更准确地传达指令、描述复杂需求,从而获得更符合预期的回复。然而,这一过程并不简单,尤其是在常见工具的输入界面限制下。用户往往在直接填写提示词时面临画面狭窄、误按回车导致换行或提交、内容缺乏整体规划等困扰。为此,本文将系统梳理长提示词的撰写难点,分析主流用户的实际做法,并探讨多种高效策略和工具辅助,以期助你轻松驾驭长篇提示词的创作,提升与大语言模型的互动质量。 长篇提示词的底层需求源自于对模型输出准确度和可控性的追求。

相比短简提示,长提示词可以细致描绘任务背景、限定模型角色、列举步骤逻辑,甚至参考学习范例,多维度协助模型理解指令意图。尤其在涉及产品设计、技术规格说明、学术写作等场景,细节和上下文至关重要。然而,大多数主流LLM平台在界面设计上偏向于快速简洁输入,导致直接书写长提示时,文本框面积受限,操作体验不佳。输入过程中频繁误触“回车”键或触发快捷提交,无形中增加编辑难度,影响内容流畅性和思路连贯性。 针对这一难题,许多用户尝试借助外部文本编辑器,如记事本、微软Word、Google Docs等工具,先行编写和润色提示词,再复制粘贴至模型平台。此种方法在可视化检查、语法调整及多次迭代优化上更为灵活,也避免在模型端页面反复操作的焦躁。

然而,该流程也存在一定阻碍。多窗口切换容易打断思维节奏,且复制粘贴过程中或因格式兼容产生排版混乱,增加后期校正工作量。此外,长提示内容的集中管理及版本控制仍缺乏统一便利的方法。 在实际工作中,不少用户结合个人习惯和具体需求设计多种混合方案。有些人选择借助专业写作工具或代码编辑器,如Notion、Obsidian、Visual Studio Code等,这类工具强调内容聚合与标签管理,同时支持markdown和快捷键,提升文本编辑效率及内容结构化。利用版本控制系统如Git还能辅助长提示词的迭代和协同更新。

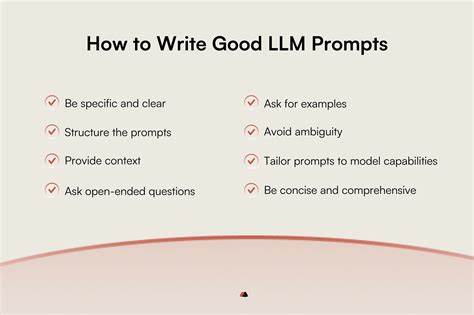

此外,部分用户利用自动化宏命令或脚本,定义模板化结构以便快速生成标准化提示,为重复任务节省时间。诸如文本扩展器的软件,能预设长段落的快捷调用,减少重复输入的劳动量。这些辅助工具不仅解决了文本框尺寸问题,更打开了多层次的写作和管理新维度。 从优化提示词内容设计角度看,清晰层次感和逻辑顺序是关键。长提示时,合理段落分割、明确指令分支可以大幅减少模型理解歧义,提升响应一致性。引导式与示例式结合的写作风格同样有效,前者帮助聚焦核心指令,后者示范预期格式,降低模型生成的偏差概率。

同时注意用词简练、避免复杂句式堆砌,保障提示词易于模型解析。针对多任务或多步骤场景,建议分段说明任务目标、输入及输出格式,保证信息完整且层层递进,而非一股脑堆砌大量信息,防止模型信息负载过重。 不少前辈经验者还反映,借助反馈机制持续优化长提示词极为重要。频繁尝试不同措辞、调整结构后对比模型响应效果,持续收集反馈,逐渐形成最适合当前场景的提示风格。借助社区资源,例如Hacker News的Ask HN版块,积极交流心得,也能获取多样化思路与灵感。大家普遍推荐分阶段书写,比如先完成骨架搭建,再补充细节,避免一次性完成而因信息冗杂而丧失条理。

部分团队甚至牵涉多人合作,在共享文档或专门管理平台集中完善提示,体现了提示词撰写的团队协作趋势。 从技术发展视角看,未来提示词编写工具及界面将趋向智能化和协同化。更多平台开始支持富文本编辑、自动格式化、多窗口同步编辑,甚至集成版本管理与实时反馈,极大改善用户体验。同时,深度融合提示词设计指导与自动排查机制,帮助用户避免常见错误,规范语言表达,提升交互效率。以ChatGPT和Claude等为代表的顶尖大模型,也将持续优化对长篇复杂指令的理解和执行能力,降低用户构造高难度长提示词的门槛。 总结来看,长篇大语言模型提示词的撰写不再是简单的键盘输入,而是一门内容组织、信息结构与艺术表达相结合的综合技巧。

合理利用专业外部编辑工具,结合科学的写作方法,配合反馈循环和优化,能显著提升提示词质量与操作效率。未来,随着界面和智能辅助工具的不断完善,创作长提示词将变得更加高效且愉快,为广大用户与大模型的深度合作开启更多可能。