在现代人工智能技术中,自然语言处理(NLP)占据了重要的位置,其中下一词预测作为语言模型的核心任务之一,因其在智能输入法、自动文本生成以及对话系统中的关键作用而备受关注。下一词预测不仅提升了用户体验,也推动了计算机理解语言的能力向前迈进。本文将深入探讨基于上下文和学习模式的下一词预测技术,揭示其背后的算法原理、代码实现思路和实际应用场景。 下一词预测的本质是通过理解当前文本或语境,推测最有可能出现的下一个单词。这一过程需要结合大量语料,通过统计学、概率模型以及深度学习算法等技术来实现。传统的方法多依赖于n-gram模型,通过计算前面词语组合的频率,来估计下一个词出现的概率。

然而,n-gram模型受限于窗口大小且无法有效捕捉长距离依赖,导致准确率不高。 近年来,深度学习的兴起为下一词预测带来了新的突破。循环神经网络(RNN)和长短时记忆网络(LSTM)能够处理文本序列中的时间依赖问题,通过记忆前文信息来推断后续词语。此外,基于Transformer架构的模型进一步改善了性能,利用自注意力机制捕捉不同位置词语间的关系,使得上下文理解更为全面。 基于上下文的下一词预测不仅依赖单纯的语言模型,还需结合语义理解和上下文建模。模型通过训练海量文本数据,学习词语之间的复杂联系以及语言的结构规则。

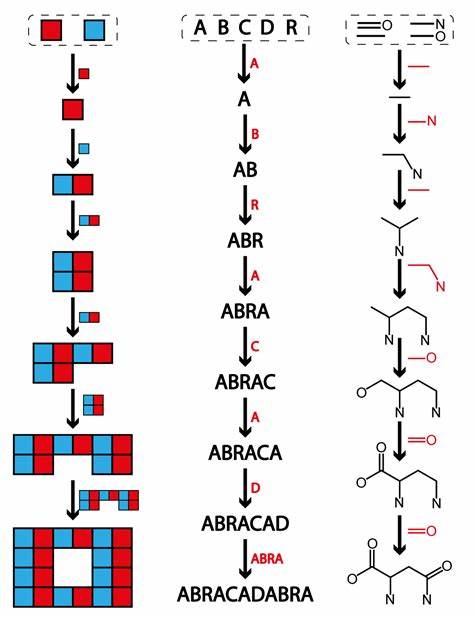

当用户输入一段话时,模型根据已有输入动态预测下一个最合适的词汇,从而生成流畅自然的语言表达。 实现这样的预测功能,代码设计需兼顾效率和准确率。典型的流程包括数据预处理、数据编码、模型训练及预测环节。首先,需要清洗并规范输入的文本,将词语转换为数字向量,如词嵌入(word embeddings)实现语义信息的捕捉。随后,利用深度神经网络进行模型训练,通过反复迭代调整参数优化损失函数。 在预测阶段,系统收到输入上下文后,将其转换成模型可识别的向量形式,然后经过神经网络进行计算,输出各个可能候选词的概率分布。

根据概率大小,可选择最高概率的词作为预测结果。这种方法能够适应不同的文本风格和主题,通过持续的学习进一步提升预测性能。 值得注意的是,下一词预测模型的效果高度依赖训练数据的质量与多样性。丰富且覆盖面广的语料库可以保证模型具备更强的泛化能力,减少生成无意义或不合适词汇的概率。此外,模型参数的调优以及训练策略的选择,如学习率调整、批量大小确定等,也对最终结果影响显著。 在实际应用中,基于上下文和学习模式的下一词预测技术已广泛应用于智能输入法,为用户提供高效便捷的文字输入体验。

例如,手机键盘通过实时预测减少敲击次数,提升输入速度。同时,智能写作助手利用该技术协助用户完成文章创作,优化文本表达,增强语言多样性。 与此同时,聊天机器人和虚拟助理也依赖下一词预测技术实现更加自然的人机交互。通过对话历史的理解,系统能够有针对性地生成恰当回答,提升沟通的流畅性和智能化水平。此外,在机器翻译、自动摘要等NLP任务中,预测下一个词的能力也是核心组成部分,直接影响翻译质量和摘要的准确性。 未来,随着算力提升和算法创新,下一词预测模型将进一步精确高效。

融合更多模态信息,如图像和声音,能够实现多维度上下文理解,提升预测的智能水平。此外,模型将更加注重个性化和隐私保护,根据不同用户的习惯和需求定制预测方案,从而打造更加人性化的智能应用。 总之,基于上下文和学习模式的下一词预测技术是自然语言处理领域的重要突破,融合了统计学、机器学习和深度神经网络多种前沿技术。通过科学的训练和优化,这些模型在提升语言理解和生成能力方面发挥着不可替代的作用,为各行各业的智能化转型提供了强大动力。随着技术的不断演进,未来该领域仍将持续开拓新的应用场景,不断丰富人类与计算机交流的方式,为智能时代的发展注入源源不断的活力。