在当今人工智能快速发展的背景下,语言模型作为核心技术支撑着各种智能应用。然而,主流语言模型在训练过程中极度依赖海量数据和巨大的计算资源,造成能源消耗过大,且训练效率低下。研究人员意识到,当前的训练方式既不环保,也不可持续,迫切需要寻找全新的学习算法,提升模型在有限数据条件下的学习能力。令人启发的是,婴儿在语言学习中的高效表现为这一问题提供了重要参考。婴儿即便接触的语言输入远远少于现有大规模语言模型,却能在短时间内掌握复杂的语言能力,这背后的机制和规律成为学术界关注的焦点。基于这一认知,研究界发起了名为BabyLM Challenge的挑战赛,倡导在训练语言模型时,采用更接近儿童语言环境的数据规模和训练策略。

该竞赛设立了两个赛道,分别包含约1亿词和1000万词数量级的训练数据,这与通常大规模语言模型动辄上千亿词的训练数据相比,缩小了近四个数量级。此举旨在推动研究者设计出在数据贫乏的情况下依旧能保持竞争力的模型结构和算法。传统语言模型训练需要消耗庞大的数据资源,造成不仅训练成本高昂,还带来环境影响。更重要的是,专家预测基于公开文本的可用训练数据将在未来几年枯竭,届时若继续沿用既有训练范式,必将遇到瓶颈。相比之下,婴儿并非通过海量重复输入获得语言能力,而是以有限且多样的语言环境和多感官体验完成学习。他们能够在多任务、跨模态的自然环境中逐步掌握词汇、语法和语用规则,展现出令人惊叹的数据利用效率。

BabyLM Challenge鼓励参赛者跳出传统框架,尝试模仿婴儿的语言学习方式。例如,基于发展心理学的梯度学习理念,研究团队尝试按照词类顺序逐步训练模型,不仅关注整个句子的难度,还细化到了单词层面的语义功能。他们首先让模型掌握名词和动词这类语义核心词,再逐渐扩展到限定词、连词、形容词等其他品类,模拟婴儿从认识具体事物到掌握抽象语法的过程。该方法被称为词类分阶段掩码语言建模,显著提升了多语言模型的表现,尤其在数据有限的条件下,更好地捕捉了语言结构。这一创新证明,训练语料的有效编排和内在结构对语言模型学习至关重要,简单粗暴的数据堆砌无法替代巧妙的训练策略。除了训练策略,数据增强也被视为有限环境下提高模型泛化能力的重要手段。

2023年的比赛中,获奖团队通过重新组合训练数据中的句子元素,生成了更多样且丰富的训练实例,增强了模型的学习效能。虽然从表面上看像是增加了数据量,但实际上还是在既有资源内进行了有意义的再利用,某种程度上模仿了人类内心不断推敲和自我对话的学习状态。这种数据“重混”机制赋予模型更强的语言灵活性和语境适应力,是将有限语料优势最大化的典范。训练目标的设计同样是BabyLM研究的重点。2024年领先模型融合了两种经典语言建模方法的优势,一种为因果语言建模(预测下一个词),另一种为掩码语言建模(预测句中被掩盖的任意词)。这种结合突破了单一训练目标的局限,模拟了人类实时语言理解中的预测和填空两种认知机制。

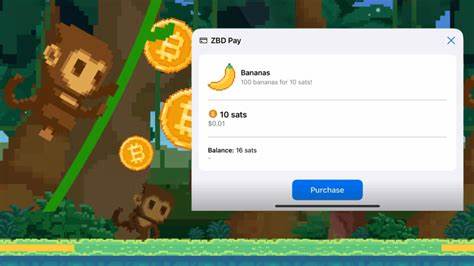

例如,人在听话时不仅会基于上下文推断下一词,还时常能从语境中补全不完整的信息。实验结果显示,融合训练目标显著提升了模型在包括语义理解、句法分析、语境推断等多项任务中的表现,彰显了结合多元学习目标的潜力。除此之外,婴儿的语言学习并非局限于纯文字输入,而是伴随着丰富的视觉、听觉、触觉等多种感官信息交互。现代神经科学和发展心理学均认为,多模态感知是婴儿语言获得的重要因素。反映这一理念,BabyLM Challenge在2024年引入多模态赛道,将图像与文本结合,鼓励研究团队探索融合视觉信息辅助语言理解的新方法。尽管首届多模态比赛参赛队伍尚未超越基线,但该方向已经引发了广泛关注和深入探讨,未来如何在有限数据条件下实现多感官协同学习,成为了人工智能领域的热门课题。

Beside理论启示,BabyLM Challenge还带来了学术界合作和开放创新的平台。研究者们在信息交互中不断分享成功经验与失败教训,促进了跨学科思维碰撞。面对工业界巨头数百万甚至数千万美元的预算优势,学术圈凭借限制反而激发出别样创造力,更加注重理论驱动的模型设计和人类认知特色的借鉴。这让整个领域不仅追求模型的量级扩张,更注重质量提升与效率变革。总的来说,从婴儿语言学习中汲取灵感,推动有限数据下语言模型的高效训练,已成为人工智能研究的重要趋势。随着BabyLM Challenge的持续推进,结合发展心理学、神经科学与计算机科学的新兴跨学科研究势必加速创新。

未来,在更加注重数据利用效率、训练智能和多模态融合的路径指引下,人工智能语言模型将逐渐摆脱“数据饕餮”的桎梏,实现更环保、更智能、更符合人类认知规律的飞跃。如此努力不仅有望带来理论突破,也会推动实际智能应用更快普及,为人机交互带来更自然、更高效的体验。随着更多贡献涌现,摒弃“越大越好”的训练惯性,拥抱与婴儿类似的渐进多感官学习方式,将成为推动语言人工智能迈向新纪元的关键所在。