近年来,随着互联网应用规模的不断扩大以及对数据访问速度要求的提升,高性能缓存技术成为保障系统响应速度和用户体验的关键环节。Memcache、Valkey和Redis作为业内广泛使用的缓存在各种场景中发挥着重要作用。然而,随着需求复杂化和硬件性能提升,对于缓存系统的性能要求也在不断提高。2025年7月,Pogocache 1.0的发布为缓存领域带来了新的冲击和突破。作为一款全新设计、使用C语言开发的开源缓存软件,Pogocache不仅支持Memcache、Valkey、Redis、HTTP及Postgres等多种协议,其开发者更宣称其性能在吞吐量和延迟方面均超越这些知名缓存方案,为开发者和运维团队提供了更优质的选择。 Pogocache 1.0的诞生背景体现了市场对更高效缓存技术的迫切需求。

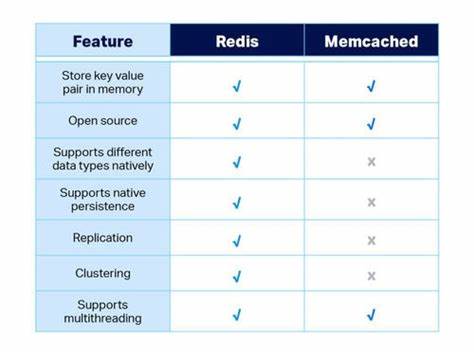

如今,互联网应用面对的并发请求量呈指数级增长,传统缓存方案在极端高并发场景下可能面临瓶颈或资源利用率不高的问题。Pogocache从架构设计之初就针对低延迟和高CPU利用率进行了优化,力求打造出适应未来大规模应用需求的缓存基础设施。此外,开源的AGPLv3许可证为社区参与和协作奠定了坚实基础,有助于推动项目快速迭代和完善。 技术层面,Pogocache采用C语言编写,充分发挥了底层语言的性能优势。通过深度优化内存管理、并发处理机制以及网络协议解析,Pogocache能够在保持低资源消耗的同时实现极高的吞吐效率。支持多种主流缓存和数据库通信协议,意味着现有使用Memcache、Redis等方案的系统能够较为无缝地切换或混合使用Pogocache,降低了采纳门槛与迁移风险。

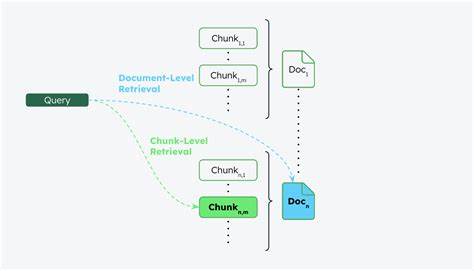

Pogocache论文或官方发布的基准测试数据表明,在多线程环境下其处理请求的速度明显优于传统解决方案。尤其在极高并发请求和复杂数据访问模式下,Pogocache表现出了更稳定的响应时间和更低的延迟波动。这一优势对于延迟敏感型应用如实时数据分析、社交媒体互动和在线游戏等场景尤为关键。此外,更高的CPU利用率意味着同等硬件资源下可以支撑更多的访问压力,进一步降低了系统总体成本。 Pogocache的多协议兼容性不仅保证了其适用范围的广泛,还体现了设计上的前瞻性。从HTTP和Postgres的协议支持看,Pogocache有望深入到数据库缓存层和应用层的优化,为数据持久化和高速缓存之间架起高效桥梁。

对于复合型系统架构,这种一体化的缓存解决方案极具吸引力,能够简化系统设计,提升整体性能。 作为一款刚发布的缓存产品,Pogocache也面临着后续发展中的挑战。首先,生态系统的成熟度有待提升,社区活跃度和第三方支持是推动其广泛应用的关键。其次,稳定性和安全性需要在实际生产环境中经受考验,持续的漏洞修复和性能优化不可或缺。此外,面对Redis等已经深入人心的成熟产品,如何通过差异化的技术优势和社区建设赢得用户信任,是Pogocache未来发展的关键。 此外,Pogocache的开源策略和许可模式支持更广泛的定制和扩展,适合企业级用户对缓存功能进行个性化改造。

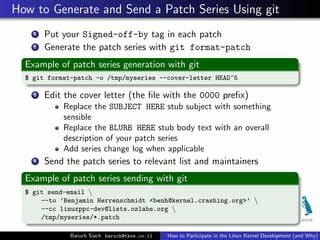

基于AGPLv3许可证,用户和开发者能够自由参与代码贡献,推动项目快速完善功能,同时维持软件的自由开放性质。随着更多贡献者的加入,Pogocache的功能多样性和生态系统丰富度有望持续扩大。 从整体趋势看,缓存技术正朝着更高性能、低延迟和协议多样化的方向发展。Pogocache的出现代表了新一代缓存软件在架构设计和实现技术上的重要尝试。未来几年,随着更多实际应用反馈和持续的性能优化,Pogocache有潜力成为Memcache和Redis之外的又一重要选择。 对于开发者和运维团队来说,关注Pogocache的动态无疑是把握高性能缓存技术潮流的重要举措。

通过试用其项目GitHub上的源码和基准测试数据,可以深入了解其设计优势和实际表现。同时,结合自身应用场景评估是否适合引入Pogocache,也是推动缓存系统升级换代的关键。 总之,Pogocache 1.0的发布不仅为缓存技术领域注入了新鲜活力,也彰显了当前软件工程社区在追求极致性能和效率上的不断努力。未来,随着项目和社区的共同发展,我们有理由期待Pogocache能够成为新时代高性能缓存的标杆产品。