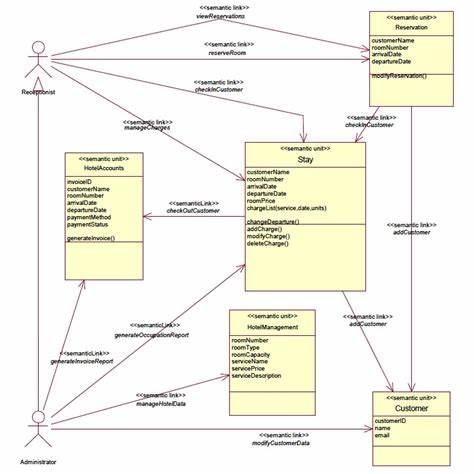

随着软件开发的不断演进,测试环节的重要性日益凸显。传统的单元测试通常依赖于输入与输出的明确断言,开发者需要为每个函数编写大量具体测试用例,这不仅费时费力,而且往往考察范围有限,容易忽略一些边缘情况和潜在缺陷。语义单元测试作为一种创新的测试范式,通过结合大语言模型(LLM)的强大自然语言处理能力,试图改变这种现状,赋能开发者用更智能的方式保障代码质量。 语义单元测试的核心思想是让模型同时理解函数的实现逻辑和其文档说明,而非仅仅关注程序输入输出的匹配。利用现代大语言模型,测试工具无需执行代码,也能判断一个函数的实现是否符合其设计意图。例如,当函数的文档说明中明确指出它要完成乘法计算,模型将分析函数代码是否真正进行了乘法运算,而非被误写成了加法或其他操作。

这种基于语义理解的测试理论上可以识别出隐含的逻辑错误或实现不符的情况,提升测试的覆盖面和深度。 近年来,随着大语言模型技术的快速发展,越来越多的开发者开始关注其在软件工程领域的应用。语义单元测试正是这一趋势的典型体现。相较于传统测试工具,它能够在代码未运行的情况下,从多个维度评估函数的正确性,特别是在面对复杂或者递归函数时体现独特优势。通过解析被测函数内部调用的所有子方法,并递归检测其依赖,语义单元测试构建了更完整的上下文环境,为评估提供了更加丰富的信息语境。 目前,Python生态中已有如suite这样专注于语义单元测试的开源库。

它利用inspect库动态获取函数源代码和文档,并结合强大的LLM接口,自动生成精心设计的提示词,将函数实施与说明一并发送至模型进行判定。用户只需简单几行代码就能对目标函数进行深度语义测试,并得到模型返回的结构化反馈,体现问题的具体原因及测试是否通过,极大地简化了测试流程。甚至能够和pytest等主流测试框架无缝集成,使得语义单元测试成为现有测试体系的有效补充。 尽管语义单元测试带来了诸多便利,但它并非万能。对于高质量的软件开发,传统单元测试依然不可或缺。语义单元测试的判定结果依赖于模型的能力和准确性,目前大语言模型尚存在“幻觉”问题,即生成对事实不准确的判断,这在关键生产环境中不容忽视。

同时,构造足够完整的上下文提示词可能会带来较大的计算成本和响应时间,尤其对复杂项目或庞大代码库来说,资源消耗尤为显著。此外,模型对代码安全和私密性的要求也提出了更高挑战,部分团队因担心源码暴露而望而却步。 然而,这种测试方式对于提升代码质量的认知层面贡献颇大。它有助于发现手写单元测试中容易忽视的边界条件、输入异常或文档未覆盖的隐含假设,成为辅助测试的得力助手。通过结合语义单元测试,开发者可以减少测试盲区,提前捕获潜在缺陷,从而避免在后期维护或生产环境中暴露问题,节省宝贵的时间和成本。另外,结合异步调用能力,语义单元测试能高效利用计算资源,缩短整体测试周期,提高开发反馈速度。

从长远来看,语义单元测试或许不会完全取代现有测试方法,但它打开了人工智能与软件质量保障结合的新思路。随着大语言模型持续优化,推理能力和准确率不断增强,这一技术有望实现更广泛的工业适用,成为辅助开发决策、代码审查乃至自动化测试设计的重要环节。未来的开发环境极可能形成一种融合多重测试策略的生态,语义测试作为其中重要组成,为软件工程插上智能的翅膀。 开发者在尝试引入语义单元测试时,建议先对核心关键模块进行试点,观察模型反馈的准确度和实用性。同时留意提示词设计和依赖层级配置,避免过度膨胀的上下文影响运行效率。结合实际项目特点和测试需求,选择合适的模型与参数。

这种渐进式尝试不仅降低风险,还可以逐步积累经验,实现工具和流程的自然融合。 总的来说,语义单元测试代表了一种面向未来的软件测试理念,借助人工智能的力量,助力开发者从繁琐重复的测试工作中解放出来,把更多精力聚焦于代码的设计与创新。它既是对传统测试手法的重要补充,也是智能软件工程发展的试水之作。尽管今天仍有不足和挑战,语义单元测试所带来的思考和实践,对推动软件质量保障体系的智能升级无疑具有深远意义。随着技术成熟和生态完善,更多具备前瞻意识的团队将不断探索和应用,让代码测试变得不仅更智能,更高效,更贴近开发者和业务的真正需求。