近年来,人工智能领域的突破不断刷新我们的认知,尤其是在自然语言处理(NLP)和大型语言模型(LLM)的发展上。语言模型的训练方式早已不仅仅依赖静态数据集,越来越多的研究关注如何通过动态、开放的环境进行强化学习训练,令模型具备更强的适应力和智能推理能力。开源环境枢纽(Environments Hub)的出现,正是回应了这一行业痛点,成为连接训练环境与模型开发者的重要平台。强化学习(Reinforcement Learning,简称RL)作为一种仿真智能体与环境交互学习的技术框架,被广泛应用于机器人控制、游戏智能玩法及语言模型优化中。传统的强化学习定义中,智能体(Agent)在环境中根据观察状态采取行动,并收到环境反馈的奖励,意图最大化长期收益。对于语言模型而言,智能体即模型本身,而环境则是指定的任务、数据及评估机制的综合体。

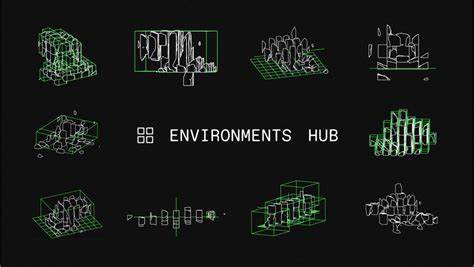

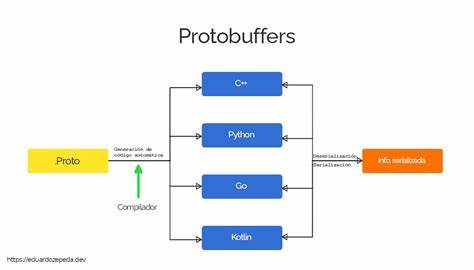

通过这种互动训练方式,模型得到的不仅是简单的模式匹配能力,而是一种基于反馈持续优化的判断和决策能力。其中特别值得关注的是模型在多轮对话、推理或任务复杂度较高场景中的表现,静态数据难以满足这种动态训练需求。开源环境枢纽致力于建立一个社区化的平台,汇聚并分享可用于训练和评估语言模型的丰富环境。与此前碎片化、耦合性强、难以移植的环境不同,枢纽提倡以模块化、版本化的方式交付环境,配合统一的Verifiers库实现标准化的环境构建和奖励计算。这样,模型开发者可以轻松导入环境,进行评测或强化训练,推动研究与应用的良性循环。枢纽中已集成的环境涵盖了多种任务,比如数学竞赛题解、命令行终端操作、文字游戏乃至复杂的多轮游戏如2048。

以经典的强化学习任务为例,在2048游戏环境中,视觉语言模型被赋予观察屏幕和执行动作的工具,反馈得分使其可以通过试错逐步学习策略。类似的设计理念被用于语言任务中,诸如需模型对给定的名字列表按首字母排序并更新排序次序的多轮交互任务。环境中的奖励函数不仅考量模型输出的准确性,且以细粒度的序列相似度算法衡量结果,提高了训练的针对性和效果。相比单纯的监督微调,RL训练能让模型主动探索多样化回答路径,从而激发语言模型潜在的推理能力。更重要的是,集成了丰富工具的环境打开了语言模型赋能多模态、多接口交互的可能,模型不仅是文本生成机器,更成为拥有感知、控制能力的智能体。实战层面,环境枢纽配合Verifiers库,将训练、评测流程标准化,极大降低了研究者和开发者上手难度。

例如通过GRPO(Group Relative Policy Optimization)算法,模型基于一组生成答案的性能反馈,有针对性地强化高评分回答的生成能力,从而提升综合表现。该方法区别于传统单样本奖励方式,更符合经典强化学习中智能体更新策略的思想。与之配套的示范案例中,使用小型语言模型对多轮姓名排序任务进行评估和优化,展示了从环境安装、模型评估到带奖励信号训练的完整闭环过程。整个流程不仅有助于研发实践,也给社区成员搭建了极佳的学习样板。设备资源方面,训练和推理可在分开GPU上并行执行,提升效率并降低硬件需求门槛。社区还提供经济实惠的GPU租赁选项,促使更多开发者能够参与探索。

更重要的是,开放环境和公平评测机制确保开源模型在AI生态中不被闭源大厂模型边缘化。未来,随着该生态完善,语言模型的训练和评估将更公开透明,促进技术普惠和创新。总结来看,开源环境枢纽的建设不仅满足了语言模型日益增长的训练复杂度需求,也推动了RL方法在自然语言领域的落地应用。借助统一、高效的环境和工具组合,模型开发者能更快速验证假设、优化模型性能、实现多轮交流和复杂推理能力。对行业和学术界而言,这代表了向开放、互联和可持续AI研发迈出的重要一步。投资此生态、参与社区并深入理解强化学习环境定义,将是拥抱未来智能技术的不二之选。

。