近年来,大型语言模型(Large Language Models,简称LLM)因其强大的语言生成能力和广泛的应用场景,迅速成为人工智能领域的焦点。无论是智能问答、文本总结,还是对话生成,LLM展现出了前所未有的语言理解与表达能力,极大地推动了自然语言处理(NLP)的发展。然而,伴随着对这种技术的热情,业界也出现了一种“LLM极端主义”的声音,主张几乎所有的语言处理任务都应直接交给大型模型来完成。本文将围绕反对这一极端主义观点展开,深入分析其弊端,并提出更加稳健、高效的实践路径。语言是人类交流的基础,同时也是商业和科技活动的重要构成部分。从网站内容发布到用户之间的信息交流,再到基于文本或语音的交易,语言技术的应用场景无处不在。

多年来,企业一直致力于解决各种NLP问题,力图让计算机能够更智能地理解和处理文本信息。即便在LLM出现之前,各类专门化工具和算法早已应用于文本分类、实体识别、情感分析等任务。然而,LLM的兴起虽然带来了灵活且多样化的生成能力,却未必成为传统任务的直接完美解决方案。LLM极端主义者倾向于依赖大型模型一次性完成整个任务:从文本预处理、信息抽取、语义理解到结果生成,所有步骤均由LLM直接处理。在理论上,这种方法似乎减少了系统复杂性,且方便快速试验新想法。用户只需要设计适当的提示,就能让模型输出所需格式的答案。

然而,现实使用中存在两大主要问题阻碍了其广泛推广。首先是效率瓶颈。LLM计算量庞大,需要消耗大量硬件资源与时间。面对需要实时或大规模处理的应用场景,比如社交媒体监控或在线舆情分析,单纯依赖调用LLM势必导致延迟过高,成本失控。此外,即使使用云端API,频繁请求LLM仍然价格昂贵,不利于商业长期运维。其次,是系统的非模块化设计造成维护困难。

将全部任务全权交给LLM,相当于软硬件架构中单点依赖。稍有需求变更或业务拓展,就必须重新设计提示语甚至调整整条处理流水线。更糟的是,不同任务调用的提示可能无法保持输出一致性,导致结果难以追踪和关联。举例来说,假设企业想构建一个在线声誉管理系统,通过从社交平台收集大量评论,识别公司及竞争对手的提及,同时总结主要舆情主题。在LLM极端主义方法中,系统可能直接向模型一次性输入所有评论,并请求生成总结报告。然而这极其昂贵且延迟长,用户体验不佳;如果需要同时展示原始提及句子和总结,必须设计额外提示,导致输出不一致且难以关联。

反观更为务实的开发思路,是遵循软件工程的模块化设计原则,将复杂任务拆分成若干独立的组件。数据预处理、实体检测、情感分析、主题聚类等,每一步都可采用最适合的技术手段完成。对某些明确、结构化的子任务,传统规则或有监督学习模型往往更加高效、准确和稳定。LLM应被视为整个系统中的一个辅助模块,主要负责那些无法轻易通过固定规则解决的开放性生成任务或对文本的自由总结。这样的架构便于维护升级,能够灵活替换或独立优化各个环节,提升系统的健壮性与适应性。利用LLM进行快速原型设计是其一项巨大优势。

开发团队可以借助模型的生成能力迅速验证概念,评估方案可行度,节省数据标注与模型训练的前期投入。一旦方案确定,再通过收集标注数据训练轻量级专用模型,实现任务的规模部署和持续优化。在改进过程中,科学的评估体系至关重要。除了整体系统的功能评估,还需针对各个模块进行“单元测试”式的内部验证,以保证模块独立性能持续提升,避免因局部改动导致整体性能下滑。注释数据的数量也需充足,避免因样本不足而导致的指标波动产生误导。比起纷繁复杂的端到端训练,适度的数据监督训练在精度和稳定性方面具有明显优势。

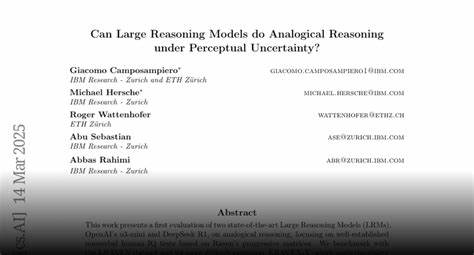

尤其是对于需要高度准确和一致输出的任务,如命名实体识别、文本分类等,经过训练的专用模型可以轻松超越直接的LLM上下文学习表现。LLM极端主义者忽视了这一点,倾向于以牺牲效率和维护性为代价,追求一站式完美解决方案,实际却往往事倍功半。迈向LLM实际主义,即是一种更符合行业规律和技术现状的思路。建议将整体应用任务拆分为预测和生成子任务,清晰定义各步骤目标和接口,最大限度利用传统NLP工具解决规则明确的问题,仅在不可替代的生成环节调用大型语言模型。同时,在设计系统时务必关注可测量的关键性能指标,根据业务目标权衡精度、速度与成本。如需要,可以混合使用多种算法与技术方案,持续快速迭代。

事实上,市场上已有成熟的工具链支持这一策略。例如,spaCy作为知名开源NLP库,具备丰富的文本处理能力,支持模块化流水线构建。此外,一些商业标注工具如Prodigy实现了模型辅助的数据标注,提升训练集质量与标注效率。最近推出的spacy-llm组件还允许开发者将LLM作为管线中某个生成环节,灵活集成大型模型的优势。综上所述,LLM固然为自然语言处理带来了革命性变化,但盲目推崇“全能”极端方案既不现实,也难以长期维持。以模块化设计为基础,合理利用各种技术的优势,借助LLM进行快速原型以及辅助生成,结合有监督学习和规则系统,才是确保高效、准确和可持续发展的正确路径。

未来,随着模型技术的进步与硬件升级,这种务实策略将持续带来更多深远价值,推动自然语言技术服务于更多行业应用,真正实现人工智能赋能时代的美好愿景。