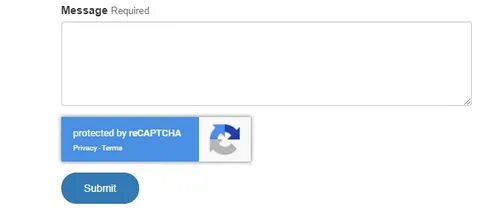

在近年的技术进步中,人工智能(AI)已经展现了惊人的潜力,尤其是在图像识别和模式识别领域。最近,瑞士联邦理工学院的研究人员通过使用名为“YOLO”(You Only Look Once)的深度学习模型,成功破解了Google的reCAPTCHA V2图像验证测试。此项研究不仅引发了科技界的广泛关注,也为网络安全带来了深刻的反思。 reCAPTCHA被广泛用作防止自动化程序(即“机器人”)和垃圾邮件攻击的第一道防线。通过要求用户识别图像中的特定对象,例如交通灯、车辆或其他日常物品,reCAPTCHA旨在确认用户是人类而非机器。然而,随着AI技术的快速发展,这一防护机制正面临威胁。

研究人员的实验表明,YOLO模型可以在经过专门训练后以100%的准确率完成这些测试,这一结果让人深感震惊。 在这项研究中,科学家们最初用来自reCAPTCHA的图像数据训练YOLO模型。起初,模型的准确率仅为70%,这并未满足研究人员的期望。但经过不断调整和优化,模型最终成功破解了所有测试。研究人员指出,虽然YOLO在数量上可以通过这些测试,但并不意味着它在理解上与人类相同。它的表现更多是通过计算和模式识别达到的“人类般”的效果。

研究结论中提到,人工智能在解决reCAPTCHA测试的能力显著增强,且与人类在解决挑战的成功率上没有显著差异。这样的发现无疑是对传统安全措施的挑战,特别是在网络安全日益重要的今天。相较于传统的CAPTCHA,现代的reCAPTCHA并没有显著提高难度,这使得那些利用AI进行破解的行为变得更加普遍。 耶鲁大学的计算机科学家指出,破解CAPTCHA测试的技术问题,不仅关乎科技的进步,更涉及到网络安全的基础。网站和服务平台都仰赖此类验证工具来保护自身不受恶意攻击与自动化程序的侵扰。然而,随着AI技术的不断迭代,这些保护措施的有效性正面临严峻考验。

更令人担忧的是,目前的CAPTCHA设计在面对AI模型时的脆弱性,可能会迫使开发人员面对如何提高安全性的挑战。有学者认为,增加CAPTCHA对人类用户的难度,例如设计更复杂的图形识别任务,可能是一个解决方案。然而,这一措施可能会带来新的问题,如进一步限制残障人士的访问能力,特别是对于视觉障碍者而言,更加复杂的测试可能导致他们无法顺利完成验证,进而影响他们的网络使用体验。 在国内外,许多科技公司和研究机构正在积极探索如何在保持系统安全的同时,改进用户体验。针对reCAPTCHA的挑战,使得破坏性行为变得越来越容易,迫使这些机构重新审视当前的验证机制。例如,一些公司开始试图用行为生物识别技术替代传统的图像识别方法,通过分析用户的输入习惯、滑动轨迹等来判断其是否为人类用户。

这种新的验证方式,可能会减少AI破解的可能性,从而提高安全性。 从更广泛的角度来看,这一事件不仅仅是技术上的突破,它也反映了社会对人工智能技术的依赖和审慎的双重态度。在享受科技带来的便利时,公众在享受高效、便捷服务的同时,也对潜在的风险有了更深层次的思考。如何在推进创新与保护个人隐私、网络安全之间找到平衡,将成为各国科学家和技术开发者必须面对的重大课题。 综上所述,YOLO模型成功破解reCAPTCHA的研究提醒我们,随着人工智能技术的不断进步,原本坚不可摧的网络安全防线可能会被逐步侵蚀。虽然AI在各领域的应用正逐渐深入人类生活,但与此同时,如何构建更加安全与可信赖的网络环境,依然是所有研究者和开发者需要共同努力的方向。

未来的网络安全将不仅仅依赖于一种技术或防护措施,而是需要不断创新和发展多层次的解决方案。只有这样,才能在科技快速发展的背景下,确保用户的信息安全与使用体验。 如今,我们正处在一个技术飞速发展的时代,而这项研究无疑会引发更多关于AI、网络安全以及人机互动的深入讨论。在未来,我们期待看到更多基于科技进步所带来的积极变化,同时也希望社会各界能够共同努力,推动技术的健康发展,为每位用户创造一个安全、可靠的网络环境。