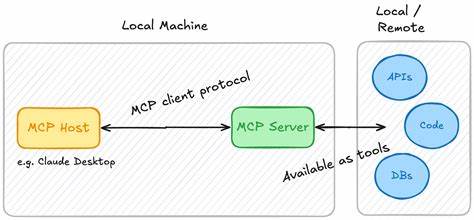

近年来,随着计算技术的不断进步和各种互联网服务的迅猛发展,服务器端技术受到越来越多关注。尤其是所谓的MCP服务器引起了部分技术社区的热议。MCP究竟是什么?为什么在某些圈子中成为讨论热点?更重要的是,为什么很多技术爱好者和专业开发者选择不创建MCP服务器?这其中牵涉到技术复杂性、市场需求、维护成本以及生态环境等诸多因素,我们将在本文中全面解析。 首先,我们必须厘清MCP的具体含义。MCP在不同语境下的定义有所不同,但最近网络讨论中提及的大多是与大型语言模型(LLM)相关的「模型控制协议」或「多计算平台」服务器的缩写。大多数技术社区提到MCP时,是指服务于多种机器学习模型或提供统一接口管理多个AI模型的服务器架构。

这类服务器承担模型调用、数据传输、资源调度等核心任务,强调高效、稳定的运行环境。由此可以看出,MCP服务器不仅需要深厚的技术积累,还必须处理复杂系统的协同运行问题。 纵观当前生态环境,创建MCP服务器面临的首要挑战便是技术门槛高。构建一套高性能、低延迟且扩展性良好的模型管理系统,需要熟悉分布式系统设计、网络协议、并发处理和安全机制。并且,MCP服务器常常需要兼容多种不同AI模型框架,比如TensorFlow、PyTorch等,每种框架的API和资源消耗特点截然不同,如何统一调度和高效利用硬件资源成为技术难点。此外,随着模型规模和复杂度的不断提高,服务器的计算和存储需求急剧增加,普通开发者很难独自承担如此高昂的资源投入。

除了技术难题之外,市场需求不足也是限制创建MCP服务器的关键因素。相比于传统应用服务,MCP服务器仍处于发展前期,相关的实际使用场景和客户需求尚不明确。很多企业和开发者选择直接使用云服务商提供的API接口,如OpenAI、Google AI等,而非自己搭建和维护复杂的模型管理服务器。从经济效益角度看,建设和运营MCP服务器存在高投入、回报不确定的风险,难以吸引资金和人力资源投入。这种现状导致社区及商业环境中鲜有MCP服务器项目获得持续关注和支持。 再者,维护和运营成本也是让项目搁浅的一道难关。

MCP服务器不仅需要强大的硬件支持,还要保证系统的高可用性和安全性。网络攻击、数据泄露、系统崩溃等风险对服务器管理者构成极大压力。随着模型不断迭代更新,MCP服务器也必须频繁升级以兼容最新技术,增加了长期维护的复杂度和人力负担。对于中小型团队而言,这种持续性的压力往往超出承受范围,导致许多项目没能走向成熟。 然而,了解到这些阻碍,我们也能看到MCP服务器技术的巨大潜力。在人工智能和大数据领域,统一模型管理和调度将极大提升工作效率和资源利用率。

未来若能解决技术壁垒,提供更易用、更高效的开发框架,配合合理的商业模式,MCP服务器有望成为连接多元AI系统的重要枢纽。对于大型企业和AI实验室来说,自建MCP服务器则是确保模型安全和定制化服务的必然选择。 社区层面,积累经验和生态建设是推动MCP服务器发展的关键。当前参与讨论和开发的人群多为少数技术极客,缺少成熟的开源项目和详细文档,造成入门难度高和项目断层。通过推动开源合作,建立标准协议,分享案例和工具,可以降低门槛,吸引更多开发者投入这一领域。此外,增强与云厂商合作,探索混合云部署方案,也能缓解资源和运维压力,推动MCP服务器技术的普及。

综上所述,MCP服务器虽有广阔的应用前景,但当前受限于复杂技术需求、资金和人力投入高、生态支持不足等多重挑战,使得许多开发者选择观望或者直接放弃自建方案。面对未来,随着人工智能技术的深入发展和各方资源的聚集,MCP服务器的价值将日益凸显,成为人工智能基础设施的重要组成部分。要实现这一目标,技术创新、产业支持和社区协作缺一不可。只有共同努力,才能推动MCP服务器走出理论和实验阶段,真正服务于产业和社会的多样化需求。