神经网络作为深度学习的核心技术,近年来在人工智能的发展中发挥了极其关键的作用。尽管已取得诸多突破性成果,但深度学习仍处于一个相对年轻且充满未知的阶段。人工神经网络的理论基础从几十年前就开始逐步建立,但现代深度学习与早期研究之间的联系有时显得松散且不够严密。正如其他科学领域在发展过程中经历的漫长蜕变,神经网络领域或许也正处于初期的“临时拼凑”阶段,等待更为系统和统一的理论体系诞生。回顾历史,我们可以看到植物分类学随着进化论和分子生物学的发展得到了根本改变,化学也因原子模型的引入实现了质的飞跃。类似的历史经验让我们有理由相信,深度学习未来的理解很可能与当前截然不同。

目前,对于神经网络及其本质,科学界存在多重竞逐的解释框架。一种是神经科学视角,强调将人工神经网络与生物神经元系统进行类比;另一种是表征学习视角,关注神经网络如何通过多层映射将数据转化为更加便于解决任务的表示形式,这背后隐含着所谓“流形假设”;第三种则是概率论视角,将神经网络解读为在潜变量空间中寻找合适分布的工具。这几种叙事并非互相排斥,而是提供了不同的思路和理论工具来审视同一事物。 在这些视角的基础上,新的观点将神经网络与函数式编程中的类型理论做了巧妙的联系。函数式编程中,类型是一种强有力的抽象手段,它用来约束函数输入输出的形式,使得代码更加严谨且易于组合。而在深度学习中,层与层之间的输入输出可以看成具有某种“类型”的数据表示,只有“类型匹配”的输出可以作为下一层的输入,从而保证了整个网络的连贯性和正确性。

从这个角度来看,神经网络的结构不仅仅是简单的计算流程,更是一种精妙的类型体系,网络中的每一层负责将数据“塑形”为适合任务需求的表示。 这种“表征即类型”的观点,帮助我们理解为什么深度神经网络能够高效地处理复杂任务。数据在网络内部经历了多次非线性变换,每一次变换都可以被视为一种类型的转换,嵌入到更高维、更具辨识性的空间中。与编程语言中类型检查的严格约束类似,网络层之间的“表示兼容性”保证了信息能被有效传递和利用。尤其是在多输入多输出的复杂模型中,这种类型匹配变得更加重要。例如,一个网络同时接受RGB彩色图像和灰度图像,执行同时预测年龄和性别等多任务操作,这就需要对不同源的数据建立统一且协调的中间表示。

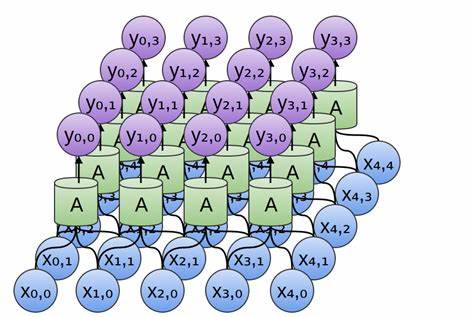

除此之外,函数式编程的核心概念也在神经网络设计中得到了体现。函数式编程强调代码复用与抽象,例如使用高阶函数来接受其他函数作为参数,提高程序模块的通用性和灵活性。深度学习中“权重共享”的思想与之异曲同工,这种技术即“weight tying”,允许模型通过重复利用神经元参数来减少冗余,提升学习效率和泛化能力。典型的应用包括循环神经网络(RNN)和卷积神经网络(CNN),它们分别对应着函数式编程中的fold和map等范式。前者用于处理序列数据,将一个可变长度的输入折叠成固定形态;后者则像映射函数一般,对输入的局部邻域进行操作,从而捕捉空间信息。 更深入观察,神经网络中的不同结构可以用函数式编程中的不同类型的递归模式来描述。

比如编码型循环神经网络可被视作fold操作,按照顺序聚合输入信息;生成型循环神经网络则类似unfold操作,从一个种子状态展开生成序列;双向递归神经网络等更复杂结构对应的是左右累积映射的组合,捕捉序列的双向上下文信息。树形递归神经网络(TreeNet)则可与catamorphism对应,表示对树形数据结构的递归折叠处理,在自然语言处理领域表现出非凡实力。 卷积神经网络则相应于“窗口映射”,不是单纯地处理每一个元素,而是同时考虑其邻近元素,从而能够更好提取局部特征。二维卷积尤其在计算机视觉领域取得了重大成功,通过滑动窗口技术,CNN能够自动捕捉图像的空间结构和语义信息。 基于上述观察,深度学习模型的设计实际上可以看作是在编写一种新的“可微函数式程序”。这些程序的不同部分由可学习的神经网络模块构成,整体的结构由函数式编程的组合模式决定。

通过这种方式,程序员能够构建复杂的函数组合,同时利用优化算法对可学习参数进行训练。这种“可微的函数式编程”不仅为设计复杂模型提供了一种清晰的语言,也促进了多任务、多模态学习,拓展了神经网络的表达能力。 基于函数式视角的理解,许多经典深度学习成果如神经机器翻译和图像标注等任务都可以重新解读。例如,Sutskever等人提出的神经机器翻译模型,结合了编码型RNN和生成型RNN,宛如先对输入句子进行fold操作编码,随后通过unfold生成目标语言句子。Vinyals等人在图像标注任务中,首先用卷积网络提取图像特征,再以生成型RNN“展开”句子描述,这种逐步扩展的过程正体现了函数式编程的思想。 整体来看,神经网络、类型理论和函数式编程的结合为深度学习的未来奠定了理论基础和新思路。

尽管目前这一观点仍处于高度推测阶段,缺乏充分的实证支持,但其自然优雅的逻辑体系令人信服。这种交叉学科的思考不仅或许会推动深度学习范式的转变,还可能带来更具解释力和鲁棒性的模型设计方法。 未来三十年,当我们回头审视今日的深度学习,也许会发现当下的种种实践不过是粗糙的探索和过渡,而真正成熟的理论体系将融汇神经科学、概率模型与函数式编程的精髓,实现对智能系统更加深刻和本质的理解。特别是在类型理论、拓扑学和同伦论等数学领域的加持下,深度学习的表征学习有望实现更加严密和统一的抽象。 总而言之,将神经网络和函数式编程的类型体系结合起来,不仅为我们提供了一种审视深度学习的新视角,更揭示了优化、函数组合与抽象类型三者之间的内在联系。这一观点激励研究者从更广阔的数学和计算机科学维度探索人工智能的新边界,也呼唤多学科的合作和深入对话,期待未来的研究能将这一设想转化为实际的突破与创新。

。