在现代机器学习领域,梯度下降方法因其简单高效而被广泛应用于神经网络训练。然而,随着研究的不断深入,人们逐渐发现某些函数类别,比如奇偶函数(parity function),在梯度下降的学习过程中面临着根本性困难。理解这种困难的根源不仅有助于我们认识深度学习的局限性,也为设计更高效的学习算法提供了理论指引。本文将围绕梯度下降在奇偶函数学习中的难题进行系统分析,解读相关数学理论与实验成果,试图为读者呈现一个清晰的认知框架。奇偶函数的定义与复杂性分析奇偶函数是指对输入的一组比特取子集,然后判断该子集中“1”的数量是奇数还是偶数。形式上,给定一个向量v和输入x,奇偶函数通过内积运算决定输出为+1还是-1。

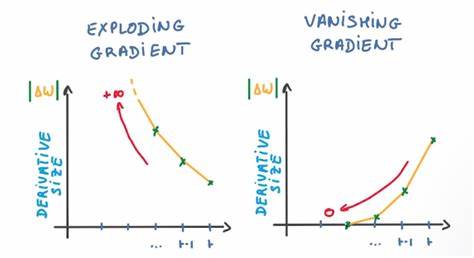

这类函数在理论计算机科学中非常经典,经常用于考察学习算法的表达能力与局限性。从信息论角度来看,学习一个未知的奇偶函数需要对所有可能的比特子集进行区分。由于子集的组合数呈指数增长,理论上至少需要指数量级的样本才能保证识别准确。这带来了最基本的样本复杂性瓶颈。梯度下降的极限与困难研究由Omar Shamir等学者领导的一系列工作揭示,梯度下降在学习属于奇偶函数家族的函数时存在指数时间复杂度障碍。其核心思想是,即使对输入数据分布进行了严格限制,梯度信息本身对函数目标的区分度也极其有限。

通过严谨的数学推导证明,梯度的方差随着输入长度呈指数级下降。这意味着在参数空间中,梯度指示的搜索方向难以提供有效的目标函数信息,迫使梯度下降陷入无意义的停滞或缓慢收敛。更具体地说,许多梯度估计结果在噪声和数值精度误差的影响下,无法形成良好的学习信号。即使算法尝试使用近似梯度信息,也存在对手式的梯度估计方法能够诱导网络学习无关目标,延缓实际有效学习难以避免。这一发现揭示了奇偶函数学习的根本难题,体现了深度学习方法在某些逻辑任务上的内在局限。奇偶函数在实际算法中的表现及突破实际应用中,研究人员尝试利用连续可微的逻辑求解器,譬如SATNet,将传统SAT求解问题转换为可微分的优化问题,从而利用梯度下降算法进行训练。

Wang等人设计的可微分可满足性问题求解器,通过不断调整CNF公式参数,使得该求解器输出的变量赋值最大化满足子句数。他们以奇偶函数为训练目标,尝试学习能够判定输入中“真”的数量奇偶性的逻辑表达式。这一工程实践在一定程度上展示了在受限模型结构与输入约束下,通过施加归纳偏置(inductive bias),梯度下降仍能有效地捕获奇偶函数的特征。虽然理论结果提示一般无偏学习难度极大,但结构化模型与输入先验结合仍有可能实现实用的学习效果。理论与实践的平衡关系值得关注。数学基础与关键定理梯度下降难题的数学分析包括对期望梯度及其方差的严格计算。

研究表明,在奇偶函数族中,期望梯度的方差呈指数级缩小,限制了有效的梯度信号。通过Chebyshev不等式等概率手段,证明了存在近似梯度方法在一定迭代步数内无法捕获函数差异,导致学习信息匮乏。此外,多项式函数空间的正交性质和巴塞尔不等式为方差计算提供支持。该理论框架为深度学习中某些问题的不可解性构建了精确数学依据。更广泛的影响与相关难题梯度下降方法学习离散对数(discrete logarithm)等复杂函数同样存在不可克服的困难,这与奇偶函数难度表现出异曲同工之妙。Takhanov及其团队的相关工作进一步确认了梯度下降在这类计算复杂度任务上的局限。

通过对梯度方差与学习动态的综合研究,社区逐渐认识到传统深度学习框架在处理某些离散逻辑函数时的瓶颈问题。未来研究方向可能集中于引入更强的归纳偏置、更复杂的网络结构,或者融合符号逻辑方法,以弥补梯度基优化在这类任务上的不足。展望未来科学家们正试图构造兼具可训练性和表达力的模型,在理论证明的同时兼顾实用性。这可能包括融合神经网络和微分逻辑求解器的混合架构,或创新优化算法以提升梯度信号的区分能力。理论与实验的深度结合,将是破解梯度下降难题关键所在。总结梯度下降学习奇偶函数的困难深刻体现了神经网络训练中的基础限制。

尽管理论证明了存在指数收敛时间及信息匮乏,实践中适当的模型设计和归纳信息仍有助于突破桎梏。理解这一难题有助于从数学和算法层面推动深度学习前沿,促进更具智能化和逻辑推理能力的系统研发。未来持续的跨学科探索将加速这一领域的技术革新和理论升华。