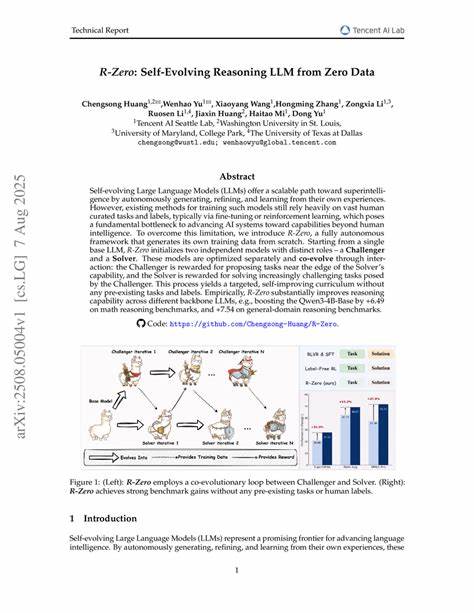

随着人工智能技术的飞速发展,尤其是在大型语言模型(LLM)领域,训练模型所需的庞大数据集和高昂的人工标注成本成为制约创新突破的瓶颈。传统方法依赖于大量人工设计的任务、精细的标签以及复杂的微调和强化学习技术,不仅耗时费力,更限制了模型能力的持续提升和自主优化的潜力。近日,来自机器学习领域的前沿研究成果 - - R-Zero模型带来了全新的突破,开创了从零数据自我进化的推理大型语言模型新时代。R-Zero通过创新性的架构设计和训练机制,实现了无需任何预设任务和人工数据的自我训练与互助进化,大幅提升了模型在数学推理、通用推理等多样化场景下的表现。R-Zero的核心理念是基于单一基础大型语言模型,衍生出两个不同职责的子模型 - - 挑战者(Challenger)与解答者(Solver),二者在互动中不断激发彼此能力边界,形成一个有针对性且动态演进的学习课程。挑战者负责创建针对解答者能力极限的谜题与任务,通过不断推高难度逼迫解答者提升能力;解答者投入更多资源攻克这些挑战,逐步实现更强的推理能力和智能表现。

整个过程不依赖任何人类预先设计的任务或标签,而是利用模型自身产生的数据实现闭环式自主学习。这种机制不仅解决了训练初期因缺少高质量数据导致模型性能受限的痛点,更为未来实现超越人类智能的自我进化系统铺设了基础。实验证明,R-Zero在多种大型语言模型基础上均表现优异。例如,在Qwen3-4B-Base模型上,R-Zero分别在数学推理和通用推理基准测试中实现了显著提升,数学能力提升幅度达6.49分,通用推理能力提升则达到7.54分。这表明R-Zero架构具备强大的通用性和适配性,可以有效提升不同规模和结构基础模型的推理能力。R-Zero的优势不仅体现在性能提升,更重要的是它展现了人工智能模型如何实现真正的自主进化能力。

传统的训练方法依赖大量人类介入,数据标注和任务设计不仅耗费人力资源,也限制了模型的创新和能力边界。相比之下,R-Zero利用自身生成的数据进行训练,避免了人为偏差,同时还能持续挖掘模型能力的潜力,真正做到"自我驱动"式成长。另外,R-Zero提出的挑战者-解答者分工合作机制,为多智能体协同学习提供了全新视角。两个模型在竞争与合作的博弈环境中不断推动彼此极限,这种动态交互类似于人类社会中智力挑战与学习的过程,更符合自然智能的演进路径。展望未来,R-Zero有望成为实现超级智能的重要基石。通过构建无监督、无人工标注、能自我生成训练任务及数据的生态,LLM可以突破当前人工智能僵局,实现持续进化和自我完善。

该技术不仅能够推动机器推理、自然语言理解、自动编程等多领域应用迅速发展,还可能引发智能系统自主学习、自适应和创新能力的质变。此外,R-Zero对降低人工智能训练的环境成本和经济负担同样意义重大。大规模标注数据的需求通常伴随着高昂的计算消耗和资源浪费,而R-Zero通过自主生成训练任务,有效削减了数据准备环节的能耗,并提升训练效率。这不仅顺应了绿色AI的发展趋势,也促进了AI技术向普惠化方向迈进。需要指出的是,R-Zero的成功离不开底层大型语言模型性能的提升,以及高效的训练算法支持。随着基础模型规模与结构不断优化,未来R-Zero框架能够容纳更复杂的任务设计与多样化的自我演进策略。

结合强化学习、元学习等前沿技术,将极大激发模型潜力,使其适应更为复杂多变的现实世界需求。总结而言,R-Zero为大型语言模型带来了全新的训练范式,通过零数据自我进化设计,解决了传统依赖海量标注数据的局限。它不仅显著提升了模型的推理能力,还构建了类似自然智慧进化的学习机制,开辟了通向超级智能的实践路径。随着相关技术的深入研究和应用推广,R-Zero有望推动人工智能从辅助工具向真正具有自主学习和自我超越能力的智能体转变,引领智能时代的革新浪潮。人类社会对更智能、更高效、更自主的AI系统需求日益增长,R-Zero的出现恰逢其时,为人工智能的未来发展注入了强劲动力。未来我们有理由期待,借助自我演进的R-Zero框架,机器智能将实现质的飞跃,助力科研、教育、医疗、金融等多个领域焕发新活力,推动社会迈入更加智能化的新时代。

。