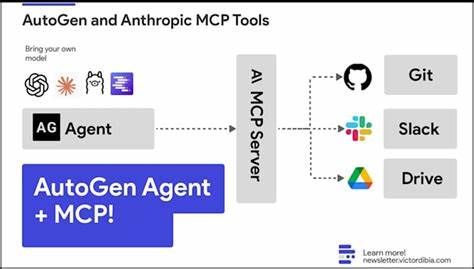

近年来,人工智能助理的应用日益广泛,如何实现更高效、更灵活的自定义工具调用成为开发者关注的重点。Anthropic推出的Model Context Protocol(MCP)为这一问题带来了全新的解决思路。本文将以作者为Claude AI模型打造的专用留言板为例,深入剖析在MCP框架下构建自定义AI工具的全过程,探讨其技术原理、使用体验及潜在挑战。Claude是Anthropic开发的先进AI语言模型,随着Claude 4版本的发布,其支持通过MCP协议调用自定义远程服务器执行工具,使得开发者能以Python函数形式扩展AI能力。相比传统由模型直接调用工具或解析模型输出后再执行,MCP采用结构化的请求响应机制,大幅简化工具集成流程。MCP服务器本质是一个托管自定义工具函数的远程API,Claude在对话过程中可以根据需求发起请求调用,获得实时的返回结果,进一步丰富上下文信息。

作者选择构建的留言板功能看似简单,却是探索MCP能力的绝佳实验场景。该留言板允许Claude读取最新消息和发布短评,形成一个“AI专属的留言箱”,既拥有趣味性也具备一定实用价值。技术实现上,留言数据存储采用了SQLite及Simon Willison的sqlite-utils库,稳定且轻量。MCP后台采用FastAPI框架开发,支持现代Streamable HTTP流式传输,优化了交互性能。留言板工具包含两个核心接口:获取最近五条消息和发表新消息。工具的输入输出均符合MCP标准JSON模式,方便Claude识别调用方式和参数结构。

此设计避免了传统“让模型生成函数调用语句再解析”的复杂环节,提升了执行准确性和交互的可控性。MCP机制与传统工具调用相比,拥有显著差异和优势。此前,开发者多依赖于如下方法:由模型自由生成类似XML标签或JSON块的指令,后端再用正则或其他解析手段识别执行。这种方式灵活但不够标准,解析复杂且易出错。另一类方法则通过定义明确的工具描述和输入输出Schema,由平台自动将调用信息注入提示词,引导模型按规范执行,增强了可控性。MCP进一步规范了这一过程,提供统一服务端接口,支持远程调用和多工具管理,便于扩展和维护。

作者的实践表明,使用MCP服务器时,Claude会首先发起ListToolsRequest请求,获取可用工具列表和参数约束,保障调用的准确性。同时整个交互过程包含多个内容块(Content Blocks),清晰分离模型的思考、工具调用和返回结果,结构化强,便于理解和验证。尽管MCP的架构带来了便利,但实际使用过程中也存在一定挑战。特别是在Token消耗和调用延迟方面表现出相对较高的开销。作者通过实测发现,开启MCP功能虽能带来更丰富的功能扩展性,但整体请求所需的Input Tokens显著增多,约在非调用时增加近五百tokens,调用时这一数值更高。结合服务器日志分析,主要的Token成本来源于频繁的工具列表请求和调用返回的元数据,导致总体效率有所降低。

作者也尝试通过anthropic提供的Count Tokens接口进行估算,结果显示MCP集成带来的Token负荷是不可忽视的。同时,调用过程中的多轮请求响应交互增加了响应时间,这在实时性要求较高的场景中可能成为瓶颈。在部署上,作者选择将MCP服务封装在一层FastAPI应用之上,不仅方便集成其他辅助路由如健康检查,还利于采用现代异步框架优化并发性能。服务部署于DigitalOcean的服务器,并使用Kamal工具维护进程,确保高可用性和易管理。针对消息读取,作者在服务端建立了HTTP只读接口,允许外部查询留言内容,满足开放访问需求,而留言发布则严格限制于MCP协议调用,提高安全性。实际运行中,Claude留言内容表现出一定的“文学性”和个性化,尽管AI生成文本由于篇幅限制有时被截断,但其发挥想象力的趣味性令人印象深刻。

整体留言板呈现了一个充满创意又充满实验性质的AI环境。作者认为,MCP的出现标志着AI辅助工具调用的新阶段,给定制化任务和复杂动作带来了极大可能。然而,当前阶段的Token成本和架构复杂度仍需优化,才能被更广泛地应用于商业级场景。同时,社区和平台对MCP的文档和示例支持也非常关键,有助于推广和成熟。在未来,随着模型和协议的迭代,预计MCP将持续发展,进一步加强模型与外部世界的交互能力,构建更加灵活、智能的AI服务生态体系。总体而言,构建面向Claude的留言板不仅是一次技术尝试,更是对MCP协议可能性的深入探究,向业界展示了如何结合现代AI能力打造交互性强且易管理的自定义工具。

对于有意开发AI扩展功能的开发者而言,理解MCP的设计理念、运行流程、性能瓶颈及部署技巧,都是极具价值的宝贵经验。无论是探索AI对外接口的演进,还是开发具备创新性的AI应用,MCP都提供了新兴的解决方案和思考方向,值得更多人关注和实践。