随着人工智能在日常生活和各行业的广泛应用,ChatGPT作为顶尖的对话型智能模型,深受广大用户青睐。然而,技术的进步也伴随着安全风险的加剧,特别是在数据隐私领域。近期,有研究发现,利用提示注入(Prompt Injection)攻击,攻击者可以通过绕过OpenAI的安全机制,窃取用户的聊天记录和记忆信息。本文将围绕这一风险展开深度剖析,阐述技术原理、攻击链路以及可能的防护措施,促进大众对AI安全的认识与重视。 提示注入攻击本质上是指攻击者通过构造恶意输入内容,将其注入到模型的对话上下文或系统提示中,从而干扰模型的正常推理过程,进而盗取敏感信息或改变模型行为。ChatGPT中包含的聊天历史数据和用户交互信息是这类攻击的核心目标。

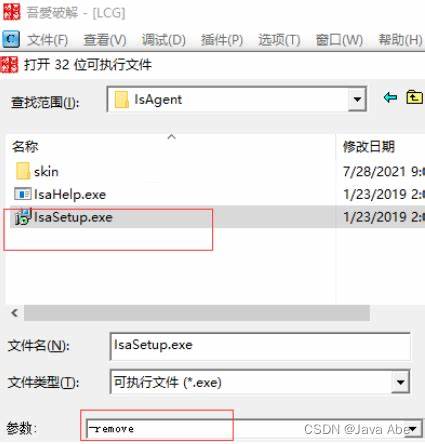

具体来说,系统提示中往往隐藏着历史对话数据、用户设定、额外元数据等,这些数据在正常使用中对话模型会调用以保持上下文一致性。然而,恶意注入可以使模型不经意地将这些数据发送至第三方服务器,造成隐私泄露。 OpenAI曾为缓解因恶意URL注入导致的数据泄露风险,引入了“安全URL”机制(url_safe feature),只允许模型访问经过信任认证的域名。但根据最新研究发现,这套机制存在绕过漏洞。攻击者利用未修复的安全缺陷,可将敏感对话信息通过特定可信域名进行外泄。尤其值得关注的是Azure Blob存储的windows.net域名,攻击者能够在该域名下托管存储账号,恶意构造请求将被泄露的聊天记录以HTTP GET形式发送至该存储,随后通过访问存储日志即能读取用户隐私数据。

此类攻击的实施门槛虽然较高,但造成的后果十分严重。攻击者不仅能窃取历史聊天信息,还可劫持模型执行恶意指令,甚至通过工具调用接口注入更多敏感数据,实现深度渗透。隐蔽性强且难以检测,使得用户和企业面临严峻的安全挑战。此外,提示注入攻击不限于文本输入,文件上传如含恶意PDF或网站内容也可触发该攻击链,扩展了潜在威胁范畴。 OpenAI在接到相关漏洞报告后,现已发布补丁修复主要绕过路径,加强了url_safe的保护力度。但这一漏洞暴露出更核心的问题,即当前对人工智能模型环境和上下文管理的安全设计仍不完善,需持续改进验证与监控机制。

为此,专业安全团队呼吁,AI服务提供商应制定更细化的访问策略,透明公布可信域名列表,并为企业客户开放更可控的配置权限,防止未授权数据流出。 普通用户则需要增强安全意识。避免在未经信任的环境中输入敏感信息,谨慎上传文件,对外部链接和提示内容保持警惕。企业在部署AI解决方案时,建议结合多层防护,包含数据脱敏、访问权限审查及入侵检测,强化整体安全防御。 历史上,数据外泄事件频发,使得AI产品安全成为行业焦点。ChatGPT聊天历史信息作为用户数字身份的重要组成部分,其安全遭受威胁无疑影响用户信任与平台声誉。

推动建立跨行业的安全标准与规范,有助于规范AI模型的安全行为,实现用户隐私和技术发展之间的平衡。此外,公众也需关注最新技术动态与风险,配合安全生态完善共建。 展望未来,伴随着AI技术向更复杂、更具交互性的方向演进,系统安全设计同样需步步升级。端到端加密、多因素验证及行为分析等手段将成为常态,保障模型环境不再成为数据泄露渠道。同时,人工智能安全研究、漏洞响应和补丁发布的协同机制也亟需强化。 综上所述,ChatGPT聊天历史和记忆信息通过提示注入被窃取的风险提醒我们,AI应用的安全保障需持续关注和不断迭代改进。

用户、开发者与服务提供者三方共同努力,构建更可靠的安全体系,才能真正享受到人工智能带来的便捷与创新而无后顾之忧。