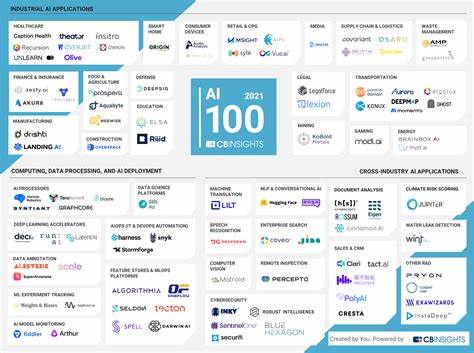

近年来,人工智能领域的发展可谓日新月异,尤其是在大型语言模型(LLM)的训练与应用方面推动了诸多变革。传统上,这些模型的训练需要依赖集中式数据中心,配备大量高性能GPU和高速网络,消耗巨大的计算资源和资金投入。通常,只有少数科技巨头和资金雄厚的机构才能承担如此高昂的硬件和数据成本。然而,一批勇于创新的初创企业正在探索全新的训练模式,打破了传统数据中心垄断,将AI模型的构建带到了一个分布式、去中心化的新境界。花朵AI(Flower AI)和Vana便是其中的典型代表,这两家公司合作推出了名为Collective-1的分布式大型语言模型,规模达到7亿参数,虽相比业界顶级模型稍逊一筹,但其技术理念的革命性意义不可小觑。分布式训练的核心思想是将计算任务拆分,分散到全球数百台连接互联网的计算机中进行。

花朵AI开发的技术允许训练过程在不同地理位置、性能各异的GPU上高效协同,用户无需将数据集中到单一地点,实现了资源的最大化利用。这种方法不仅降低了对高密度计算设备和超高速间联网络的依赖,还使得训练过程更加灵活,可以随时加入新的硬件资源以加快模型迭代速度。Vana作为合作伙伴,创新性地引入了用户私人数据的贡献机制,从平台如X(原Twitter)、Reddit及Telegram采集私密信息。在确保用户隐私和数据授权的前提下,允许用户为模型训练提供独特而稀缺的数据源,极大地拓展了可用训练数据的种类和质量,也给用户带来了对数据使用的控制权和经济激励。这种模式代表了人工智能数据训练的一个重要转向,即从单向的数据采集和利用,转向用户参与和数据权益共建的双赢格局。该趋势有望打破当前AI行业权力高度集中的现状。

目前,绝大多数顶级AI模型都依赖大量公开抓取的数据,诸如网站内容、电子书籍等有时甚至涉及版权争议,而巨额资金和硬件资源限制了更多创新型主体的参与。分布式训练方法令中小型企业、学术机构甚至基础设施较弱的国家也能通过联合资源,共同参与到大规模AI模型的开发中,促进行业多元化和技术民主化。剑桥大学计算机科学家兼花朵AI联合创始人尼克·莱恩(Nic Lane)表示,尽管Collective-1目前规模较小,但其分布式训练架构具备良好的可扩展性,预计今年内将完成一个高达1000亿参数的模型训练,这一数值已接近行业领先水平。与此同时,花朵AI正着手打造融合图像和音频等多模态数据的AI模型,进一步拓宽应用场景和智能表现。技术层面,分布式训练挑战重重,训练速度普遍较传统集中式方式缓慢,但这样换来的却是更大的灵活性和资源高效利用。训练过程中的参数共享与更新机制必须兼顾网络延迟和数据一致性,保证模型最终收敛的质量和效果。

为提升分布式训练效率,研究团队开发了名为Photon的新工具,结合了谷歌提出的DIstributed PAth COmposition(DiPaCo)方法,优化了计算分解和合并的策略。Photon已于今年以开源形式发布,使得更多开发者可以访问和改进这个创新系统。值得关注的是,分布式训练的另外一大优势在于其潜在对数据隐私的尊重和保护。由于数据无需集中存储,敏感信息更难遭受泄露风险,尤其适用于金融、医疗等涉及严格数据保护法规的行业。分布式架构还可以充分利用各机构或个人本地的数据资源,实现数据所有权和使用权的合理分配。AI治理专家海伦·托纳(Helen Toner)指出,尽管分布式模型在前沿技术的追赶速度上可能不及集中式巨头,但其作为一种“快速跟进者”的策略,在AI领域竞争和治理中具有重要地位。

它不仅提供了一条降低壁垒的替代路径,也为构建更公平和多元的AI生态系奠定基础。分布式AI模型训练的兴起,预示着技术和商业模式的双重颠覆,未来或许能形成类似区块链的开放协同网络,汇聚全球计算资源与数据资产。此外,这也激发了对数据贡献者权益的重新思考和定义,使普通用户不再是被动信息来源,而能以主动身份参与AI生态、分享收益。尽管面临网络不稳定、训练同步复杂等技术难题,这条道路已获得业界和学术界的广泛关注与支持。总之,摒弃对庞大数据中心的依赖,转向分布式及用户驱动的数据集合方式,将极大拓宽人工智能的应用边界和创新深度。初创企业凭借灵活的策略和技术先锋精神,正逐步改变人工智能研发的格局,让更多主体具备构建顶尖AI模型的能力,也让AI技术更加贴近广大用户的需求和利益。

未来,随着技术不断成熟和生态系统的完善,分布式训练有望成为推动AI民主化和可持续发展的关键引擎。