在当今科技飞速发展的时代,人工智能逐渐渗透到各行各业,编程领域亦不例外。基于大型语言模型(Large Language Models, LLM)的编程助手,正逐步改变着程序员的日常工作方式和学习体验。它们不仅仅是简单的代码补全工具,而更多地扮演着“个人导师”角色,帮助开发者迅速掌握新的编程语言特性,理解语法和内置函数的用法。本文将深入探讨这类工具的实际应用价值,尤其是面向已有经验的程序员,如何借助LLM助手在多种编程语言中拓展技能边界,以及未来的潜在发展趋势。 最初接触基于大型语言模型的编程助手时,很多程序员可能会觉得它们的效果平平,没有达到预期。早期的GPT-3版本在代码生成上的表现有限,很多时候生成的代码不够准确或实用,令人难以令人信服。

然而随着模型的迭代和不断优化,尤其是像Anthropic推出的Claude 3.5版本及其Sonnet功能的融合,开发者体验得到了显著提升。例如,编辑器Zed与Anthropic的合作带来了集成化的代码对话环境,使程序员能够不离开开发环境就获得多语言方面的即时帮助,极大减少了因查找文档而导致的上下文切换,提升了开发效率。 LLM编程助手的最大优势在于其对程序员学习路径的促进作用。对许多经验丰富的开发者来说,他们清楚自己想要实现的功能和逻辑,但可能对某些编程语言的具体语法、标准库函数或独特特性不熟悉。这时,LLM助手能够快速响应诸如“在语言X中如何实现功能Y”的问题,提供简明易懂的示范代码和解释,仿佛有一位随时待命的导师。这种交互式的学习方式极大地降低了跨语言学习的门槛,加速了掌握新语言的过程。

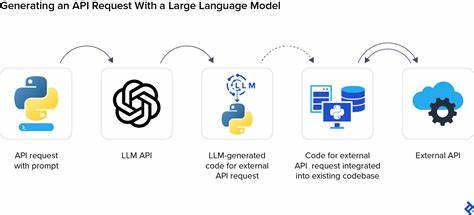

与传统单向查阅文档不同,基于LLM的助手支持双向对话,程序员可以不断调整问题的准确度和细节,通过“问答”加深理解。这为程序员探索复杂或较少接触的语言特性提供了有效途径。尤其是在面对多个编程语言或混合使用新旧技术栈的当下,它成为了扩展技能栈的强大辅助工具。 除了语法和标准库的查询,未来LLM助手在编程领域的应用潜力非常广泛。例如生成不同语言之间的绑定代码,可以让C语言库轻松被其他语言调用,减少跨语言开发的复杂性。此外,开发者还能通过输入协议规范,逐步构建完整的实现代码,加速协议开发和调试过程。

对于一些学术性较强或新兴的实验性编程语言,LLM可辅助从大量学术论文中提取关键信息,帮助设计新的语言核心库或工具,使之更加符合实际需求和开发者的使用习惯。 快速构建应用原型也是LLM编程助手的一大亮点。借助模型的生成能力,程序员可以迅速产出React组件等前端模块,简化快速迭代的工作流程。这种低门槛、高效率的开发体验对于初创团队及产品原型开发尤为重要,能够大幅节省人力时间成本,提高创新速度。 尽管当前市场上围绕AI编程工具的讨论热度极高,随之而来的也有大量质量参差不齐的内容和产品。如何在纷繁复杂的选择中筛选出真正有用、能提升工作效率的工具,成为了程序员面临的挑战。

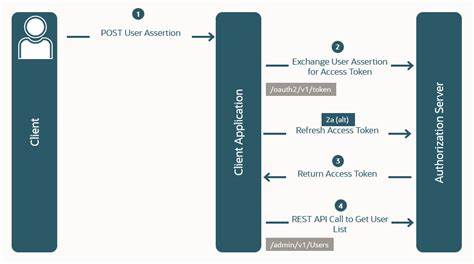

然而透过表层的喧嚣,基于LLM的编程助手已经表现出其不可忽视的实用价值。特别是对于那些愿意花时间打磨与模型交互方式,结合具体项目需求的开发者来说,未来无疑充满了希望。 在技术优化方面,除了直接调用大型模型生成代码,针对模型进行微调并结合缓存技术,如Claude的提示缓存,能有效提升响应速度和上下文准确率。同时,随着模型体积不断扩大和推理能力增强,未来的编程助手将越来越懂得用户意图,生成的代码也将更加符合最佳实践和安全规范,使辅助编程体验更加顺畅和专业。 展望未来,基于LLM的编程助手不仅能帮助个人开发者增强多语言编程能力,也有望推动整个软件生态系统的发展。通过自动生成语言服务器、格式化工具、静态分析器、以及云端协作功能,这些智能助手能够减轻开发负担,促进团队协同,提高代码质量。

与此同时,教育领域的整合也将日益深入,为编程初学者和专业人士提供个性化学习方案,缩短从入门到精通的距离。 总结来说,基于大型语言模型的编程助手正处于不断成长和完善的阶段。它们不再仅仅是代码补全的机械工具,而是逐渐成为程序员的知识伙伴和学习导师。通过减少对文档的频繁依赖,优化开发环境中的交互体验,并实现多语言和多场景的广泛支持,未来编程工作将更加高效和富有创造力。对所有寻求拓展技能边界、提升开发效率的程序员而言,拥抱这类智能助手无疑是一条值得尝试的道路。随着技术的不断进步,相信基于LLM的编程助手将在未来的软件开发领域中发挥越来越核心的作用,助力程序员迎接数字时代的更多挑战和机遇。

。