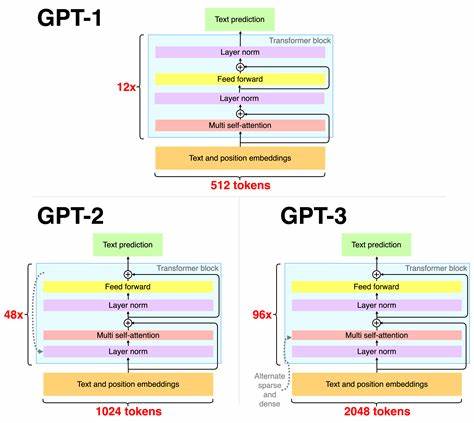

人工智能领域的快速发展推动了大型语言模型(如GPT-2)的广泛应用,然而传统模型庞大的体积和高昂的计算资源消耗限制了其在普通硬件环境下的部署。TickBlock作为一项创新性的技术,通过将GPT-2缩减到原模型的0.5%大小,并结合物理启发的设计理念,成功实现了在普通Mac设备上的高效训练和优异性能表现,令人瞩目。TickBlock项目不仅展现了微型语言模型的新可能,也为资源有限的环境中实现自然语言处理任务提供了实用方案。 GPT-2自发布以来凭借其强大的生成能力成为语言模型研究的里程碑,不过其庞大的参数规模对硬件提出了较高要求。通常情况下,要在高性能服务器甚至云端环境中进行训练和推理,这限制了许多研究者和开发者的使用。TickBlock通过结构创新和物理学启发的算法优化,进行模型结构和参数的极致压缩,从而使模型体积大幅缩小至原先的0.5%。

这一变革使得普通的Mac设备亦能承担训练任务,极大降低了入门门槛和硬件成本。 物理启发在TickBlock中的应用尤为关键。借助物理学中的系统动态和能量守恒等原理,TickBlock设计了一套针对语言模型训练的优化框架。该框架模拟物理系统中粒子或波动的状态迁移过程,强化模型的表示能力与稳定性,提升了训练效率与泛化性能。同时,这种设计使内存和计算资源得到了更合理的利用,减少了冗余计算和参数重复,切实提高了模型在资源受限环境下的实用性。 在训练过程中,TickBlock利用Mac设备的CPU和GPU协同进行模型优化,通过专门开发的轻量级训练库,实现了对模型参数的精准调控和高效迭代。

此外,模型参数的稀疏化处理和动态调整策略也有助于减少计算成本,保持训练的顺畅。与传统的GPT-2训练相比,TickBlock不仅缩短了训练时间,还在保持语言理解与生成能力方面表现出色,证明了微型模型在实用场景中的巨大潜力。 TickBlock为各类语言生成任务提供了诸多应用可能。无论是在文本摘要、机器翻译,还是智能问答等领域,这一微型模型均展现出优异的适应性。其极小的尺寸便于集成进移动设备、边缘计算平台或嵌入式系统,满足对低延迟和实时响应的需求。此外,由于训练和推理对硬件环境要求低,TickBlock为开发者提供了更灵活的模型迭代与部署路径,助力构建具有针对性的定制型人工智能应用。

尽管TickBlock在体积和性能之间取得了平衡,但仍面临诸多挑战。由于模型规模极小,如何保证语言模型的丰富表达和理解力成为持续研究的重点。未来,结合更多物理学方法和先进的优化算法,进一步提升模型的语义捕捉能力和上下文处理效果将极为重要。同时,拓展TickBlock在多模态学习和跨领域自适应上的应用,也是推动这一领域发展的关键方向。 综合来看,TickBlock创新地将物理学原理融入微型GPT-2模型设计,通过极致的参数压缩和高效训练策略,开创了在普通硬件上运行大型语言模型的新时代。这一突破不仅降低了AI技术的门槛,还促进了人工智能技术的普及与多样化应用。

随着更多研究投入和技术积累,未来TickBlock有望在更广阔的领域释放更强大的潜能,推动智慧计算向无处不在的方向发展。 。