生成式人工智能技术如ChatGPT、Gemini、Copilot和Claude逐渐走入企业日常工作流程,极大提升了生产效率,同时也带来了前所未有的数据泄露风险。企业在享受AI带来便利的同时,如何确保敏感信息不被无意泄露成为安全团队面临的重大课题。传统的数据防泄露(DLP)解决方案多依赖端点或局部渠道检测,往往难以捕捉通过人工智能交互产生的数据流转,导致安全盲区。网络可见性因此成为守护企业数据安全的关键环节。网络检测与响应(NDR)技术借助网络层面全流量监控和智能分析,为包含加密流量在内的复杂环境提供了更为全面深入的视野。通过对穿越企业网络的数据包细致分析,安全团队不仅能识别何时、何地有敏感信息上传至AI平台,更能持续追踪AI服务的使用行为,有效减少潜在的安全隐患。

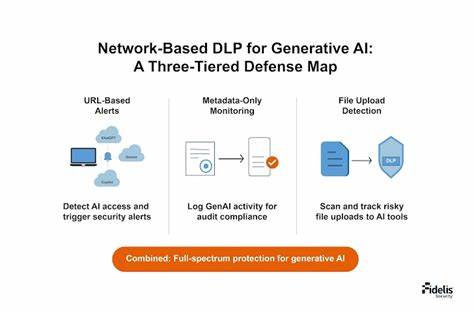

监控生成式AI的核心在于建立跨越端点、网络和应用的多维视角。一种行之有效的做法是基于URL的实时告警机制,管理员可为ChatGPT及类似平台设置访问指标,应用到不同用户组和部门。当检测到访问AI服务时,系统立即发出警报,并抓取对应数据包用于深度分析。此外,通过整合Web和邮件传感器,企业能自动采取阻断或隔离等防护措施,迅速遏制异常行为。实时监控虽然功效显著,但也面临规则维护和高频告警管理的挑战。为缓解安全人员的告警疲劳,采用元数据监控模式成为低噪声环境下的平衡方案。

此方法主要记录与生成式AI交互的会话元信息,包括IP地址、协议、端口及设备信息等,便于事后审计和趋势分析,而不会影响正常业务运作。通过历史数据的分析,企业能够洞察生成式AI使用的演变趋势及潜在风险,为策略调整和合规审核提供依据。文件上传监控则聚焦真实的数据外泄情境。生成式AI平台允许用户上传文件辅助处理,这无疑增加了敏感信息直接泄露的风险。现代NDR解决方案能在文件上传过程即时识别含有个人识别信息(PII)、受保护健康信息(PHI)及企业专有数据的文件。一旦触发相关策略,平台即刻记录完整的会话上下文,确保每一次数据活动都能被追踪和复核。

虽然监控上传文件效果显著,但受限于网络路径的覆盖范围,部分非管理路径上的流量仍难以纳入视野。此外,没有用户身份认证时,溯源最多可定位到设备层面,这也提示企业需结合身份管理系统增强整体安全态势感知。构建全面的生成式AI数据防泄露策略应动态维护最新的AI端点列表,及时更新监控规则以应对快速变化的AI服务及其插件。根据风险等级和业务需求,为不同部门和用户分配适合的监控模式,实现差异化管理。同时,跨部门协作尤为重要,合规和隐私负责人应参与内容规则定义,确保监控合规且不影响用户合法使用。在技术集成层面,生成式AI的网络检测输出应无缝接入安全运营中心(SOC)自动化和资产管理系统,提升事件响应的效率和准确性。

为了强化整体防护,用户教育不可忽视。向员工普及生成式AI使用规范和安全政策,让他们了解监控措施的存在及目的,形成人人参与的安全文化氛围。安全团队还应定期审查政策日志,及时调整策略以应对新兴的AI服务和攻击手段。网络可见性的提升让企业安全架构更具前瞻性和主动性,摆脱以往被动防守的局面。在生成式人工智能高效赋能的同时,网络监控技术能确保敏感数据处于可控状态,支持生产力与安全的和谐共存。企业唯有真正做到对ChatGPT等AI工具的使用情况全程可见,才能从容应对日益复杂的安全威胁,保障信息资产的完整与合规。

展望未来,随着生成式AI应用的不断深入和安全挑战的演变,网络可见性将成为企业数字化转型中不可或缺的一环。通过持续优化检测策略、加强多系统联动和推动安全意识普及,企业能构筑起适应新时代的智能防线。在这场人工智能引领的变革浪潮中,具备高度网络透明度的安全架构将助力企业在技术创新与风险控制之间取得最佳平衡。