随着人工智能技术的迅速发展,大型语言模型(LLMs)在自然语言处理领域的应用变得愈加广泛,其中机器翻译作为重要子领域,一直备受关注。尽管LLMs在生成文本的流畅度和语义理解上展现出了惊人的能力,但在翻译表现上却引发了一些令人意外的发现——研究显示,这些模型如果在翻译前进行过多“思考”甚至反复推敲,翻译质量反而会下降。这个似乎与直觉相悖的现象,正在激发学界与业界对LLMs工作机制的深刻反思。 从表面上看,“先思考再翻译”似乎是提升翻译质量的理想方案。类似人类译者在动笔之前熟悉文本内容、理解语言特点并构思表达方式的过程,LLMs在翻译任务前进行内部推理应当帮助模型消化原文复杂信息,避免直译陷阱。然而根据最新研究和实测数据,LLMs如果不进行任何前置思考,直接输出翻译结果,其表现往往比“预先思考”方式更佳。

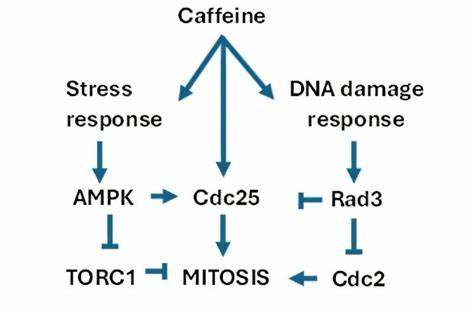

这种令人困惑的结果,从根本上反映了LLMs的生成机制。大型语言模型本质上是基于海量数据训练的概率预测系统,在每一步生成文字时,它们依赖统计规律选择最可能的词汇序列,而非真正理解语义或进行逻辑推理。当引入“预思考”步骤,相当于让模型在生成结果之前先尝试构建复杂的内部分析过程。过多复杂的推理可能反而导致模型“跑偏”,过度聚焦于细节或存在的模糊信息,造成输出的不确定性增加,进而影响整体翻译的准确性和流畅度。 与预先思考形成对比的是“事后思考”方法,即先让模型快速生成初步翻译,再对翻译结果进行批判和润色。虽然人们直觉认为让模型自己检查错误能够提升质量,实际操作中这种方法并没有带来预期的改进。

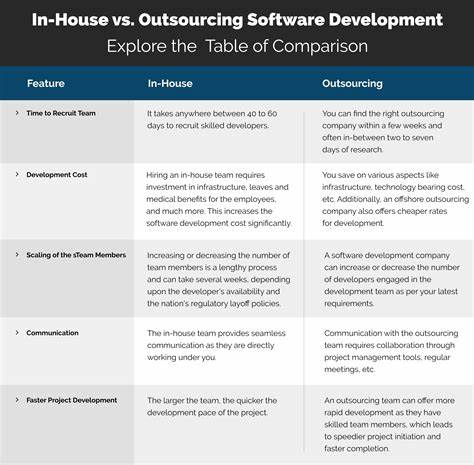

研究数据表明,单一模型进行自我批判反而让翻译水平降低,因为模型在批评过程中也可能犯错,尤其是当批判模型的能力不及初始翻译模型时,劣质反馈会拖累整体表现。甚至将预思考和事后思考结合起来,也未能改善翻译结果,反映了模型在循环推理中潜在的累积误差问题。 多模型集成翻译模式虽然在许多研究与实际应用中被认为是提升翻译品质的有效路径之一,但针对“思考越多,翻译越差”的研究显示,仅仅依赖多模型多轮批判并不能保证翻译更优。实际测试发现,集成多模型的优势主要来自于模型间翻译结果的多样性和综合能力,而非批判阶段的思考过程。更为重要的是,合成翻译的质量显著受制于合成模型的能力水平。高质量的合成模型能对多个模型的输出进行有效整合,从而超越单一模型的表现,但若合成模型水平有限,则难以发挥集成的潜力。

这一发现打破了多模型协同工作中“多思考必有更好结果”的迷思。尽管多模型协同是在自然语言处理领域提升准确度和鲁棒性的重要方式,但如何合理整合模型输出、避免信息噪声叠加和错误传播,成为影响最终翻译质量的关键。 另外,研究还发现,性能较弱的模型若参与集成翻译,不但不会提升整体表现,反而有可能带来负面影响。为此,在多模型协作中筛选和剔除弱势模型成为必要的策略。适当剔除表现不佳的模型,能稍微提升整体翻译质量,尽管这种提升往往未达到统计学显著水平,但仍提示了多模型融合的优化方向。 从应用角度来看,这些研究成果为改进机器翻译工具和用户体验指明了路径。

对于商业翻译服务和学习辅助工具而言,强调快速、直接的翻译生成,而非复杂的多轮思考或反复推敲,更贴近当前LLM技术的工作特性,从而获得更稳定和高质量的翻译成果。同时,高水平的合成模型作为多模型集成的“桥梁”,应受到更多关注和资源投入,促使翻译系统在多样性和准确性之间取得理想平衡。 此外,透过这些现象我们可以更深入理解大型语言模型的本质。它们在“思考”环节的表现差强人意,提醒我们目前的深度学习模型并不具备像人类一样的理解和推理能力,而是高度依赖于统计预测能力。未来若要突破当前性能瓶颈,改进语言模型的推理模块和上下文理解机制将是关键研究方向。 综上所述,大型语言模型在机器翻译中的表现,尤其是在“思考”步骤上的表现,揭示了当前技术应用的局限和潜在方向。

虽然增加前置或者事后“思考”过程的初衷是为了提升质量,实测却显示这些复杂步骤可能抹杀了模型原本的优势。多模型集成通过合理输出合成,仍然是提升翻译品质的有效手段,但关键在于选择合适的合成模型,并避免低质模型的负面影响。未来机器翻译的发展,应关注提升模型本身的语言理解与推理能力,优化集成方法,通过技术创新和理论进步推动智能翻译迈入新阶段。人工智能翻译工具的演进,仍需在简洁高效与准确健壮之间找到最佳平衡,以更好地满足全球用户多样化的语言交流需求。