随着智能交通系统的发展和城市道路管理需求的提升,车辆速度检测技术正发挥着越来越重要的作用。准确测量车辆速度不仅有助于道路安全管理,也促进了交通流量优化和违法行为监测。近年来,基于先进的目标检测技术,特别是YOLO等深度学习模型,实现视频中车辆的实时检测和速度估计成为可能。然而,从检测到的像素速度转换到真实世界的公里每小时速度依然存在挑战,尤其是在摄像头非垂直拍摄道路的情况下。本文将深入分析现代车辆速度检测算法的核心技术、面临的难题以及前沿解决思路,以期为智能交通领域的研究者和工程师提供参考。利用YOLO进行车辆检测与像素速度估计YOLO(You Only Look Once)以其实时性和准确性被广泛用于目标检测。

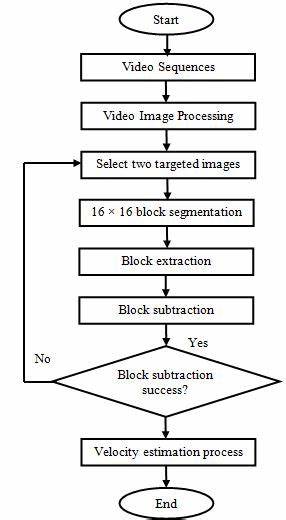

其能快速识别图像或视频中不同类别的目标,包括汽车、卡车、公交车、摩托车等。结合视频帧之间的定位匹配,可以对同一辆车的移动轨迹进行追踪,从而计算出车辆的像素移动速度。这一步的关键是建立稳健的车辆跟踪算法,确保识别的目标在连续帧中得到准确对应。尽管获得车辆在视频中像素级别的速度继而较为直接,但接下来的核心难点是如何将像素速度映射到实际的物理速度上。像素速度到实际速度的转换机理理想情况下,如果摄像头视角恰好与道路垂直,且拍摄距离固定,像素与实际距离的换算率是恒定的。比如Ultralytics的yolo速度检测方案就提出了meter_per_pixel=0.013的换算因子,能将像素速度简单乘上该因子后换算为实际速度(公里/小时)。

这种假设简化了计算流程,适合固定监控位置和视角的道路测速需求,但现实中大部分视频都不是这样理想。摄像头视角错位和透视变形所带来的换算复杂性现实场景中,摄像头往往安装在角度多样的位置,如路口的高架桥、车流交叉口侧边,甚至通过手机等移动设备拍摄。这些非垂直视角使得每个像素在真实世界中对应的距离不再均匀,靠近摄像头的车辆与远处车辆的米/像素比例存在巨大差异。传统单一换算因子难以适用,必须引入更复杂的换算矩阵或者投影变换算法。相关视频资料中提到借助一个像素到米的映射矩阵,按位置动态转换像素速度,实现更加精确的速度估计。一旦能建立针对画面各区域的换算矩阵,就可以校正透视影响,将虚拟速度转到真实速度,提升测量精度。

然而,此方法存在难点在于需要人工标定矩阵,繁琐且易出错,且受测试环境限制大。更理想的是算法能够自动完成矩阵估计,具备更强的泛化能力。自动化换算矩阵构建的潜力与挑战想象一种能自动分析摄像头视角参数、道路结构以及车辆实际尺寸的智能算法,它无需人工标定就能反推出像素与物理世界距离的映射关系。借助摄像机标定技术、多视角三角测量和深度估计方法,可以更准确地实现该目标。例如利用环境中的地标、车道线宽度、车辆实际尺寸等信息,通过图像处理推断距离尺度。或者融合深度神经网络完成直接从图像估计距离变换的任务。

自动换算矩阵不仅提升测量的准确性,也扩大了速度检测算法的适用范围,使无人监管的移动测量成为可能,实现动态视频场景的真实速度检测。目前该领域的研究尚处于探索阶段,需要综合机器视觉、三维重建和统计推断等多个技术领域的突破。动态摄像头与多角度速度检测的意义从固定角度实现车辆速度检测到允许多角度、动态摄像头测量,标志着速度检测算法进入新的应用高度。移动设备如智能手机、无人机的使用让覆盖范围显著扩大,采集的数据更全面,也更具挑战。动态摄像头导致每帧的场景透视和标定参数都可能变化,自动校准和速度换算变得更加迫切。实现这一步不仅可以对整条道路系统局域网内实现全时段多点检测,形成精细化的车流速度分布,提升交通管理效率,也降低了部署成本,使城市交通管理更加灵活智能。

此外,动态场景中的疲劳驾驶检测、异常速度预警等智能应用亦可借助高精度速度估计得以实现。未来发展趋势未来车辆速度检测会借助更强的感知硬件和算法,如高分辨率摄像头、激光雷达与多传感器融合,加上更先进的深度学习模型和计算机视觉算法,实现更加稳定并且无需人工干预的速度测量。场景适应性强、自动标定能力成熟的智能系统将出现。同时,大规模的交通数据采集与云端计算平台相结合,能实现实时大范围的交通态势感知与预测,促进智慧城市交通的落地。总结来看,现代车辆速度检测技术正从单纯依赖简单假设的像素速度换算向多因素自动估计、动态适应性强的智能系统发展。挑战虽多,但潜力巨大。

在不断完善摄像机投影几何模型和深度估计技术的基础上,自动构建像素-米换算矩阵将成为提高速度检测准确率的关键突破口。未来结合多模态传感融合和云计算,将有效解决角度多样、视角复杂下的测量难题,推动智能交通系统迈向更高效、更安全的发展阶段。